AWS IoT Greengrass Version 1 entrou na fase de vida útil prolongada em 30 de junho de 2023. Para obter mais informações, consulte política de manutenção do AWS IoT Greengrass V1. Após essa data, AWS IoT Greengrass V1 não lançaremos atualizações que forneçam recursos, aprimoramentos, correções de erros ou patches de segurança. Os dispositivos que funcionam AWS IoT Greengrass V1 não serão interrompidos e continuarão operando e se conectando à nuvem. É altamente recomendável que você migre para AWS IoT Greengrass Version 2, o que adiciona novos recursos significativos e suporte para plataformas adicionais.

As traduções são geradas por tradução automática. Em caso de conflito entre o conteúdo da tradução e da versão original em inglês, a versão em inglês prevalecerá.

Como configurar a inferência de machine learning usando o AWS Management Console

Para seguir as etapas deste tutorial, você precisa do AWS IoT Greengrass Core v1.10 ou posterior.

Você pode realizar inferência de machine learning (ML) localmente em um dispositivo de núcleo do Greengrass usando dados gerados localmente. Para obter mais informações, inclusive sobre os requisitos e restrições, consulte Executar a inferência de machine learning.

Este tutorial descreve como usar o AWS Management Console para configurar um grupo do Greengrass para executar um aplicativo de inferência Lambda que reconhece imagens de uma câmera localmente, sem enviar dados para a nuvem. O aplicativo de inferência acessa o módulo da câmera em um Raspberry Pi e executa a inferência usando o modelo de código aberto. SqueezeNet

O tutorial contém as seguintes etapas de nível elevado:

Pré-requisitos

Para concluir este tutorial, é necessário:

-

Raspberry Pi 4 Modelo B, ou Raspberry Pi 3 Modelo B/B+, instalado e configurado para uso com. AWS IoT Greengrass Para configurar seu Raspberry Pi com o AWS IoT Greengrass, execute o script Greengrass Device Setup ou conclua o Módulo 1 e o Módulo 2 do Conceitos básicos do AWS IoT Greengrass.

nota

O Raspberry Pi pode exigir uma fonte de alimentação

de 2,5 A para executar as estruturas de aprendizado profundo que normalmente são usadas para classificação de imagens. Uma fonte de alimentação com uma classificação mais baixa pode fazer com que o dispositivo seja reinicializado. -

Módulo de câmera Raspberry Pi V2 - 8 megapixels, 1080 p

. Para obter informações sobre como configurar a câmera, consulte Conectar a câmera na documentação do Raspberry Pi. -

Um grupo do Greengrass e um núcleo do Greengrass. Para obter informações sobre como criar um grupo ou núcleo do Greengrass, consulte Conceitos básicos do AWS IoT Greengrass.

nota

Este tutorial usa um Raspberry Pi, mas AWS IoT Greengrass oferece suporte a outras plataformas, como Intel Atom e NVIDIA Jetson. TX2 No exemplo do Jetson TX2, você pode usar imagens estáticas em vez de imagens transmitidas de uma câmera. Se estiver usando o TX2 exemplo do Jetson, talvez seja necessário instalar o Python 3.6 em vez do Python 3.7. Para obter informações sobre como configurar seu dispositivo para que você possa instalar o software AWS IoT Greengrass Core, consulteConfigurar outros dispositivos.

Para plataformas de terceiros que AWS IoT Greengrass não oferecem suporte, você deve executar sua função Lambda no modo não conteinerizado. Para executar no modo sem contêiner, você deve executar sua função do Lambda como root. Para ter mais informações, consulte Considerações ao escolher a conteinerização de função do Lambda e Definir a identidade de acesso padrão para as funções do Lambda em um grupo.

Etapa 1: Configurar o Raspberry Pi

Nesta etapa, instale as atualizações no sistema operacional Raspbian, instale o software do módulo da câmera e as dependências do Python e ative a interface da câmera.

Execute os seguintes comandos no seu terminal do Raspberry Pi.

-

Instale as atualizações no Raspbian.

sudo apt-get update sudo apt-get dist-upgrade -

Instale a interface do

picamerapara o módulo da câmera e outras bibliotecas do Python que são necessárias para este tutorial.sudo apt-get install -y python3-dev python3-setuptools python3-pip python3-picameraValide a instalação:

-

Verifique se a instalação do Python 3.7 inclui o pip.

python3 -m pipSe o pip não estiver instalado, faça download dele no site do pip

e execute o seguinte comando. python3 get-pip.py -

Verifique se a versão do Python é 3.7 ou superior.

python3 --versionSe a saída listar uma versão anterior, execute o seguinte comando.

sudo apt-get install -y python3.7-dev -

Verifique se o Setuptools e Picamera foram instalados com êxito.

sudo -u ggc_user bash -c 'python3 -c "import setuptools"' sudo -u ggc_user bash -c 'python3 -c "import picamera"'Se a saída não contiver erros, a validação será bem-sucedida.

nota

Se o Python executável instalado no dispositivo for o

python3.7, usepython3.7em vez depython3para os comandos neste tutorial. Verifique se a instalação do pip mapeia para a versão correta dopython3oupython3.7para evitar erros de dependência. -

-

Reinicie o Raspberry Pi.

sudo reboot -

Abra a ferramenta de configuração do Raspberry Pi.

sudo raspi-config -

Use as setas do teclado para abrir Interfacing Options e habilitar a interface da câmera. Se solicitado, permita que o dispositivo seja reinicializado.

-

Use o seguinte comando para testar a configuração da câmera.

raspistill -v -o test.jpgIsso abre uma janela de visualização no Raspberry Pi, salva uma imagem chamada

test.jpgno seu diretório atual e exibe informações sobre a câmera no terminal do Raspberry Pi.

Etapa 2: instalar a MXNet estrutura

Nesta etapa, instale MXNet bibliotecas no seu Raspberry Pi.

-

Inicie sessão no seu Raspberry Pi remotamente.

ssh pi@your-device-ip-address -

Abra a MXNet documentação, abra Instalação MXNet

e siga as instruções para instalar MXNet no dispositivo. nota

Recomendamos instalar a versão 1.5.0 e compilar a MXNet partir do código-fonte para este tutorial para evitar conflitos de dispositivos.

-

Depois de instalar MXNet, valide a seguinte configuração:

-

Certifique-se de que a conta

ggc_userdo sistema possa usar a MXNet estrutura.sudo -u ggc_user bash -c 'python3 -c "import mxnet"' -

Verifique se NumPy está instalado.

sudo -u ggc_user bash -c 'python3 -c "import numpy"'

-

Etapa 3: criar um pacote de MXNet modelo

Nesta etapa, crie um pacote de modelo que contenha uma amostra de MXNet modelo pré-treinado para carregar no Amazon Simple Storage Service (Amazon S3). AWS IoT Greengrass pode usar um pacote de modelo do Amazon S3, desde que você use o formato tar.gz ou zip.

-

No seu computador, baixe a MXNet amostra do Raspberry Pi em. Exemplos de machine learning

-

Não descompacte o arquivo

mxnet-py3-armv7l.tar.gzobtido por download. -

Navegue até o diretório

squeezenet.cdpath-to-downloaded-sample/mxnet-py3-armv7l/models/squeezenetO arquivo

squeezenet.zipneste diretório é o pacote de modelo. Ele contém artefatos de modelo de código SqueezeNet aberto para um modelo de classificação de imagens. Posteriormente, esse pacote de modelo é carregado no Amazon S3.

Etapa 4: Crie e publique uma função do Lambda

Nesta etapa, crie um pacote de implantação da função do Lambda e uma função do Lambda. Depois, publique uma versão da função e crie um alias.

Primeiro, crie o pacote de implantação da função do Lambda.

-

No computador, navegue até o diretório

examplesno pacote de exemplo que você descompactou em Etapa 3: criar um pacote de MXNet modelo.cdpath-to-downloaded-sample/mxnet-py3-armv7l/examplesO diretório

examplescontém código de função e dependências.-

O

greengrassObjectClassification.pyé o código de inferência usado neste tutorial. Você pode usar esse código como modelo para criar sua própria função de inferência. -

greengrasssdké a versão 1.5.0 do SDK do AWS IoT Greengrass Core para Python.nota

Se uma nova versão estiver disponível, você poderá fazer download dela e atualizar a versão do SDK no seu pacote de implantação. Para obter mais informações, consulte AWS IoT Greengrass Core SDK para GitHub Python on

.

-

-

Compacte o conteúdo do diretório

examplesem um arquivo chamadogreengrassObjectClassification.zip. Esse é o pacote de implantação.zip -r greengrassObjectClassification.zip .nota

Verifique se os arquivos

.pye as dependências estão na raiz do diretório.Depois, crie a função do Lambda .

-

No AWS IoT console, escolha Funções e Criar função.

-

Selecione Criar do zero e use os valores a seguir para criar a função:

-

Em Function name (Nome da função), insira

greengrassObjectClassification. -

Em Runtime (Tempo de execução), selecione Python 3.7.

Em Permissões, mantenha a configuração padrão. Isso cria uma função de execução que concede permissões básicas do Lambda. Essa função não é usada por AWS IoT Greengrass.

-

-

Selecione Criar função.

Agora, carregue o seu pacote de implantação da função do Lambda e registre o manipulador.

-

Selecione sua função do Lambda e carregue seu pacote de implantação da função do Lambda.

-

Na guia Código, em Fonte do código, selecione Fazer upload a partir de. No menu suspenso, selecione o arquivo .zip.

-

Selecione Upload e, em seguida, selecione seu pacote de implantação

greengrassObjectClassification.zip. Selecione Salvar. -

Na guia Código da função, em Configurações de runtime, selecione Editar e insira os valores a seguir.

-

Em Runtime (Tempo de execução), selecione Python 3.7.

-

Em Handler (Manipulador), insira

greengrassObjectClassification.function_handler.

Selecione Salvar.

-

Em seguida, publique a primeira versão da sua função do Lambda. Em seguida, crie um alias para a versão.

nota

Os grupos do Greengrass podem fazer referência a uma função do Lambda por alias (recomendado) ou por versão. Usar um alias facilita o gerenciamento de atualizações de código porque você não precisa alterar a tabela de assinaturas nem a definição do grupo ao atualizar a função do código. Em vez disso, você pode simplesmente apontar o alias para a nova versão da função.

-

-

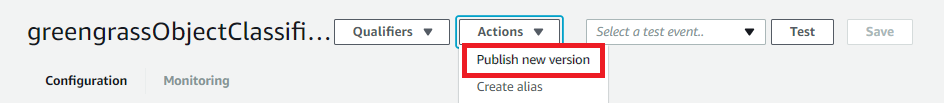

No menu Actions, selecione Publish new version.

-

Em Version description (Descrição da versão), insira

First versione, em seguida, selecione Publish (Publicar). -

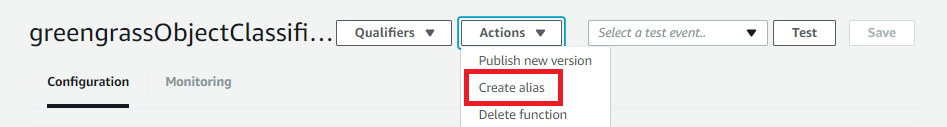

Na página de configuração greengrassObjectClassification: 1, no menu Ações, escolha Criar alias.

-

Na página Create a new alias, use os seguintes valores:

-

Em Nome, digite

mlTest. -

Em Version (Versão), insira

1.

nota

AWS IoT Greengrass não oferece suporte a aliases Lambda para as versões $LATEST.

-

-

Escolha Salvar.

Agora, adicione a função do Lambda ao seu grupo do Greengrass.

Etapa 5: adicionar a função do Lambda ao grupo do Greengrass

Nesta etapa, adicione a função do Lambda ao grupo e configura o ciclo de vida e as variáveis de ambiente.

Primeiro, adicione a função do Lambda ao seu grupo do Greengrass.

-

No painel de navegação do AWS IoT console, em Gerenciar, expanda dispositivos Greengrass e escolha Grupos (V1).

-

Na página de configuração do grupo, selecione a guia Funções do Lambda.

-

Na seção Minhas funções do Lambda, selecione Adicionar.

-

Para a função Lambda, escolha. greengrassObjectClassification

-

Para a Versão da função do Lambda, selecione Alias:mlTest.

Em seguida, configure o ciclo de vida e as variáveis de ambiente da função do Lambda.

-

Na seção Configuração da função do Lambda, faça as atualizações a seguir.

nota

Recomendamos que você execute sua função do Lambda sem conteinerização, a menos que seu caso de negócios faça essa exigência. Isso ajuda a habilitar o acesso à GPU e à câmera do seu dispositivo sem configurar os recursos do dispositivo. Se você executa sem conteinerização, também deve conceder acesso root às suas funções do Lambda AWS IoT Greengrass .

-

Para executar sem conteinerização:

-

Para Usuário e grupo do sistema, selecione

Another user ID/group ID. Para ID de usuário do sistema, insira0. Para ID do grupo do sistema, insira0.Isso permite que sua função do Lambda seja executada como root. Para obter mais informações sobre como executar como raiz, consulte Definir a identidade de acesso padrão para as funções do Lambda em um grupo.

dica

Você também deve atualizar seu arquivo

config.jsonpara conceder acesso root à sua função do Lambda. Para o procedimento, consulte Executar uma função do Lambda como raiz. -

Para conteinerização da função do Lambda, selecione Sem contêiner.

Para obter mais informações sobre como executar sem conteinerização, consulte Considerações ao escolher a conteinerização de função do Lambda.

-

Em Timeout (Tempo limite), insira

10 seconds. -

Para Fixado, selecione Verdadeiro.

Para obter mais informações, consulte Configuração do ciclo de vida das funções do Lambda do Greengrass.

-

-

Em vez disso, para executar no modo conteinerizado:

nota

Não recomendamos a execução no modo conteinerizado, a menos que seu caso de negócios faça essa exigência.

-

Para Usuário e grupo do sistema, selecione Usar padrão de grupo.

-

Para Conteinerização da função do Lambda, selecione Usar padrão de grupo.

-

Em Memory limit (Limite de memória), insira

96 MB. -

Em Timeout (Tempo limite), insira

10 seconds. -

Para Fixado, selecione Verdadeiro.

Para obter mais informações, consulte Configuração do ciclo de vida das funções do Lambda do Greengrass.

-

-

-

Em Environment variables (Variáveis de ambiente), crie um par de chave/valor. Um par de valores-chave é exigido por funções que interagem com MXNet modelos em um Raspberry Pi.

Na chave, use MXNET_ENGINE_TYPE. Para o valor, use NaiveEngine.

nota

Se preferir, nas suas próprias funções do Lambda definidas pelo usuário, é possível definir a variável de ambiente no código da função.

-

Mantenha os valores padrão para todas as outras propriedades e selecione Adicionar função do Lambda.

Etapa 6: Adicionar recursos ao grupo do Greengrass

Nesta etapa, crie recursos para o módulo da câmera e o modelo de inferência de ML e afilie os recursos com a função do Lambda. Isso possibilita que a função do Lambda acesse os recursos no dispositivo básico.

nota

Se você executar no modo não conteinerizado, AWS IoT Greengrass poderá acessar a GPU e a câmera do dispositivo sem configurar esses recursos do dispositivo.

Primeiro, crie dois recursos de dispositivos locais para a câmera: um para memória compartilhada e outro para a interface do dispositivo. Para obter mais informações sobre acesso a recursos locais, consulte Acesso aos recursos locais com funções e conectores do Lambda.

-

Na página de configuração do grupo, selecione a guia Recursos.

-

Na seção Recursos locais, selecione Adicionar recurso local.

-

Na página Adicionar recurso local, use os seguintes valores:

-

Em Resource Name (Nome do recurso), insira

videoCoreSharedMemory. -

Em Resource type, selecione Device.

-

Em Caminho do dispositivo local, insira

/dev/vcsm.O caminho do dispositivo é o caminho absoluto local do recurso do dispositivo. Este caminho só pode se referir a um dispositivo de caractere ou dispositivo de blocos em

/dev. -

Em Permissões do proprietário do grupo do sistema e de acesso a arquivos, selecione Adicionar automaticamente permissões de sistema de arquivos do grupo do sistema que é proprietário do recurso.

A opção Proprietário do grupo do sistema e permissões de acesso ao arquivo permite conceder permissões adicionais de acesso a arquivos para o processo do Lambda. Para obter mais informações, consulte Permissão de acesso a arquivo do proprietário do grupo.

-

-

Em seguida, você adiciona um recurso de dispositivo local para a interface da câmera.

-

Selecione Adicionar recurso local.

-

Na página Adicionar recurso local, use os seguintes valores:

-

Em Resource Name (Nome do recurso), insira

videoCoreInterface. -

Em Resource type, selecione Device.

-

Em Caminho do dispositivo local, insira

/dev/vchiq. -

Em Permissões do proprietário do grupo do sistema e de acesso a arquivos, selecione Adicionar automaticamente permissões de sistema de arquivos do grupo do sistema que é proprietário do recurso.

-

-

Na parte inferior da página, selecione Adicionar recurso.

Agora, adicione o modelo de inferência como um recurso de machine learning. Esta etapa inclui o upload do pacote de modelo squeezenet.zip para o Amazon S3.

-

Na guia Recursos do seu grupo, na seção Machine Learning, selecione Adicionar recurso de machine learning.

-

Na página Adicionar recurso de machine learning, em Nome do recurso, insira

squeezenet_model. -

Em Fonte do modelo, selecione Usar um modelo armazenado no S3, como um modelo otimizado por meio do compilador de aprendizado profundo.

-

Para S3 URI, insira um caminho em que o bucket do S3 seja salvo.

-

Selecione Browse S3 (Navegar no S3). Isso abre uma nova guia no console do Amazon S3.

-

Na guia do console do Amazon S3, faça upload do arquivo

squeezenet.zipem um bucket do S3. Para obter informações, consulte Como carregar arquivos e pastas em um bucket do S3? no Guia do usuário do Amazon Simple Storage Service.nota

Para que o bucket do S3 seja acessível, o nome do bucket deve conter a string

greengrasse o bucket deve estar na mesma região em que você usa o AWS IoT Greengrass. Selecione um nome exclusivo (comogreengrass-bucket-). Não use ponto (user-id-epoch-time.) no nome do bucket. -

Na guia AWS IoT Greengrass console, localize e escolha seu bucket do S3. Localize o arquivo

squeezenet.zipcarregado e, em seguida selecione Select (Selecionar). Talvez seja necessário escolher Refresh (Atualizar) para atualizar a lista de buckets e arquivos disponíveis. -

Para Destination path (Caminho de destino), insira

/greengrass-machine-learning/mxnet/squeezenet.Este é o destino do modelo local no namespace de runtime do Lambda. Quando você implanta o grupo, AWS IoT Greengrass recupera o pacote do modelo de origem e, em seguida, extrai o conteúdo para o diretório especificado. O exemplo da função do Lambda para este tutorial já está configurado para usar este caminho (na variável

model_path). -

Em Proprietário do grupo do sistema e permissões de acesso ao arquivo, selecione Sem grupo do sistema.

-

Selecione Adicionar recurso.

Usando modelos treinados em SageMaker IA

Este tutorial usa um modelo armazenado no Amazon S3, mas você também pode usar modelos de SageMaker IA com facilidade. O AWS IoT Greengrass console tem integração de SageMaker IA integrada, então você não precisa fazer o upload manual desses modelos para o Amazon S3. Para requisitos e limitações do uso de modelos de SageMaker IA, consulteFontes de modelo compatíveis.

Para usar um modelo de SageMaker IA:

-

Em Fonte do modelo, escolha Usar um modelo treinado em AWS SageMaker IA e, em seguida, escolha o nome do trabalho de treinamento do modelo.

-

Em Caminho de destino, insira o caminho para o diretório em que sua função do Lambda procura o modelo.

Etapa 7: Adicionar uma assinatura ao grupo do Greengrass

Nesta etapa, adicione uma assinatura ao grupo. Essa assinatura permite que a função Lambda envie resultados de previsão AWS IoT publicando em um tópico do MQTT.

-

Na página de configuração do grupo, selecione a guia Assinaturas e, em seguida, Adicionar assinatura.

-

Na página de Detalhes da assinatura, configure a origem e o destino, da seguinte forma:

-

Em Tipo de fonte, escolha Função Lambda e, em seguida, escolha. greengrassObjectClassification

-

Em Tipo de destino, selecione Serviços e, em seguida, IoT Cloud.

-

-

Em Filtro de tópicos, insira

hello/worlde, em seguida, selecione Criar assinatura.

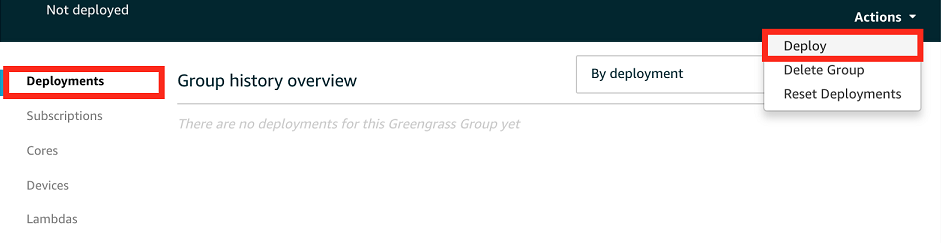

Etapa 8: Implantar o grupo do Greengrass

Nesta etapa, implante a versão atual da definição do grupo ao dispositivo de núcleo do Greengrass. A definição contém a função do Lambda, recursos e configurações de inscrição que você adicionou.

-

Certifique-se de que o AWS IoT Greengrass núcleo esteja funcionando. Execute os seguintes comandos no seu terminal do Raspberry Pi, conforme necessário.

Para verificar se o daemon está em execução:

ps aux | grep -E 'greengrass.*daemon'Se a saída contém uma entrada

rootpara/greengrass/ggc/packages/1.11.6/bin/daemon, o daemon está em execução.nota

A versão no caminho depende da versão do software AWS IoT Greengrass principal que está instalada em seu dispositivo principal.

Para iniciar o daemon:

cd /greengrass/ggc/core/ sudo ./greengrassd start

-

Na página de configuração do grupo, selecione Implantar.

-

Na guia Funções do Lambda, na seção Funções do sistema Lambda, selecione Detector de IP e, em seguida selecione Editar.

-

Na caixa de diálogo Editar configurações do detector IP, selecione Detectar e substituir automaticamente os endpoints do corretor MQTT.

-

Selecione Salvar.

Isso permite que os dispositivos adquiram automaticamente as informações de conectividade para o núcleo, como endereço IP, DNS e o número da porta. A detecção automática é recomendada, mas AWS IoT Greengrass também oferece suporte a endpoints especificados manualmente. Você só é solicitado pelo método de descoberta na primeira vez em que o grupo for implantado.

nota

Se solicitado, conceda permissão para criar a função de serviço do Greengrass e associá-la à Conta da AWS sua na atual. Região da AWS Essa função permite AWS IoT Greengrass acessar seus recursos em AWS serviços.

A página Deployments mostra a data e hora, ID de versão e status da implantação. Quando concluída, o status exibido para a implantação deve ser Concluída.

Para obter mais informações sobre implantações, consulte Implantar grupos do AWS IoT Greengrass em um núcleo do AWS IoT Greengrass. Para obter ajuda sobre a solução de problemas, consulte Solução de problemas de AWS IoT Greengrass.

Etapa 9: Testar o aplicativo de inferência

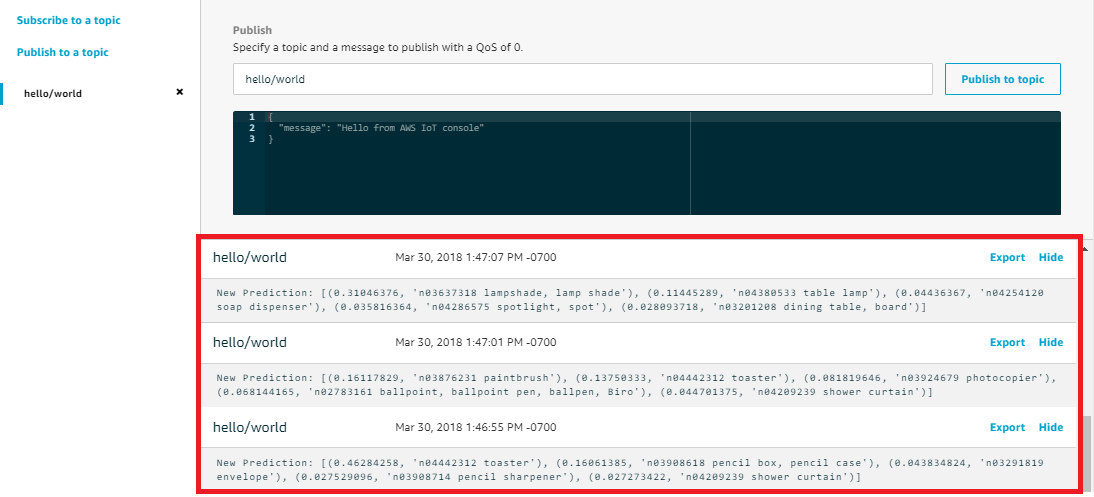

Agora você pode verificar se a implementação foi configurada corretamente. Para testar, inscreva-se no tópico hello/world e visualize os resultados de previsões publicados pela função do Lambda.

nota

Se um monitor estiver conectado ao Raspberry Pi, o feed da câmera ao vivo será exibido em uma janela de visualização.

-

No AWS IoT console, em Teste, escolha Cliente de teste MQTT.

-

Para Subscriptions, use os seguintes valores:

-

No tópico de assinatura, use hello/world.

-

Em Configuração adicional, para Exibição da carga útil do MQTT, selecione Exibir cargas úteis como strings.

-

-

Selecione Subscribe.

Se o teste for bem-sucedido, as mensagens da função do função do Lambda serão exibidas na parte inferior da página. Cada mensagem contém os cinco principais resultados de previsão da imagem, usando o formato: probabilidade, ID da classe prevista e nome da classe correspondente.

Solução de problemas de inferência AWS IoT Greengrass de ML

Se o teste não for bem-sucedido, você poderá tentar as etapas de solução de problemas a seguir. Execute os comandos no seu terminal Raspberry Pi.

Verificar logs de erros

-

Alterne para o usuário raiz e navegue até o diretório

log. O acesso aos AWS IoT Greengrass registros requer permissões de root.sudo su cd /greengrass/ggc/var/log -

No diretório

system, verifiqueruntime.logoupython_runtime.log.No diretório

user/, verifiqueregion/account-idgreengrassObjectClassification.log.Para obter mais informações, consulte Solução de problemas com logs.

Erro "Unpacking" em runtime.log

Se runtime.log contiver um erro semelhante ao seguinte, verifique se o pacote de modelos de origem tar.gz tem um diretório pai.

Greengrass deployment error: unable to download the artifact model-arn: Error while processing.

Error while unpacking the file from /tmp/greengrass/artifacts/model-arn/path to /greengrass/ggc/deployment/path/model-arn,

error: open /greengrass/ggc/deployment/path/model-arn/squeezenet/squeezenet_v1.1-0000.params: no such file or directorySe seu pacote não tiver um diretório pai que contenha os arquivos de modelo, use o comando a seguir para tentar empacotar o modelo novamente:

tar -zcvf model.tar.gz ./model

Por exemplo:

─$tar -zcvf test.tar.gz ./test./test ./test/some.file ./test/some.file2 ./test/some.file3

nota

Não inclui caracteres /* finais neste comando.

Verifique se a função do Lambda é implantada com sucesso

-

Liste o conteúdo do Lambda implementado no diretório

/lambda. Substitua os valores de espaço reservado antes de executar o comando.cd /greengrass/ggc/deployment/lambda/arn:aws:lambda:region:account:function:function-name:function-versionls -la -

Verifique se o diretório contém o mesmo conteúdo do pacote de implantação

greengrassObjectClassification.zipque você carregou no Etapa 4: Crie e publique uma função do Lambda.Verifique se os arquivos

.pye as dependências estão na raiz do diretório.

Verifique se o modelo de inferência é implantado com sucesso

-

Encontre o número de identificação de processo (PID) do runtime do Lambda:

ps aux | grep 'lambda-function-name*'Na saída, o PID aparece na segunda coluna da linha para o processo de runtime do Lambda.

-

Digite o namespace de runtime do Lambda. Certifique-se de substituir o

pidvalor do espaço reservado antes de executar o comando.nota

Este diretório e seu conteúdo estão no namespace de runtime do Lambda para que não sejam visíveis em um namespace comum do Linux.

sudo nsenter -tpid-m /bin/bash -

Liste o conteúdo do diretório local que você especificou para o recurso de ML.

cd /greengrass-machine-learning/mxnet/squeezenet/ ls -lsVocê deve ver os arquivos a seguir:

32 -rw-r--r-- 1 ggc_user ggc_group 31675 Nov 18 15:19 synset.txt 32 -rw-r--r-- 1 ggc_user ggc_group 28707 Nov 18 15:19 squeezenet_v1.1-symbol.json 4832 -rw-r--r-- 1 ggc_user ggc_group 4945062 Nov 18 15:19 squeezenet_v1.1-0000.params

Próximas etapas

Em seguida, explore outros aplicativos de inferência. AWS IoT Greengrass fornece outras funções do Lambda que você pode usar para testar a inferência local. Você pode encontrar o pacote de exemplos na pasta de bibliotecas pré-compiladas que você obteve por download Etapa 2: instalar a MXNet estrutura.

Como configurar um Intel Atom

Para executar este tutorial em um dispositivo Intel Atom, você deve fornecer imagens de origem, configurar a função do Lambda e adicionar outro recurso de dispositivo local. Para usar a GPU para inferência, verifique se o software a seguir está instalado no dispositivo:

-

OpenCL versão 1.0 ou posterior

-

Python 3.7 e pip

nota

Se o dispositivo for pré-construído com o Python 3.6, você poderá criar um symlink para o Python 3.7. Para obter mais informações, consulte Passo 2.

-

Faça download de imagens PNG ou JPG estáticas para a função do Lambda para usá-las na classificação de imagens. O exemplo funciona melhor com arquivos de imagem pequenos.

Salve os arquivos de imagem no diretório que contém o arquivo

greengrassObjectClassification.py(ou em um subdiretório desse diretório). Isso está no pacote de implantação da função do Lambda do qual você fez upload em Etapa 4: Crie e publique uma função do Lambda.nota

Se estiver usando AWS DeepLens, você pode usar a câmera integrada ou montar sua própria câmera para realizar inferência em imagens capturadas em vez de imagens estáticas. No entanto, recomendamos que você comece com imagens estáticas primeiro.

Se utilizar uma câmara, verifique se o pacote APT

awscamestá instalado e atualizado. Para mais informações, consulte Atualizar seu dispositivo AWS DeepLens no Guia do desenvolvedor AWS DeepLens . -

Se você não estiver usando o Python 3.7, crie um symlink do Python 3.x para o Python 3.7. Isso configura seu dispositivo para usar o Python 3 com. AWS IoT Greengrass Execute o seguinte comando para localizar a instalação do Python:

which python3Execute o comando a seguir para criar o symlink:

sudo ln -spath-to-python-3.x/python3.xpath-to-python-3.7/python3.7Reinicie o dispositivo.

-

Edite a configuração da função do Lambda. Siga o procedimento em Etapa 5: adicionar a função do Lambda ao grupo do Greengrass.

nota

Recomendamos que você execute sua função do Lambda sem conteinerização, a menos que seu caso de negócios faça essa exigência. Isso ajuda a habilitar o acesso à GPU e à câmera do seu dispositivo sem configurar os recursos do dispositivo. Se você executa sem conteinerização, também deve conceder acesso root às suas funções do Lambda AWS IoT Greengrass .

-

Para executar sem conteinerização:

-

Para Usuário e grupo do sistema, selecione

Another user ID/group ID. Para ID de usuário do sistema, insira0. Para ID do grupo do sistema, insira0.Isso permite que sua função do Lambda seja executada como root. Para obter mais informações sobre como executar como raiz, consulte Definir a identidade de acesso padrão para as funções do Lambda em um grupo.

dica

Você também deve atualizar seu arquivo

config.jsonpara conceder acesso root à sua função do Lambda. Para o procedimento, consulte Executar uma função do Lambda como raiz. -

Para Conteinerização da função do Lambda, selecione Sem contêiner.

Para obter mais informações sobre como executar sem conteinerização, consulte Considerações ao escolher a conteinerização de função do Lambda.

-

Atualize o valor de Tempo limite para 5 segundos. Isso garante que a solicitação não expire muito cedo. Leva alguns minutos para que a inferência seja executada após a configuração.

-

Em Fixado, selecione Verdadeiro.

-

Em Parâmetros adicionais, para Acesso de leitura ao diretório /sys), selecione Habilitado.

-

Em Lambda lifecycle (Ciclo de vida Lambda), selecione Make this function long-lived and keep it running indefinitely (Definir esta função de longa duração e mantê-la em execução indefinidamente).

-

-

Em vez disso, para executar no modo conteinerizado:

nota

Não recomendamos a execução no modo conteinerizado, a menos que seu caso de negócios faça essa exigência.

-

Atualize o valor de Tempo limite para 5 segundos. Isso garante que a solicitação não expire muito cedo. Leva alguns minutos para que a inferência seja executada após a configuração.

-

Para Fixado, selecione Verdadeiro.

-

Em Parâmetros adicionais, para Acesso de leitura ao diretório /sys, selecione Habilitado.

-

-

-

Se estiver executando no modo conteinerizado, adicione o recurso de dispositivo local necessário para conceder acesso à GPU do seu dispositivo.

nota

Se você executar no modo não conteinerizado, AWS IoT Greengrass poderá acessar a GPU do seu dispositivo sem configurar os recursos do dispositivo.

-

Na página de configuração do grupo, selecione a guia Recursos.

-

Selecione Adicionar recurso local.

-

Defina o recurso:

-

Em Resource Name (Nome do recurso), insira

renderD128. -

Em Tipo de recurso, selecione Dispositivo local.

-

Em Device path (Caminho do dispositivo), insira

/dev/dri/renderD128. -

Em Permissões do proprietário do grupo do sistema e de acesso a arquivos, selecione Adicionar automaticamente permissões de sistema de arquivos do grupo do sistema que é proprietário do recurso.

-

Para Afiliações da função do Lambda, conceda a permissão Acesso para leitura e gravação para sua função Lambda.

-

-

Configurando um NVIDIA Jetson TX2

Para executar este tutorial em um NVIDIA Jetson TX2, forneça imagens de origem e configure a função Lambda. Se estiver usando a GPU, você também deverá adicionar recursos do dispositivo local.

-

Certifique-se de que seu dispositivo Jetson esteja configurado para que você possa instalar o software AWS IoT Greengrass Core. Para obter mais informações sobre como configurar seu projeto, consulte Configurar outros dispositivos.

-

Abra a MXNet documentação, acesse Instalando MXNet em um Jetson

e siga as instruções para instalar MXNet no dispositivo Jetson. nota

Se você quiser criar a MXNet partir do código-fonte, siga as instruções para criar a biblioteca compartilhada. Edite as seguintes configurações em seu

config.mkarquivo para trabalhar com um TX2 dispositivo Jetson:-

Adicione

-gencode arch=compute-62, code=sm_62àCUDA_ARCHconfiguração. -

Ligue o CUDA.

USE_CUDA = 1

-

-

Faça download de imagens PNG ou JPG estáticas para a função do Lambda para usá-las na classificação de imagens. O aplicativo funciona melhor com arquivos de imagem pequenos. Se preferir, é possível instrumentar uma câmera na placa Jetson para capturar as imagens de origem.

Salve seus arquivos de imagem no diretório que contém o arquivo

greengrassObjectClassification.py. Você também pode salvá-los em um subdiretório desse diretório. Esse diretório está no pacote de implantação da função do Lambda do qual você fez upload em Etapa 4: Crie e publique uma função do Lambda. -

Crie um link simbólico do Python 3.7 para o Python 3.6 para usar o Python 3 com o. AWS IoT Greengrass Execute o seguinte comando para localizar a instalação do Python:

which python3Execute o comando a seguir para criar o symlink:

sudo ln -spath-to-python-3.6/python3.6path-to-python-3.7/python3.7Reinicie o dispositivo.

-

Certifique-se de que a conta

ggc_userdo sistema possa usar a MXNet estrutura:“sudo -u ggc_user bash -c 'python3 -c "import mxnet"' -

Edite a configuração da função do Lambda. Siga o procedimento em Etapa 5: adicionar a função do Lambda ao grupo do Greengrass.

nota

Recomendamos que você execute sua função do Lambda sem conteinerização, a menos que seu caso de negócios faça essa exigência. Isso ajuda a habilitar o acesso à GPU e à câmera do seu dispositivo sem configurar os recursos do dispositivo. Se você executa sem conteinerização, também deve conceder acesso root às suas funções do Lambda AWS IoT Greengrass .

-

Para executar sem conteinerização:

-

Para Usuário e grupo do sistema, selecione

Another user ID/group ID. Para ID de usuário do sistema, insira0. Para ID do grupo do sistema, insira0.Isso permite que sua função do Lambda seja executada como root. Para obter mais informações sobre como executar como raiz, consulte Definir a identidade de acesso padrão para as funções do Lambda em um grupo.

dica

Você também deve atualizar seu arquivo

config.jsonpara conceder acesso root à sua função do Lambda. Para o procedimento, consulte Executar uma função do Lambda como raiz. -

Para conteinerização da função do Lambda, selecione Sem contêiner.

Para obter mais informações sobre como executar sem conteinerização, consulte Considerações ao escolher a conteinerização de função do Lambda.

-

Em Parâmetros adicionais, para Acesso de leitura ao diretório /sys, selecione Habilitado.

-

Em Variáveis de ambiente, adicione os seguintes pares chave-valor à sua função do Lambda. Isso configura AWS IoT Greengrass para usar a MXNet estrutura.

Chave

Valor

PATH

/usr/local/cuda/bin: $PATH

MXNET_HOME

$HOME/mxnet/

PYTHONPATH

$MXNET_HOME/python:$PYTHONPATH

CUDA_HOME

/usr/local/cuda

LD_LIBRARY_PATH

$LD_LIBRARY_PATH:${CUDA_HOME}/lib64

-

-

Em vez disso, para executar no modo conteinerizado:

nota

Não recomendamos a execução no modo conteinerizado, a menos que seu caso de negócios faça essa exigência.

-

Aumente o valor de Memory limit (Limite de memória). Use 500 MB para a CPU ou pelo menos 2000 MB para a GPU.

-

Em Parâmetros adicionais, para Acesso de leitura ao diretório /sys, selecione Habilitado.

-

Em Variáveis de ambiente, adicione os seguintes pares chave-valor à sua função do Lambda. Isso configura AWS IoT Greengrass para usar a MXNet estrutura.

Chave

Valor

PATH

/usr/local/cuda/bin: $PATH

MXNET_HOME

$HOME/mxnet/

PYTHONPATH

$MXNET_HOME/python:$PYTHONPATH

CUDA_HOME

/usr/local/cuda

LD_LIBRARY_PATH

$LD_LIBRARY_PATH:${CUDA_HOME}/lib64

-

-

-

Se estiver executando no modo conteinerizado, adicione os recursos de dispositivo local a seguir para conceder acesso à GPU do seu dispositivo. Siga o procedimento em Etapa 6: Adicionar recursos ao grupo do Greengrass.

nota

Se você executar no modo não conteinerizado, AWS IoT Greengrass poderá acessar a GPU do seu dispositivo sem configurar os recursos do dispositivo.

Para cada recurso:

-

Em Resource type, selecione Device.

-

Em Permissões do proprietário do grupo do sistema e de acesso a arquivos, selecione Adicionar automaticamente permissões de sistema de arquivos do grupo do sistema que é proprietário do recurso.

Name

Caminho do dispositivo

nvhost-ctrl

/dev/nvhost-ctrl

nvhost-gpu

/dev/nvhost-gpu

nvhost-ctrl-gpu

/dev/ nvhost-ctrl-gpu

nvhost-dbg-gpu

/dev/ nvhost-dbg-gpu

nvhost-prof-gpu

/dev/ nvhost-prof-gpu

nvmap

/dev/nvmap

nvhost-vic

/dev/nvhost-vic

tegra_dc_ctrl

/dev/tegra_dc_ctrl

-

-

Se estiver executando no modo conteinerizado, adicione o recurso de volume local a seguir para conceder acesso à câmera do seu dispositivo. Siga o procedimento em Etapa 6: Adicionar recursos ao grupo do Greengrass.

nota

Se você executar no modo não conteinerizado, AWS IoT Greengrass poderá acessar a câmera do seu dispositivo sem configurar os recursos de volume.

-

Em Tipo de recurso, selecione Volume.

-

Em Permissões do proprietário do grupo do sistema e de acesso a arquivos, selecione Adicionar automaticamente permissões de sistema de arquivos do grupo do sistema que é proprietário do recurso.

Name

Caminho de origem

Caminho de destino

shm

/dev/shm

/dev/shm

.tmp

/tmp

/tmp

-