本文為英文版的機器翻譯版本,如內容有任何歧義或不一致之處,概以英文版為準。

使用處理工作執行資料轉換工作負載

SageMaker 處理 SageMaker是指在完全受管理的基礎結構上執行資料前後處理、功能工程和模型評估工作 SageMaker的能力。這些工作會當做處理工作執行。使用 Process API,資料科學家可以執行指令碼和筆記本來處 SageMaker 理、轉換和分析資料集,為機器學習做好準備。當與訓練和託管等提供的其他重要機器學習任務結合使用時,處理可為您提供完全受控的機器學習環境的優點,包括內建的所有安全性與合規性支援 SageMaker。 SageMaker您可以彈性地使用內建資料處理容器,或將自己的容器帶入自訂處理邏輯,然後提交工作以在 SageMaker 受管理的基礎結構上執行。

注意

您可以使用支援的任何語言呼叫「CreateProcessingJob API」動作,以程式設計方 SageMaker 式建立處理工作 AWS CLI。有關此 API 動作如何以您選擇的語言轉換為函數的詳細資訊,請參閱的「另請參閱」一節 CreateProcessingJob 並選擇 SDK。例如,對於 Python 用戶,請參閱 SageMaker Python 開發套件的 Amazon SageMaker 處理

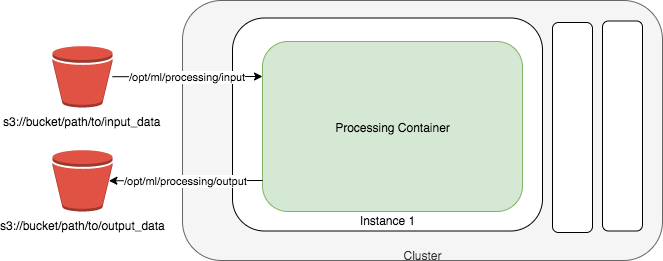

下圖顯示 Amazon 如何 SageMaker 加速處理任務。Amazon SageMaker 接受您的腳本,從亞馬遜簡單存儲服務(Amazon S3)複製數據,然後提取處理容器。處理任務的基礎設施由 Amazon 完全管理 SageMaker。提交處理工作後, SageMaker 啟動運算執行個體、處理和分析輸入資料,並在完成時釋放資源。處理任務的輸出會存放在您所指定的 Amazon S3 儲存貯體中。

注意

您的輸入資料必須存放在 Amazon S3 儲存貯體中。或者,您也可以使用 Amazon Athena 或 Amazon Redshift 作為輸入來源。

提示

若要了解機器學習 (ML) 訓練及處理任務的分散式運算的最佳實務,請參閱 SageMaker 最佳實務的分散式運算。

使用 Amazon SageMaker 處理範例筆記本

我們提供兩個範例 Jupyter 筆記本,說明如何執行資料預處理、模型評估或同時執行兩者。

如需範例筆記本,其中示範如何執行 scikit-learn 指令碼以執行資料預先處理,以及使用 SageMaker Python SDK 進行處理的模型訓練與評估,請參閱 scikit-learn 處理。

如需示範如何使用 Amazon SageMaker 處理透過 Spark 執行分散式資料預先處理的範例筆記本,請參閱分散式處理 (Spark)

如需如何建立及存取 Jupyter 筆記本執行個體 (您可以在中執行這些範例) 的指示 SageMaker,請參閱。Amazon SageMaker 筆記本實建立筆記本執行個體並開啟之後,請選擇 [SageMaker 範例] 索引標籤以查看所有 SageMaker 範例的清單。若要開啟筆記本,請選擇其使用標籤,然後選擇建立複本。

使用 CloudWatch 日誌和指標監控 Amazon SageMaker 處理任務

Amazon SageMaker 處理提供 Amazon CloudWatch 日誌和指標來監控處理任務。 CloudWatch 提供 CPU、GPU、記憶體、GPU 記憶體和磁碟指標,以及事件記錄。如需更多詳細資訊,請參閱 監控 Amazon SageMaker 與 Amazon CloudWatch 及 記錄 Amazon SageMaker 活動與 Amazon CloudWatch。