기계 번역으로 제공되는 번역입니다. 제공된 번역과 원본 영어의 내용이 상충하는 경우에는 영어 버전이 우선합니다.

Amazon SageMaker AI에서 강화 학습 사용

강화형 기계 학습(RL)은 컴퓨터 과학, 신경과학, 심리학 등의 분야를 결합하여 상황을 행동에 매핑하여 수치적 보상 신호를 최대화하는 방법을 결정합니다. RL의 보상 신호에 대한 이러한 개념은 인간의 뇌가 어떤 행동이 보상을 극대화하고 처벌을 최소화하는지 결정을 내리는 방법을 연구하는 신경과학 연구에서 비롯되었습니다. 대부분의 상황에서 인간은 어떤 행동을 취해야 하는지에 대한 명확한 지시를 받지 않고, 어떤 행동이 가장 즉각적인 보상을 가져오는지, 그리고 그러한 행동이 미래의 상황과 결과에 어떤 영향을 미치는지 모두 학습해야 합니다.

RL 문제는 역학 시스템 이론에서 비롯된 마르코프 의사 결정 프로세스(MDP)를 사용하여 공식화됩니다. MDP는 훈련 에이전트가 최종 목표를 달성하기 위해 일정 기간 동안 부딪히는 실제 문제에 대한 세부 정보를 높은 수준으로 캡처하는 것을 목표로 합니다. 훈련 에이전트는 환경의 현재 상태를 파악하고 훈련 에이전트의 현재 상태에 영향을 줄 수 있는 가능한 조치를 식별할 수 있어야 합니다. 또한 훈련 에이전트의 목표는 환경 상태와 밀접한 상관 관계가 있어야 합니다. 이러한 방식으로 구성된 문제의 해결 방법을 강화형 기계 학습 방법이라고 합니다.

강화형 기계 학습 패러다임, 지도 학습 패러다임, 비지도 학습 패러다임의 차이점은 무엇입니까?

기계 훈련은 지도 훈련, 비지도 훈련, 강화라는 세 가지 훈련 패러다임으로 나눌 수 있습니다.

지도 학습에서는 외부 감독자가 레이블이 지정된 예제로 구성된 훈련 세트를 제공합니다. 각 예제는 상황에 대한 정보를 포함하고, 범주에 속하며, 해당 범주를 식별하는 레이블이 있습니다. 지도 학습의 목표는 훈련 데이터에 없는 상황을 정확하게 예측하기 위해 일반화하는 것입니다.

반면, RL은 대화형 문제를 다루기 때문에 상담원이 접할 수 있는 올바른 레이블이 있는 상황의 가능한 모든 예를 컬렉션하는 것은 불가능합니다. 이러한 유형의 훈련은 상담원이 자신의 경험을 통해 정확하게 훈련하고 그에 따라 조정할 수 있을 때 가장 가능성이 높습니다.

비지도 학습에서 에이전트는 레이블이 지정되지 않은 데이터 내의 구조를 발견하여 학습합니다. RL 에이전트는 경험을 바탕으로 구조를 찾아내는 것이 도움이 될 수 있지만 RL의 유일한 목적은 보상 신호를 극대화하는 것입니다.

주제

강화 학습이 중요한 이유는 무엇입니까?

RL은 공급망 관리, HVAC 시스템, 산업용 로봇, 게임 인공 지능, 대화 시스템, 자율 주행 차량과 같은 크고 복잡한 문제를 해결하는 데 매우 적합합니다. RL 모델은 에이전트가 취하는 모든 행동에 대해 보상과 처벌을 받는 연속 프로세스를 통해 학습하기 때문에 동적인 환경에서 불확실성이 존재할 때 시스템이 의사를 결정하도록 훈련할 수 있습니다.

마코프 의사결정 과정(MDP)

RL은 마코프 의사결정 과정(MDP)라는 모델을 기반으로 합니다. MDP는 일련의 시간 단계로 구성됩니다. 각 시간 단계는 다음과 같은 요소로 구성됩니다.

- 환경

-

RL 모델이 작동하는 공간을 정의합니다. 이러한 공간은 실제 환경 또는 시뮬레이터일 수 있습니다. 예를 들어, 실제 도로에서 자율 주행 차량을 훈련하는 경우는 환경이 실제 환경입니다. 도로 위를 주행하는 자율 주행 차량을 모델링하는 컴퓨터 프로그램을 훈련하는 경우에는 환경이 시뮬레이터입니다.

- State

-

환경에 대한 모든 정보와 미래와 관련된 과거의 모든 단계를 지정합니다. 예를 들어, 로봇이 언제든지 어떤 방향으로든 이동할 수 있는 RL 모델에서는 현재 시간 단계에서 로봇의 위치가 상태입니다. 로봇 위치를 알면 해당 위치에 도착하기 위해 어떤 단계를 수행했는지 알 필요가 없기 때문입니다.

- 작업

-

작업은 에이전트가 수행합니다. 예를 들어 로봇이 앞으로 나아갑니다.

- 보상

-

에이전트가 수행한 마지막 작업의 상태 값을 나타내는 숫자입니다. 예를 들어, 목표가 로봇이 보물을 찾도록 하는 것이라면 보물을 찾은 경우 보상이 5이고, 보물을 찾지 못한 경우에는 보상이 0일 수 있습니다. RL 모델은 장기간 누적된 보상을 최적화하는 전략을 찾으려고 합니다. 이러한 전략을 정책이라고 합니다.

- 관측치

-

각 단계마다 에이전트가 사용할 수 있는 환경 상태에 대한 정보입니다. 전체 상태이거나 상태의 일부분일 수 있습니다. 예를 들어, 체스 시합 모델의 에이전트는 모든 단계에서 체스판의 전체 상태를 관찰할 수 있지만 미로 속의 로봇은 현재 마주하고 있는 미로의 작은 부분 밖에 관찰할 수 없습니다.

일반적으로 RL의 훈련은 많은 에피소드로 구성됩니다. 에피소드는 초기 상태에서 환경이 최종 상태에 도달할 때까지 MDP의 모든 시간 단계로 구성됩니다.

Amazon SageMaker AI RL의 주요 기능

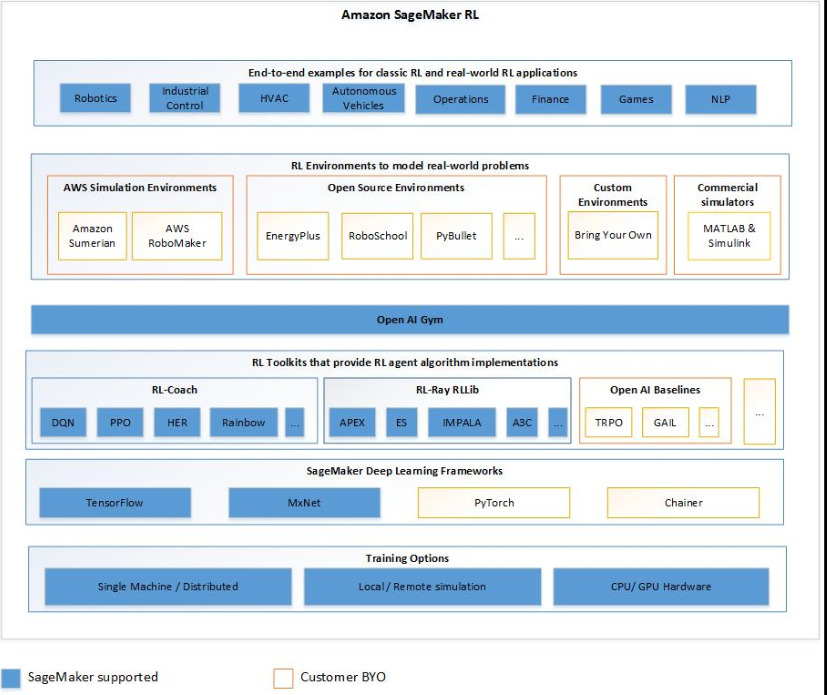

SageMaker AI RL에서 RL 모델을 훈련하려면 다음 구성 요소를 사용합니다.

-

딥 러닝(DL) 프레임워크. 현재 SageMaker AI는 TensorFlow 및 Apache MXNet에서 RL을 지원합니다.

-

RL 도구 키트. RL 도구 키트는 에이전트와 환경 간의 상호 작용을 관리하고, RL 알고리즘의 광범위한 상태 선택 항목을 제공합니다. SageMaker AI는 Intel Coach 및 Ray RLlib 도구 키트를 지원합니다. Intel Coach에 대한 자세한 정보는 https://nervanasystems.github.io/coach/

를 참조하세요. Ray RLlib에 대한 자세한 정보는 https://ray.readthedocs.io/en/latest/rllib.html 을 참조하세요. -

RL 환경. 사용자 지정 환경, 오픈 소스 환경 또는 상용 환경을 사용할 수 있습니다. 자세한 내용은 Amazon SageMaker AI의 RL 환경을 참조하세요.

다음 다이어그램은 SageMaker AI RL에서 지원되는 RL 구성 요소를 보여줍니다.

강화형 기계 학습 샘플 노트북

전체 코드 예제는 SageMaker AI 예제 리포지토리의 강화 학습 샘플 노트북