Die vorliegende Übersetzung wurde maschinell erstellt. Im Falle eines Konflikts oder eines Widerspruchs zwischen dieser übersetzten Fassung und der englischen Fassung (einschließlich infolge von Verzögerungen bei der Übersetzung) ist die englische Fassung maßgeblich.

Generative KI für AWS SRA

Dieser Abschnitt enthält aktuelle Empfehlungen für den sicheren Einsatz generativer KI zur Verbesserung der Produktivität und Effizienz für Benutzer und Organisationen. Es konzentriert sich auf die Verwendung von Amazon Bedrock auf der Grundlage AWS SRA der ganzheitlichen Richtlinien für die Bereitstellung aller AWS Sicherheitsdienste in einer Umgebung mit mehreren Konten. Diese Anleitung baut auf der Möglichkeit aufSRA, generative KI-Funktionen innerhalb eines sicheren Frameworks der Enterprise-Klasse zu ermöglichen. Es deckt wichtige Sicherheitskontrollen wie IAM Berechtigungen, Datenschutz, Eingabe-/Ausgabevalidierung, Netzwerkisolierung, Protokollierung und Überwachung ab, die speziell für die generativen KI-Funktionen von Amazon Bedrock gelten.

Die Zielgruppe dieser Anleitung sind Sicherheitsexperten, Architekten und Entwickler, die für die sichere Integration generativer KI-Funktionen in ihre Organisationen und Anwendungen verantwortlich sind.

Der SRA untersucht die Sicherheitsüberlegungen und bewährten Methoden für diese generativen KI-Funktionen von Amazon Bedrock:

Die Anleitung behandelt auch, wie Sie die generative KI-Funktionalität von Amazon Bedrock in traditionelle AWS Workloads integrieren können, die auf Ihrem Anwendungsfall basieren.

In den folgenden Abschnitten dieser Anleitung wird auf jede dieser vier Funktionen eingegangen, die Gründe für die Funktion und ihre Verwendung erörtert, Sicherheitsaspekte im Zusammenhang mit der Funktion behandelt und erläutert, wie Sie AWS Dienste und Funktionen verwenden können, um die Sicherheitsaspekte zu berücksichtigen (Problembehebung). Die Gründe, Sicherheitsüberlegungen und Abhilfemaßnahmen bei der Verwendung von Basismodellen (Fähigkeit 1) gelten auch für alle anderen Funktionen, da sie alle Modellinferenz verwenden. Wenn Ihre Geschäftsanwendung beispielsweise ein maßgeschneidertes Amazon Bedrock-Modell mit der Funktion Retrieval Augmented Generation (RAG) verwendet, müssen Sie die Gründe, Sicherheitsüberlegungen und Abhilfemaßnahmen der Funktionen 1, 2 und 4 berücksichtigen.

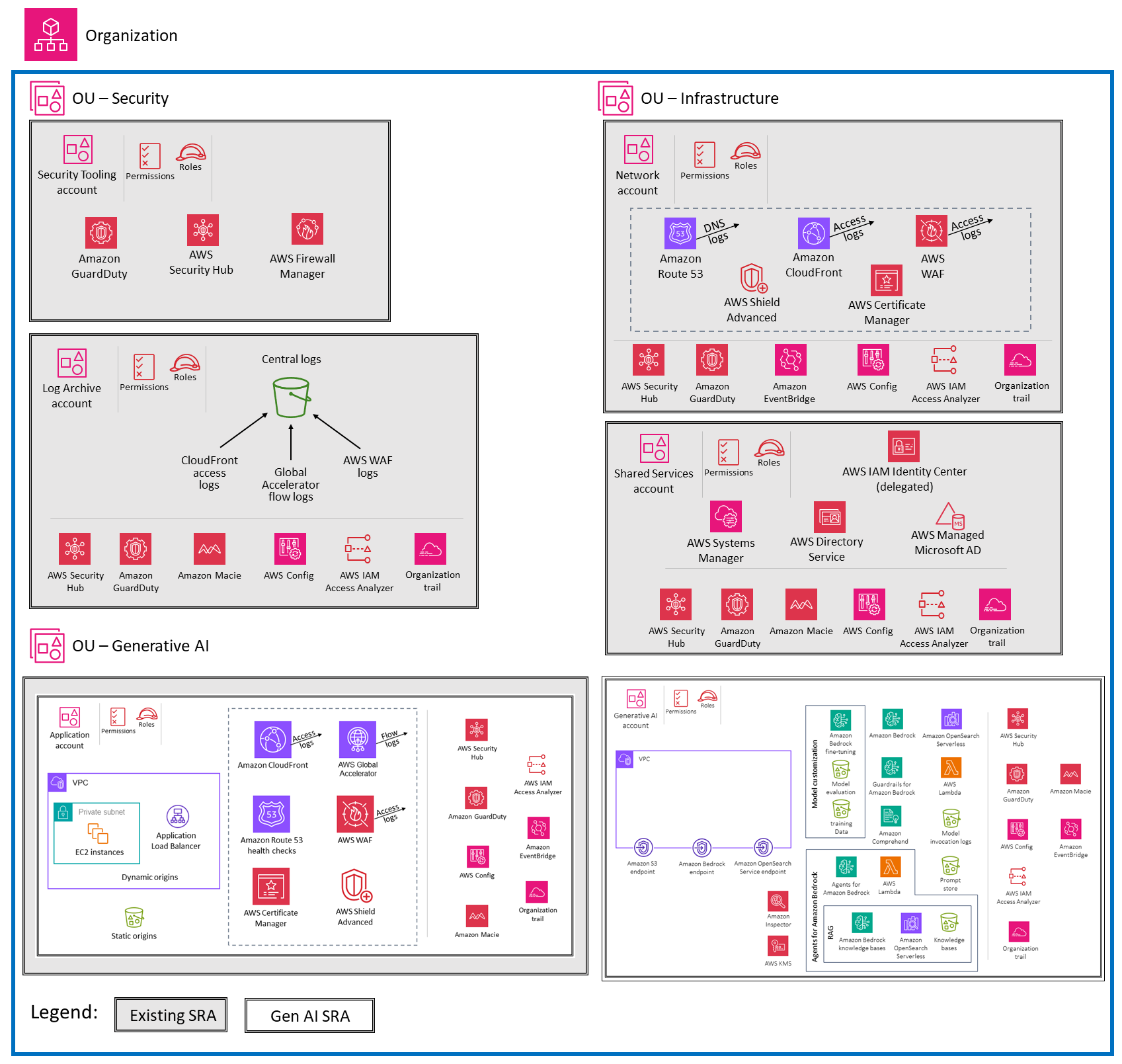

Die im folgenden Diagramm dargestellte Architektur ist eine Erweiterung der AWS SRA Workloads OU, die zuvor in diesem Handbuch beschrieben wurde.

Eine spezielle Organisationseinheit ist für Anwendungen vorgesehen, die generative KI verwenden. Die Organisationseinheit besteht aus einem Anwendungskonto, in dem Sie Ihre herkömmliche AWS Anwendung hosten, die spezifische Geschäftsfunktionen bereitstellt. Diese AWS Anwendung verwendet die generativen KI-Funktionen, die Amazon Bedrock bietet. Diese Funktionen werden über das Generative AI-Konto bereitgestellt, das die entsprechenden Amazon Bedrock- und zugehörigen AWS Dienste hostet. Die Gruppierung von AWS Diensten nach Anwendungstyp hilft bei der Durchsetzung von Sicherheitskontrollen durch OU- und AWS kontospezifische Richtlinien zur Servicekontrolle. Dies macht es auch einfacher, eine strenge Zugriffskontrolle und geringste Rechte zu implementieren. Zusätzlich zu diesen spezifischen OUs Konten werden in der Referenzarchitektur zusätzliche Konten OUs und Konten beschrieben, die grundlegende Sicherheitsfunktionen bereitstellen, die für alle Anwendungstypen gelten. Die Konten Org Management, Security Tooling, Log Archive, Network und Shared Services wurden in früheren Abschnitten dieses Handbuchs behandelt.

Designüberlegung

Wenn Ihre Anwendungsarchitektur die Konsolidierung generativer KI-Services von Amazon Bedrock und anderer AWS Services innerhalb desselben Kontos erfordert, auf dem Ihre Geschäftsanwendung gehostet wird, können Sie die Konten Application und Generative AI zu einem einzigen Konto zusammenführen. Dies ist auch der Fall, wenn Ihre Nutzung generativer KI auf Ihr gesamtes AWS Unternehmen verteilt ist.

Designüberlegungen

Sie können Ihr Generative AI-Konto weiter nach der Umgebung des Softwareentwicklungszyklus (SDLC) (z. B. Entwicklung, Test oder Produktion) oder nach Modell oder Benutzergemeinschaft aufteilen.

-

Trennung der Konten je nach SDLC Umgebung: Es hat sich bewährt, die SDLC Umgebungen in separate Umgebungen aufzuteilen OUs. Diese Trennung gewährleistet eine angemessene Isolierung und Kontrolle über jede Umgebung und jeden Support. Es bietet:

-

Kontrollierter Zugriff. Verschiedene Teams oder Einzelpersonen können je nach ihren Rollen und Verantwortlichkeiten Zugriff auf bestimmte Umgebungen erhalten.

-

Isolierung von Ressourcen. Jede Umgebung kann über eigene Ressourcen (wie Modelle oder Wissensdatenbanken) verfügen, ohne dass andere Umgebungen beeinträchtigt werden.

-

Kostenverfolgung. Die mit jeder Umgebung verbundenen Kosten können separat verfolgt und überwacht werden.

-

Risikominderung. Probleme oder Experimente in einer Umgebung (z. B. Entwicklung) haben keinen Einfluss auf die Stabilität anderer Umgebungen (z. B. der Produktion).

-

-

Trennung von Konten je nach Modell oder Benutzergemeinschaft: In der aktuellen Architektur bietet ein Konto Zugriff auf mehrere FMs Konten, sodass über AWS Bedrock Rückschlüsse gezogen werden können. Sie können IAM Rollen verwenden, um vorab geschulten Benutzern die Zugriffskontrolle auf der FMs Grundlage von Benutzerrollen und Verantwortlichkeiten zu ermöglichen. (Ein Beispiel finden Sie in der Amazon Bedrock-Dokumentation.) Umgekehrt können Sie sich dafür entscheiden, Ihre Generative AI-Konten nach Risikostufe, Modell oder Benutzergemeinschaft zu trennen. Dies kann in bestimmten Szenarien von Vorteil sein:

-

Risikostufen für Benutzergemeinschaften: Wenn verschiedene Benutzergemeinschaften unterschiedliche Risiken oder Zugriffsanforderungen haben, können separate Konten dazu beitragen, angemessene Zugriffskontrollen und Filter durchzusetzen.

-

Maßgeschneiderte Modelle: Bei Modellen, die auf Kundendaten zugeschnitten sind und umfassende Informationen zu den Trainingsdaten verfügbar sind, könnten separate Konten für eine bessere Isolierung und Kontrolle sorgen.

-

Auf der Grundlage dieser Überlegungen können Sie die spezifischen Anforderungen, Sicherheitsbedürfnisse und die betriebliche Komplexität bewerten, die mit Ihrem Anwendungsfall verbunden sind. Wenn das Hauptaugenmerk auf Amazon Bedrock liegt und vorab geschult istFMs, könnte ein einziger Account mit IAM Rollen ein praktikabler Ansatz sein. Wenn Sie jedoch spezielle Anforderungen an die Trennung von Modellen oder Benutzergemeinschaften haben oder wenn Sie planen, mit Modellen zu arbeiten, die vom Kunden unterstützt werden, sind möglicherweise separate Konten erforderlich. Letztlich sollte die Entscheidung von Ihren anwendungsspezifischen Bedürfnissen und Faktoren wie Sicherheit, betrieblicher Komplexität und Kostenüberlegungen abhängen.

Hinweis: Um die folgenden Diskussionen und Beispiele zu vereinfachen, wird in diesem Leitfaden von einer einzigen generativen KI-Kontostrategie mit IAM Rollen ausgegangen.

Amazon Bedrock

Amazon Bedrock ist eine einfache Möglichkeit, generative KI-Anwendungen mit Basismodellen (FMs) zu erstellen und zu skalieren. Als vollständig verwalteter Service bietet er eine Auswahl an leistungsstarken Produkten FMs von führenden KI-Unternehmen wie AI21 Labs, Anthropic, Cohere, Meta, Stability AI und Amazon. Es bietet außerdem eine Vielzahl von Funktionen, die für die Entwicklung generativer KI-Anwendungen erforderlich sind, und vereinfacht die Entwicklung bei gleichzeitiger Wahrung von Datenschutz und Sicherheit. FMsdienen als Bausteine für die Entwicklung generativer KI-Anwendungen und -Lösungen. Durch die Bereitstellung des Zugriffs auf Amazon Bedrock können Benutzer FMs über eine benutzerfreundliche Oberfläche oder über Amazon API Bedrock direkt mit diesen interagieren. Das Ziel von Amazon Bedrock besteht darin, die Modellauswahl über eine einzige Lösung API für schnelles Experimentieren, Anpassen und Bereitstellen in der Produktion zu ermöglichen und gleichzeitig eine schnelle Umstellung auf verschiedene Modelle zu unterstützen. Es dreht sich alles um die Modellwahl.

Sie können mit vortrainierten Modellen experimentieren, die Modelle an Ihre spezifischen Anwendungsfälle anpassen und sie in Ihre Anwendungen und Workflows integrieren. Diese direkte Interaktion mit den FMs ermöglicht es Unternehmen, schnell generative KI-Lösungen zu prototypisieren und zu iterieren und die neuesten Fortschritte im Bereich maschinelles Lernen zu nutzen, ohne umfangreiche Ressourcen oder Fachwissen für das Training komplexer Modelle von Grund auf zu benötigen. Die Amazon Bedrock-Konsole vereinfacht den Zugriff auf und die Nutzung dieser leistungsstarken generativen KI-Funktionen.

Amazon Bedrock bietet eine Reihe von Sicherheitsfunktionen, um den Datenschutz und die Sicherheit Ihrer Daten zu gewährleisten:

-

Alle Benutzerinhalte, die von Amazon Bedrock verarbeitet werden, werden nach Benutzern isoliert, im Ruhezustand verschlüsselt und in der AWS Region gespeichert, in der Sie Amazon Bedrock verwenden. Ihre Inhalte werden auch bei der Übertragung verschlüsselt, wobei mindestens TLS 1.2 verwendet wird. Weitere Informationen zum Datenschutz in Amazon Bedrock finden Sie in der Amazon Bedrock-Dokumentation.

-

Amazon Bedrock speichert oder protokolliert Ihre Eingabeaufforderungen und Abschlüsse nicht. Amazon Bedrock verwendet Ihre Eingabeaufforderungen und Ergänzungen nicht, um AWS Modelle zu trainieren, und gibt sie auch nicht an Dritte weiter.

-

Wenn Sie ein FM optimieren, verwenden Ihre Änderungen eine private Kopie dieses Modells. Das bedeutet, dass Ihre Daten nicht an Modellanbieter weitergegeben oder zur Verbesserung der Basismodelle verwendet werden.

-

Amazon Bedrock implementiert automatisierte Mechanismen zur Missbrauchserkennung, um potenzielle Verstöße gegen die Richtlinie AWS für verantwortungsvolle KI

zu identifizieren. Weitere Informationen zur Missbrauchserkennung in Amazon Bedrock finden Sie in der Amazon Bedrock-Dokumentation. -

Amazon Bedrock unterliegt den gängigen Compliance-Standards, darunter International Organization for Standardization (ISO), System and Organization Controls (SOC), Federal Risk and Authorization Management Program (FedRAMP) Moderate und Cloud Security Alliance (CSA) Security Trust Assurance and Risk (STAR) Level 2. Amazon Bedrock ist nach dem Health Insurance Portability and Accountability Act (HIPAA) berechtigt, und Sie können diesen Service gemäß der Allgemeinen Datenschutzverordnung () GDPR nutzen. Um zu erfahren, ob ein AWS Service in den Geltungsbereich bestimmter Compliance-Programme fällt, sehen Sie sich die AWSServices unter Umfang nach Compliance-Programmen

an und wählen Sie das Compliance-Programm aus, an dem Sie interessiert sind.

Weitere Informationen finden Sie unter Der AWS sichere Ansatz für generative KI

Leitplanken für Amazon Bedrock

Guardrails for Amazon Bedrock ermöglicht es Ihnen, Schutzmaßnahmen für Ihre generativen KI-Anwendungen zu implementieren, die auf Ihren Anwendungsfällen und verantwortungsvollen KI-Richtlinien basieren. Eine Leitplanke in Amazon Bedrock besteht aus Filtern, die Sie konfigurieren können, Themen, deren Blockierung Sie definieren können, und Nachrichten, die an Benutzer gesendet werden, wenn Inhalte blockiert oder gefiltert werden.

Die Filterung von Inhalten hängt von der Vertrauensklassifizierung von Benutzereingaben (Eingabevalidierung) und FM-Antworten (Ausgabevalidierung) in sechs schädlichen Kategorien ab. Alle Eingabe- und Outputaussagen werden für jede schädliche Kategorie in eines von vier Konfidenzniveaus (kein, niedrig, mittel, hoch) eingeteilt. Für jede Kategorie können Sie die Stärke der Filter konfigurieren. Die folgende Tabelle zeigt den Inhaltsgrad, den jede Filterstärke blockiert und zulässt.

Stärke des Filters |

Vertrauenswürdigkeit von Inhalten blockiert |

Vertrauenswürdige Inhalte sind zulässig |

|---|---|---|

None |

Keine Filterung |

Keine, niedrig, mittel, hoch |

Niedrig |

Hoch |

Keine, niedrig, mittel |

Mittelschwer |

Hoch, mittel |

Keine, niedrig |

Hoch |

Hoch, mittel, niedrig |

None |

Wenn Sie bereit sind, Ihre Guardrail für die Produktion bereitzustellen, erstellen Sie eine Version davon und rufen die Version der Guardrail in Ihrer Anwendung auf. Folgen Sie den Schritten APIauf der Registerkarte im Abschnitt Eine Leitplanke testen der Amazon Bedrock-Dokumentation.

Sicherheit

Standardmäßig werden Guardrails mit einem AWS verwalteten Schlüssel in AWS Key Management Services () verschlüsselt. AWS KMS Um zu verhindern, dass unbefugte Benutzer Zugriff auf die Guardrails erhalten, was zu unerwünschten Änderungen führen könnte, empfehlen wir Ihnen, einen vom Kunden verwalteten Schlüssel zu verwenden, um Ihre Guardrails zu verschlüsseln und den Zugriff auf die Guardrails mithilfe von Berechtigungen mit den geringsten Rechten einzuschränken. IAM

Bewertung des Amazon Bedrock-Modells

Amazon Bedrock unterstützt Modellevaluierungsjobs. Sie können die Ergebnisse eines Modellevaluierungsjobs verwenden, um die Modellergebnisse zu vergleichen und dann das Modell auszuwählen, das am besten zu Ihren nachgelagerten generativen KI-Anwendungen passt.

Sie können einen automatischen Modellevaluierungsjob verwenden, um die Leistung eines Modells zu bewerten, indem Sie entweder einen benutzerdefinierten Eingabeaufforderungsdatensatz oder einen integrierten Datensatz verwenden. Weitere Informationen finden Sie unter Erstellen einer automatischen Modellevaluierung und Verwenden von Prompt-Datensätzen in Modellevaluierungsjobs in der Amazon Bedrock-Dokumentation.

Modellevaluierungsjobs, bei denen menschliche Mitarbeiter eingesetzt werden, beziehen menschliche Beiträge von Mitarbeitern oder Fachexperten in den Bewertungsprozess ein.

Sicherheit

Die Modellevaluierung sollte in einer Entwicklungsumgebung erfolgen. Empfehlungen für die Organisation Ihrer Umgebungen außerhalb der Produktion finden Sie im Whitepaper Organizing Your AWS Environment Using Multiple Accounts.

Für alle Modellevaluierungsaufträge sind IAM Berechtigungen und IAM Servicerollen erforderlich. Weitere Informationen finden Sie in der Amazon Bedrock-Dokumentation zu den Berechtigungen, die erforderlich sind, um mithilfe der Amazon Bedrock-Konsole einen Modellevaluierungsjob zu erstellen, die Anforderungen an die Servicerolle und die erforderlichen ursprungsübergreifenden Berechtigungen für die gemeinsame Nutzung von Ressourcen ()CORS. Automatische Evaluierungsaufträge und Modellevaluierungsjobs, bei denen menschliche Mitarbeiter eingesetzt werden, erfordern unterschiedliche Servicerollen. Weitere Informationen zu den Richtlinien, die für eine Rolle zur Durchführung von Modelbewertungsaufträgen erforderlich sind, finden Sie in der Amazon Bedrock-Dokumentation unter Anforderungen an die Servicerolle für automatische Modellevaluierungsjobs und Anforderungen an die Servicerolle für Modellevaluierungsjobs, bei denen menschliche Gutachter eingesetzt werden.

Für Datensätze mit benutzerdefinierten Eingabeaufforderungen müssen Sie eine CORS Konfiguration für den S3-Bucket angeben. Die minimal erforderliche Konfiguration finden Sie in der Amazon Bedrock-Dokumentation. Bei Aufträgen zur Modellbewertung, bei denen Mitarbeiter eingesetzt werden, benötigen Sie ein Arbeitsteam. Sie können Arbeitsteams erstellen oder verwalten, erstellen oder verwalten, während Sie einen Modellevaluierungsjob einrichten, und Mitarbeiter zu einer privaten Belegschaft hinzufügen, die von Amazon SageMaker Ground Truth verwaltet wird. Um Arbeitsteams zu verwalten, die in Amazon Bedrock außerhalb der Auftragseinrichtung erstellt wurden, müssen Sie die Amazon Cognito- oder Amazon SageMaker Ground Truth Konsolen verwenden. Amazon Bedrock unterstützt maximal 50 Mitarbeiter pro Arbeitsteam.

Während der Modellevaluierung erstellt Amazon Bedrock eine temporäre Kopie Ihrer Daten und löscht die Daten nach Abschluss des Jobs. Es verwendet einen AWS KMS Schlüssel, um es zu verschlüsseln. Standardmäßig werden die Daten mit einem AWS verwalteten Schlüssel verschlüsselt. Wir empfehlen jedoch, stattdessen einen vom Kunden verwalteten Schlüssel zu verwenden. Weitere Informationen finden Sie unter Datenverschlüsselung für Modellevaluierungsjobs in der Amazon Bedrock-Dokumentation.