Le traduzioni sono generate tramite traduzione automatica. In caso di conflitto tra il contenuto di una traduzione e la versione originale in Inglese, quest'ultima prevarrà.

Questo argomento descrive come installare e gestire le dipendenze Python in un requirements.txt file per un ambiente Amazon Managed Workflows for Apache Airflow.

Indice

Test DAGs con l'utilità CLI di Amazon MWAA

-

L'utilità CLI (Command Line Interface) replica localmente un ambiente Amazon Managed Workflows for Apache Airflow.

-

La CLI crea localmente un'immagine del contenitore Docker simile a un'immagine di produzione Amazon MWAA. Ciò consente di eseguire un ambiente Apache Airflow locale per sviluppare e testare DAGs plug-in personalizzati e dipendenze prima della distribuzione su Amazon MWAA.

-

Per eseguire la CLI, vedi on. aws-mwaa-local-runner

GitHub

Installazione delle dipendenze Python utilizzando il formato file dei requisiti PyPi .org

La sezione seguente descrive i diversi modi per installare le dipendenze Python in base al PyPi formato.org Requirements

Opzione uno: dipendenze Python dal Python Package Index

La sezione seguente descrive come specificare le dipendenze Python dall'indice dei pacchetti Python in un filerequirements.txt

-

Esegui il test localmente. Aggiungi altre librerie in modo iterativo per trovare la giusta combinazione di pacchetti e le relative versioni, prima di creare un

requirements.txtfile. Per eseguire l'utilità CLI di Amazon MWAA, consulta on. aws-mwaa-local-runnerGitHub -

Consulta gli extra del pacchetto Apache Airflow. Per visualizzare un elenco dei pacchetti installati per Apache Airflow v2 su Amazon MWAA, consulta Amazon MWAA

local runner sul sito Web. requirements.txtGitHub -

Aggiungi una dichiarazione di vincoli. Aggiungi il file dei vincoli per il tuo ambiente Apache Airflow v2 nella parte superiore del file.

requirements.txtI file di vincoli di Apache Airflow specificano le versioni del provider disponibili al momento del rilascio di Apache Airflow.A partire da Apache Airflow v2.7.2, il file dei requisiti deve includere una dichiarazione.

--constraintSe non fornisci un vincolo, Amazon MWAA te ne specificherà uno per garantire che i pacchetti elencati nei tuoi requisiti siano compatibili con la versione di Apache Airflow che stai utilizzando.Nell'esempio seguente, sostituisci

{environment-version}con il numero di versione del tuo ambiente e{Python-version}con la versione di Python compatibile con il tuo ambiente.--constraint "https://raw.githubusercontent.com/apache/airflow/constraints-{Airflow-version}/constraints-{Python-version}.txt"Se il file dei vincoli determina che il

xyz==1.0pacchetto non è compatibile con altri pacchetti presenti nell'ambiente,pip3 installfallirà per evitare che librerie incompatibili vengano installate nell'ambiente. Se l'installazione di qualsiasi pacchetto non riesce, è possibile visualizzare i log degli errori per ogni componente di Apache Airflow (lo scheduler, il worker e il server web) nel flusso di log corrispondente su Logs. CloudWatch Per ulteriori informazioni sui tipi di registro, vedere. Visualizzazione dei log di Airflow in Amazon CloudWatch -

Pacchetti Apache Airflow. Aggiungi gli extra del pacchetto e la

versione (). ==Questo aiuta a evitare che pacchetti con lo stesso nome, ma con una versione diversa, vengano installati nell'ambiente.apache-airflow[package-extra]==2.5.1 -

Librerie Python. Aggiungi il nome del pacchetto e la versione (

==) nel tuorequirements.txtfile. In questo modo si evita l'applicazione automatica di future interruzioni del PyPisito .org. library==versionEsempio Boto3 e psycopg2-binary

Questo esempio viene fornito a scopo dimostrativo. Le librerie boto e psycopg2-binary sono incluse nell'installazione di base di Apache Airflow v2 e non devono essere specificate in un file.

requirements.txtboto3==1.17.54 boto==2.49.0 botocore==1.20.54 psycopg2-binary==2.8.6Se viene specificato un pacchetto senza una versione, Amazon MWAA installa la versione più recente del pacchetto da .org. PyPi

Questa versione può entrare in conflitto con altri pacchetti presenti nel tuo. requirements.txt

Opzione due: Python wheels (.whl)

Una ruota Python è un formato di pacchetto progettato per spedire librerie con artefatti compilati. I pacchetti wheel offrono diversi vantaggi come metodo per installare le dipendenze in Amazon MWAA:

-

Installazione più rapida: i file WHL vengono copiati nel contenitore come singolo ZIP e quindi installati localmente, senza dover scaricare ciascuno di essi.

-

Meno conflitti: è possibile determinare in anticipo la compatibilità delle versioni dei pacchetti. Di conseguenza, non è necessario elaborare in modo ricorsivo versioni compatibili.

pip -

Maggiore resilienza: con le librerie ospitate esternamente, i requisiti a valle possono cambiare, con conseguente incompatibilità di versione tra i contenitori in un ambiente Amazon MWAA. Non dipendendo da una fonte esterna per le dipendenze, ogni contenitore ha le stesse librerie indipendentemente dal momento in cui viene creata l'istanza di ogni contenitore.

Consigliamo i seguenti metodi per installare le dipendenze Python da un archivio Python wheel () nel tuo. .whl requirements.txt

Metodi

Utilizzo del plugins.zip file su un bucket Amazon S3

Lo scheduler, i worker e il server web di Apache Airflow (per Apache Airflow v2.2.2 e versioni successive) cercano plugin personalizzati durante l'avvio nel contenitore Fargate gestito per il AWS vostro ambiente all'indirizzo. /usr/local/airflow/plugins/ Questo processo inizia prima dell'avvio del servizio Amazon MWAA *pip3 install -r requirements.txt for Python e del servizio Apache Airflow. Un plugins.zip file può essere utilizzato per tutti i file che non si desidera modificare continuamente durante l'esecuzione dell'ambiente o per i quali non si desidera concedere l'accesso agli utenti che scrivono. DAGs Ad esempio, i file della ruota della libreria Python, i file PEM dei certificati e i file YAML di configurazione.

La sezione seguente descrive come installare una ruota contenuta nel plugins.zip file sul tuo bucket Amazon S3.

-

Scarica i file WHL necessari Puoi usarli

pip downloadcon il tuo local-runner esistente requirements.txtsu Amazon MWAA o su un altro contenitore Amazon Linux2 per risolvere e scaricare i file di Python wheel necessari. $pip3 download -r "$AIRFLOW_HOME/dags/requirements.txt" -d "$AIRFLOW_HOME/plugins"$cd "$AIRFLOW_HOME/plugins"$zip "$AIRFLOW_HOME/plugins.zip" * -

Specificate il percorso nel vostro.

requirements.txtSpecificate la directory dei plugins nella parte superiore del file requirements.txt utilizzando--find-linkse istruite a pipnon effettuare l'installazione da altre fonti utilizzando--no-index, come illustrato di seguito --find-links /usr/local/airflow/plugins --no-indexEsempio ruota in requirements.txt

L'esempio seguente presuppone che tu abbia caricato la ruota in un

plugins.zipfile nella radice del tuo bucket Amazon S3. Per esempio:--find-links /usr/local/airflow/plugins --no-index numpyAmazon MWAA recupera la

numpy-1.20.1-cp37-cp37m-manylinux1_x86_64.whlruota dallapluginscartella e la installa nel tuo ambiente.

Utilizzando un file WHL ospitato su un URL

La sezione seguente descrive come installare una ruota ospitata su un URL. L'URL deve essere accessibile pubblicamente o dall'interno del VPC Amazon personalizzato specificato per il tuo ambiente Amazon MWAA.

-

Fornisci un URL. Fornisci l'URL a una ruota nel tuo

requirements.txt.Esempio archivio wheel su un URL pubblico

L'esempio seguente scarica una ruota da un sito pubblico.

--find-links https://files.pythonhosted.org/packages/ --no-indexAmazon MWAA recupera la ruota dall'URL specificato e la installa nel tuo ambiente.

Nota

URLs non sono accessibili da server Web privati che installano i requisiti in Amazon MWAA v2.2.2 e versioni successive.

Creazione di un file WHL da un DAG

Se disponi di un server Web privato che utilizza Apache Airflow v2.2.2 o versione successiva e non riesci a installare i requisiti perché il tuo ambiente non ha accesso a repository esterni, puoi utilizzare il seguente DAG per prendere i requisiti Amazon MWAA esistenti e impacchettarli su Amazon S3:

from airflow import DAG

from airflow.operators.bash_operator import BashOperator

from airflow.utils.dates import days_ago

S3_BUCKET = 'my-s3-bucket'

S3_KEY = 'backup/plugins_whl.zip'

with DAG(dag_id="create_whl_file", schedule_interval=None, catchup=False, start_date=days_ago(1)) as dag:

cli_command = BashOperator(

task_id="bash_command",

bash_command=f"mkdir /tmp/whls;pip3 download -r /usr/local/airflow/requirements/requirements.txt -d /tmp/whls;zip -j /tmp/plugins.zip /tmp/whls/*;aws s3 cp /tmp/plugins.zip s3://{S3_BUCKET}/{S3_KEY}"

) Dopo aver eseguito il DAG, usa questo nuovo file come Amazon MWAAplugins.zip, facoltativamente, impacchettato con altri plugin. Quindi, aggiorna il file preceduto da e senza aggiungere. requirements.txt --find-links /usr/local/airflow/plugins --no-index --constraint

Questo metodo consente di utilizzare le stesse librerie offline.

Opzione tre: dipendenze Python ospitate su un repository privato PyPi conforme a /PEP-503

La sezione seguente descrive come installare un extra di Apache Airflow ospitato su un URL privato con autenticazione.

-

Aggiungi nome utente e password come opzioni di configurazione di Apache Airflow. Per esempio:

-

foo.user:YOUR_USER_NAME -

foo.pass:YOUR_PASSWORD

-

-

Crea il tuo file.

requirements.txtSostituisci i segnaposto nell'esempio seguente con il tuo URL privato e il nome utente e la password che hai aggiunto come opzioni di configurazione di Apache Airflow. Per esempio:--index-url https://${AIRFLOW__FOO__USER}:${AIRFLOW__FOO__PASS}@my.privatepypi.com -

Aggiungi eventuali librerie aggiuntive al tuo file.

requirements.txtPer esempio:--index-url https://${AIRFLOW__FOO__USER}:${AIRFLOW__FOO__PASS}@my.privatepypi.com my-private-package==1.2.3

Abilitazione dei log sulla console Amazon MWAA

Il ruolo di esecuzione per il tuo ambiente Amazon MWAA richiede l'autorizzazione per inviare log a Logs. CloudWatch Per aggiornare le autorizzazioni di un ruolo di esecuzione, consulta. Ruolo di esecuzione di Amazon MWAA

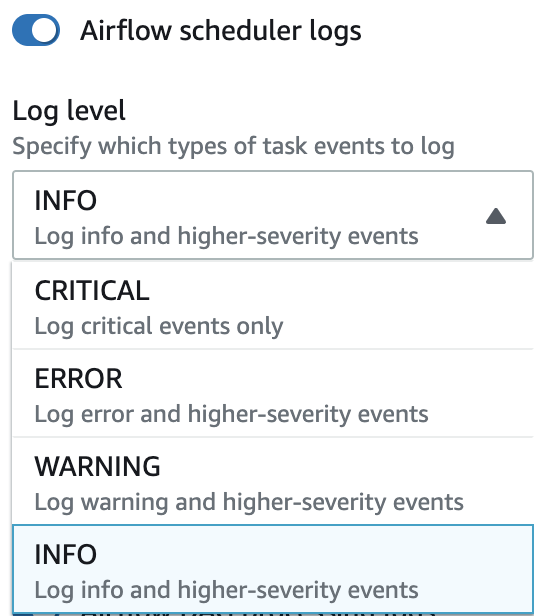

È possibile abilitare i log di Apache Airflow a livelloINFO,WARNING, ERROR o. CRITICAL Quando scegli un livello di log, Amazon MWAA invia i log per quel livello e tutti i livelli di gravità più elevati. Ad esempio, se abiliti i log a INFO livello, Amazon MWAA invia INFO log e WARNINGERROR, e livelli di CRITICAL log a Logs. CloudWatch Ti consigliamo di abilitare i log di Apache Airflow a INFO livello di Scheduler per visualizzare i log ricevuti per. requirements.txt

Visualizzazione dei log nella console Logs CloudWatch

È possibile visualizzare i log di Apache Airflow per Scheduler, pianificando i flussi di lavoro e analizzando la cartella. dags I passaggi seguenti descrivono come aprire il gruppo di log per Scheduler sulla console Amazon MWAA e visualizzare i log di Apache Airflow sulla console Logs. CloudWatch

Per visualizzare i log di un requirements.txt

-

Apri la pagina Ambienti

sulla console Amazon MWAA. -

Scegli un ambiente.

-

Scegli il gruppo di log dello scheduler Airflow nel riquadro Monitoraggio.

-

Scegli il

requirements_install_iplog in Log Streams. -

Dovresti vedere l'elenco dei pacchetti che sono stati installati nell'ambiente all'indirizzo

/usr/local/airflow/.local/bin. Per esempio:Collecting appdirs==1.4.4 (from -r /usr/local/airflow/.local/bin (line 1)) Downloading https://files.pythonhosted.org/packages/3b/00/2344469e2084fb28kjdsfiuyweb47389789vxbmnbjhsdgf5463acd6cf5e3db69324/appdirs-1.4.4-py2.py3-none-any.whl Collecting astroid==2.4.2 (from -r /usr/local/airflow/.local/bin (line 2)) -

Controlla l'elenco dei pacchetti e verifica se qualcuno di questi ha riscontrato un errore durante l'installazione. Se qualcosa è andato storto, potresti visualizzare un errore simile al seguente:

2021-03-05T14:34:42.731-07:00 No matching distribution found for LibraryName==1.0.0 (from -r /usr/local/airflow/.local/bin (line 4)) No matching distribution found for LibraryName==1.0.0 (from -r /usr/local/airflow/.local/bin (line 4))

Visualizzazione degli errori nell'interfaccia utente di Apache Airflow

Potresti anche voler controllare l'interfaccia utente di Apache Airflow per identificare se un errore può essere correlato a un altro problema. L'errore più comune che potresti riscontrare con Apache Airflow su Amazon MWAA è:

Broken DAG: No module namedx

Se vedi questo errore nell'interfaccia utente di Apache Airflow, è probabile che nel file manchi una dipendenza richiesta. requirements.txt

Accesso ad Apache Airflow

Hai bisogno Politica di accesso all'interfaccia utente di Apache Airflow: Amazon MWAAWeb ServerAccess delle autorizzazioni per il tuo AWS account in AWS Identity and Access Management (IAM) per visualizzare l'interfaccia utente di Apache Airflow.

Per accedere all'interfaccia utente di Apache Airflow

-

Apri la pagina Ambienti

sulla console Amazon MWAA. -

Scegli un ambiente.

-

Scegli Open Airflow UI.

Scenari di esempio requirements.txt

Puoi mescolare e abbinare diversi formati nel tuorequirements.txt. L'esempio seguente utilizza una combinazione dei diversi modi per installare gli extra.

Esempio Extra su PyPi .org e un URL pubblico

È necessario utilizzare l'--index-urlopzione quando si specificano i pacchetti da PyPi .org, oltre ai pacchetti su un URL pubblico, come un repository personalizzato conforme a PEP 503. URLs

aws-batch == 0.6

phoenix-letter >= 0.3

--index-url http://dist.repoze.org/zope2/2.10/simple

zopelib