O AWS IoT Greengrass Version 1 entrou na fase de vida útil prolongada em 30 de junho de 2023. Para obter mais informações, consulte política de manutenção do AWS IoT Greengrass V1. Após essa data, o AWS IoT Greengrass V1 não lançará atualizações que forneçam recursos, aprimoramentos, correções de erros ou patches de segurança. Os dispositivos que funcionam com o AWS IoT Greengrass V1 não serão interrompidos e continuarão operando e se conectando à nuvem. É altamente recomendável que você migre para AWS IoT Greengrass Version 2, o que adicionará novos recursos significativos e suporte para plataformas adicionais.

Como configurar a inferência otimizada de Machine Learning usando o AWS Management Console

Para seguir as etapas deste tutorial, você deve usar o AWS IoT Greengrass Core v1.10 ou posterior.

Você pode usar o compilador de aprendizado profundo do SageMaker Neo para otimizar a eficiência de previsão de modelos nativos de inferência de machine learning nas estruturas de trabalho Tensorflow, Apache MXNet, PyTorch, ONNX e XGBoost para uma área menor e um desempenho mais rápido. Você pode baixar o modelo otimizado e instalar o Runtime de Aprendizado Profundo (DLR) do SageMaker Neo e implantá-los em seus dispositivos AWS IoT Greengrass para inferência mais rápida.

Este tutorial descreve como usar o AWS Management Console para configurar um grupo do Greengrass para executar um exemplo de inferência do Lambda que reconhece imagens de uma câmera localmente, sem enviar dados para a nuvem. O exemplo de inferência acessa o módulo da câmera em um Raspberry Pi. Neste tutorial, você faz download de um modelo predefinido que é treinado por Resnet-50 e otimizado no compilador de aprendizado profundo Neo. Em seguida, use o modelo para executar a classificação de imagem local no seu dispositivo AWS IoT Greengrass.

O tutorial contém as seguintes etapas de nível elevado:

Pré-requisitos

Para concluir este tutorial, é necessário:

-

Raspberry Pi 4 Modelo B ou Raspberry Pi 3 Modelo B/B+, instalado e configurado para uso com o AWS IoT Greengrass. Para configurar seu Raspberry Pi com o AWS IoT Greengrass, execute o script Greengrass Device Setup ou conclua o Módulo 1 e o Módulo 2 do Conceitos básicos do AWS IoT Greengrass.

nota

O Raspberry Pi pode exigir uma fonte de alimentação

de 2,5 A para executar as estruturas de aprendizado profundo que normalmente são usadas para classificação de imagens. Uma fonte de alimentação com uma classificação mais baixa pode fazer com que o dispositivo seja reinicializado. -

Módulo de câmera Raspberry Pi V2 - 8 megapixels, 1080 p

. Para aprender a configurar a câmera, consulte Conectar a câmera na documentação do Raspberry Pi. -

Um grupo do Greengrass e um núcleo do Greengrass. Para saber como criar um grupo ou núcleo do Greengrass, consulte Conceitos básicos do AWS IoT Greengrass.

nota

Este tutorial usa um Raspberry Pi, mas o AWS IoT Greengrass oferece suporte a outras plataformas, como Intel Atom e NVIDIA Jetson TX2. Se estiver usando o exemplo do Intel Atom, talvez seja necessário instalar o Python 3.6 em vez do Python 3.7. Para obter informações sobre como configurar o dispositivo para poder instalar o software do AWS IoT Greengrass Core, consulte Configurar outros dispositivos.

Para plataformas de terceiros não compatíveis com o AWS IoT Greengrass, você deve executar sua função do Lambda no modo sem contêiner. Para executar no modo sem contêiner, você deve executar sua função do Lambda como root. Para ter mais informações, consulte Considerações ao escolher a conteinerização de função do Lambda e Definir a identidade de acesso padrão para as funções do Lambda em um grupo.

Etapa 1: Configurar o Raspberry Pi

Nesta etapa, instale as atualizações no sistema operacional Raspbian, instale o software do módulo da câmera e as dependências do Python e ative a interface da câmera.

Execute os seguintes comandos no seu terminal do Raspberry Pi.

-

Instale as atualizações no Raspbian.

sudo apt-get update sudo apt-get dist-upgrade -

Instale a interface do

picamerapara o módulo da câmera e outras bibliotecas do Python que são necessárias para este tutorial.sudo apt-get install -y python3-dev python3-setuptools python3-pip python3-picameraValide a instalação:

-

Verifique se a instalação do Python 3.7 inclui o pip.

python3 -m pipSe o pip não estiver instalado, faça download dele no site do pip

e execute o seguinte comando. python3 get-pip.py -

Verifique se a versão do Python é 3.7 ou superior.

python3 --versionSe a saída listar uma versão anterior, execute o seguinte comando.

sudo apt-get install -y python3.7-dev -

Verifique se o Setuptools e Picamera foram instalados com êxito.

sudo -u ggc_user bash -c 'python3 -c "import setuptools"' sudo -u ggc_user bash -c 'python3 -c "import picamera"'Se a saída não contiver erros, a validação será bem-sucedida.

nota

Se o Python executável instalado no dispositivo for o

python3.7, usepython3.7em vez depython3para os comandos neste tutorial. Verifique se a instalação do pip mapeia para a versão correta dopython3oupython3.7para evitar erros de dependência. -

-

Reinicie o Raspberry Pi.

sudo reboot -

Abra a ferramenta de configuração do Raspberry Pi.

sudo raspi-config -

Use as setas do teclado para abrir Interfacing Options e habilitar a interface da câmera. Se solicitado, permita que o dispositivo seja reinicializado.

-

Use o seguinte comando para testar a configuração da câmera.

raspistill -v -o test.jpgIsso abre uma janela de visualização no Raspberry Pi, salva uma imagem chamada

test.jpgno seu diretório atual e exibe informações sobre a câmera no terminal do Raspberry Pi.

Etapa 2: Instalar o tempo de execução de aprendizagem profunda do Amazon SageMaker Neo

Nesta etapa, você baixa o Runtime de Aprendizado Profundo (DLR) e o instala no seu Raspberry Pi.

nota

Recomendamos instalar a versão 1.1.0 para este tutorial.

-

Inicie sessão no seu Raspberry Pi remotamente.

ssh pi@your-device-ip-address -

Abra a documentação do DLR, abra Installing DLR

e localize o URL de roda para dispositivos Raspberry Pi. Depois, siga as instruções para instalar o DLR no dispositivo. Por exemplo, você pode usar o pip: pip3 installrasp3b-wheel-url -

Depois de instalar o DLR, valide a seguinte configuração:

-

Verifique se a conta do sistema do

ggc_userpode usar a biblioteca do DLR.sudo -u ggc_user bash -c 'python3 -c "import dlr"' -

Verifique se o NumPy está instalado.

sudo -u ggc_user bash -c 'python3 -c "import numpy"'

-

Etapa 3: Criar uma função de inferência da função do Lambda

Nesta etapa, crie um pacote de implantação da função do Lambda e uma função do Lambda Depois, publique uma versão da função e crie um alias.

-

No computador, faça download do exemplo do DLR para Raspberry Pi em Exemplos de machine learning.

-

Não descompacte o arquivo

dlr-py3-armv7l.tar.gzobtido por download.cdpath-to-downloaded-sampletar -xvzf dlr-py3-armv7l.tar.gzO diretório

examplesno pacote de exemplo extraído contém o código e as dependências da função.-

O

inference.pyé o código de inferência usado neste tutorial. Você pode usar esse código como modelo para criar sua própria função de inferência. -

greengrasssdké a versão 1.5.0 do SDK do AWS IoT Greengrass Core para Python.nota

Se uma nova versão estiver disponível, você poderá fazer download dela e atualizar a versão do SDK no seu pacote de implantação. Para obter mais informações, consulte SDK do AWS IoT Greengrass Core para Python

no GitHub.

-

-

Compacte o conteúdo do diretório

examplesem um arquivo chamadooptimizedImageClassification.zip. Esse é o pacote de implantação.cdpath-to-downloaded-sample/dlr-py3-armv7l/examples zip -r optimizedImageClassification.zip .O pacote de implantação contém seu código e as dependências da função. Isso inclui o código que invoca as APIs do Python do runtime de aprendizado profundo do Neo para realizar inferência com os modelos do compilador de aprendizado profundo do Neo.

nota

Verifique se os arquivos

.pye as dependências estão na raiz do diretório. -

Agora, adicione a função do Lambda ao seu grupo do Greengrass.

Na página do console do Lambda, selecione Funções e, em seguida, Criar função.

-

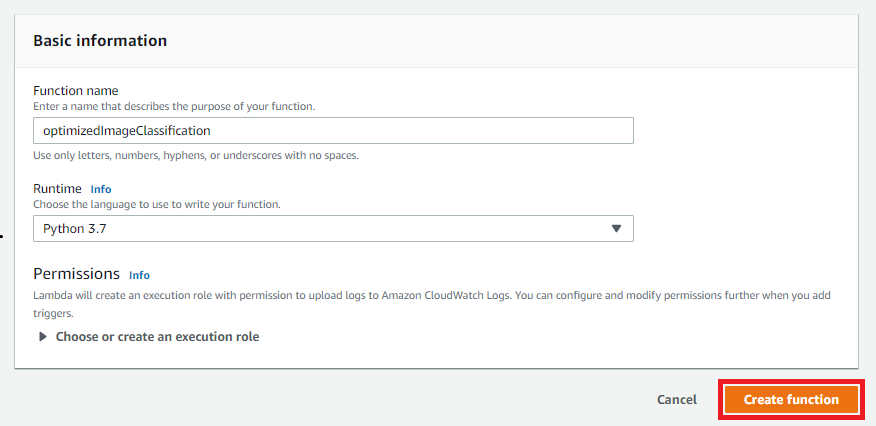

Selecione Criar do zero e use os valores a seguir para criar a função:

-

Em Function name (Nome da função), insira

optimizedImageClassification. -

Em Runtime (Tempo de execução), selecione Python 3.7.

Em Permissões, mantenha a configuração padrão. Isso cria uma função de execução que concede permissões básicas do Lambda. Essa função não é usada pelo AWS IoT Greengrass.

-

-

Selecione Criar função.

Agora, carregue o seu pacote de implantação da função do Lambda e registre o manipulador.

-

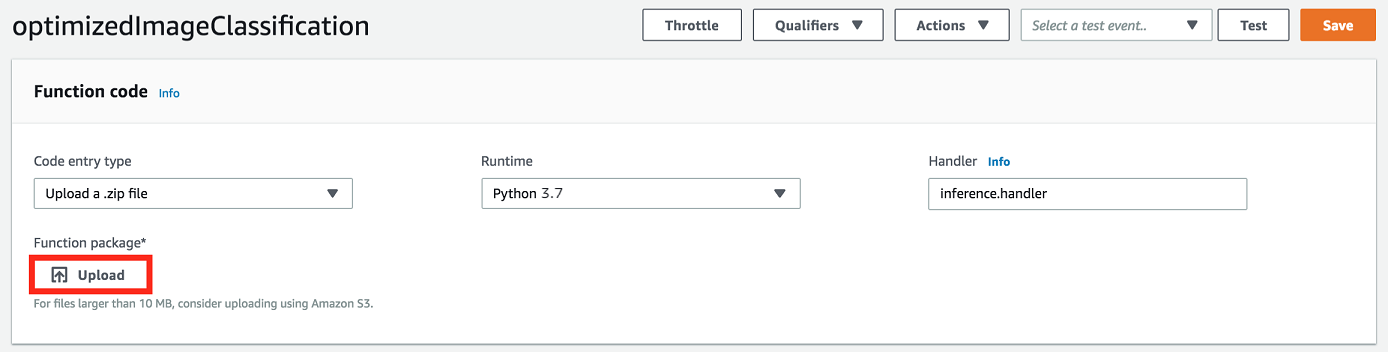

Na guia Código, em Fonte do código, selecione Fazer upload a partir de. No menu suspenso, selecione o arquivo .zip.

-

Selecione seu pacote de implantação

optimizedImageClassification.zipe, em seguida, selecione Salvar. -

Na guia Código da função, em Configurações de runtime, selecione Editar e insira os valores a seguir.

-

Em Runtime (Tempo de execução), selecione Python 3.7.

-

Em Handler (Manipulador), insira

inference.handler.

Selecione Salvar.

-

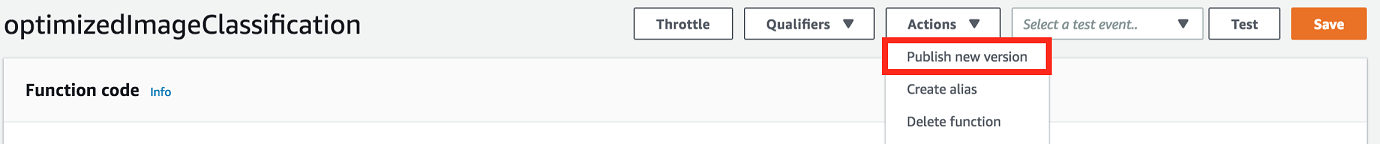

Em seguida, publique a primeira versão da sua função do Lambda. Em seguida, crie um alias para a versão.

nota

Os grupos do Greengrass podem fazer referência a uma função do Lambda por alias (recomendado) ou por versão. Usar um alias facilita o gerenciamento de atualizações de código porque você não precisa alterar a tabela de assinaturas nem a definição do grupo ao atualizar a função do código. Em vez disso, você pode simplesmente apontar o alias para a nova versão da função.

-

No menu Actions, selecione Publish new version.

-

Em Version description (Descrição da versão), insira

First versione, em seguida, selecione Publish (Publicar). -

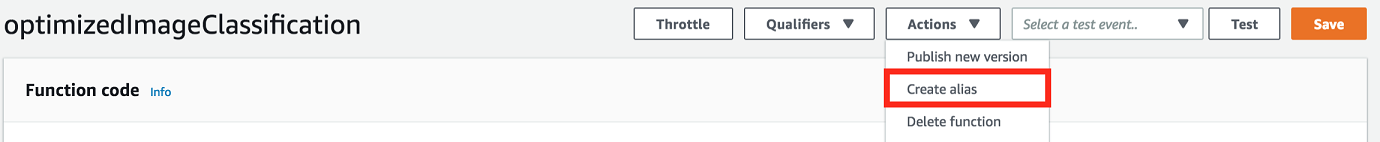

Na página de configuração optimizedImageClassification: 1, no menu Actions (Ações), selecione Create alias (Criar alias).

-

Na página Create a new alias, use os seguintes valores:

-

Em Nome, digite

mlTestOpt. -

Em Version (Versão), insira

1.

nota

O AWS IoT Greengrass não oferece suporte a alias do Lambda para as versões $LATEST.

-

-

Selecione Create (Criar).

Agora, adicione a função do Lambda ao seu grupo do Greengrass.

Etapa 4: adicionar a função do Lambda ao grupo do Greengrass

Nesta etapa, adicione a função do Lambda ao grupo e configura seu ciclo de vida.

Primeiro, adicione a função do Lambda ao seu grupo do Greengrass.

No painel de navegação do console de AWS IoT, em Gerenciar, expanda Dispositivos Greengrass e, em seguida selecione Grupos (V1).

-

Na página de configuração do grupo, selecione a guia funções do Lambda e, em seguida selecione Adicionar.

-

Selecione a função do Lambda e, em seguida selecione optimizedImageClassification.

-

Na versão da função do Lambda, selecione o alias para a versão que você publicou.

Em seguida, configure o ciclo de vida da função do Lambda.

-

Na seção configuração da função do Lambda, faça as atualizações a seguir.

nota

Recomendamos que você execute sua função do Lambda sem conteinerização, a menos que seu caso de negócios faça essa exigência. Isso ajuda a habilitar o acesso à GPU e à câmera do seu dispositivo sem configurar os recursos do dispositivo. Se você executar sem conteinerização, também deverá conceder acesso root às suas funções do Lambda do AWS IoT Greengrass.

-

Para executar sem conteinerização:

-

Para Usuário e grupo do sistema, selecione

Another user ID/group ID. Para ID de usuário do sistema, insira0. Para ID do grupo do sistema, insira0.Isso permite que sua função do Lambda seja executada como root. Para obter mais informações sobre como executar como raiz, consulte Definir a identidade de acesso padrão para as funções do Lambda em um grupo.

dica

Você também deve atualizar seu arquivo

config.jsonpara conceder acesso root à sua função do Lambda. Para o procedimento, consulte Executar uma função do Lambda como raiz. -

Para conteinerização da função do Lambda, selecione Sem contêiner.

Para obter mais informações sobre como executar sem conteinerização, consulte Considerações ao escolher a conteinerização de função do Lambda.

-

Em Timeout (Tempo limite), insira

10 seconds. -

Para Fixado, selecione Verdadeiro.

Para ter mais informações, consulte Configuração do ciclo de vida das funções do Lambda do Greengrass.

-

Em Parâmetro adicional, para Acesso de leitura ao diretório /sys, selecione Habilitado.

-

-

Em vez disso, para executar no modo conteinerizado:

nota

Não recomendamos a execução no modo conteinerizado, a menos que seu caso de negócios faça essa exigência.

-

Para Usuário e grupo do sistema, selecione Usar padrão de grupo.

-

Para Conteinerização da função do Lambda, selecione Usar padrão de grupo.

-

Em Memory limit (Limite de memória), insira

1024 MB. -

Em Timeout (Tempo limite), insira

10 seconds. -

Para Fixado, selecione Verdadeiro.

Para ter mais informações, consulte Configuração do ciclo de vida das funções do Lambda do Greengrass.

-

Em Parâmetros adicionais, para Acesso de leitura ao diretório /sys, selecione Habilitado.

-

-

-

Selecione Adicionar função do Lambda.

Etapa 5: Adicionar um recurso de modelo otimizado do SageMaster Neo ao grupo do Greengrass

Nesta etapa, crie um recurso para o modelo de inferência de ML otimizado e o carrega em um bucket do Amazon S3. Depois, localize o modelo atualizado do Amazon S3 no AWS IoT Greengrass console e afilie o recurso recém-criado à função do Lambda. Isso possibilita que a função acesse os recursos no dispositivo básico.

-

No computador, navegue até o diretório

resnet50no pacote de exemplo que você descompactou em Etapa 3: Criar uma função de inferência da função do Lambda.nota

Se estiver usando o exemplo do NVIDIA Jetson, precisará usar o diretório

resnet18no pacote de exemplo. Para ter mais informações, consulte Configuração NVIDIA Jetson TX2.cdpath-to-downloaded-sample/dlr-py3-armv7l/models/resnet50Esse diretório contém artefatos de modelo pré-compilados para um modelo de classificação de imagem treinado com Resnet-50.

-

Compacte os arquivos dentro do diretório

resnet50em um arquivo chamadoresnet50.zip.zip -r resnet50.zip . -

Na página de configuração do grupo, para o seu grupo do AWS IoT Greengrass, selecione a guia Recursos. Navegue até a seção Machine Learning e, em seguida selecione Adicionar recurso de machine learning. Na página Create a machine learning resource (Criar recurso de Machine Learning), em Resource name (Nome do recurso), insira

resnet50_model. -

Em Fonte do modelo, selecione Usar um modelo armazenado no S3, como um modelo otimizado por meio do compilador de aprendizado profundo.

-

Em URI do S3, selecione Procurar no S3.

nota

Atualmente, modelos otimizados do SageMaker são armazenados automaticamente no Amazon S3. Você pode localizar seu modelo otimizado no bucket de seu Amazon S3 usando essa opção. Para obter mais informações sobre o modelo de otimização no SageMaker, consulte Documentação do SageMaker Neo.

-

Selecione Upload a model (Fazer upload de um modelo).

-

Na guia do console do Amazon S3, carregue o arquivo zip em um bucket do Amazon S3. Para obter informações, consulte Como carregar arquivos e pastas em um bucket do S3? no Guia do usuário do Amazon Simple Storage Service.

nota

O nome do bucket deve conter a string

greengrass. Selecione um nome exclusivo (comogreengrass-dlr-bucket-). Não use ponto (user-id-epoch-time.) no nome do bucket. -

Na guia doAWS IoT Greengrass console, localize e selecione o bucket do Amazon S3. Localize o arquivo

resnet50.zipcarregado e, em seguida selecione Select (Selecionar). Talvez seja necessário atualizar a página para atualizar a lista de buckets e arquivos disponíveis. -

Em Caminho de destino, insira

/ml_model.

Este é o destino do modelo local no namespace de runtime do Lambda. Quando você implanta o grupo, o AWS IoT Greengrass recupera o pacote do modelo de origem e, em seguida, extrai o conteúdo para o diretório especificado.

nota

Recomendamos que você use o caminho exato fornecido para o seu caminho local. O uso de um caminho de destino do modelo local diferente nesta etapa causa imprecisão em alguns comandos de solução de problemas fornecidos neste tutorial. Se você usar um caminho diferente, deverá configurar uma variável de ambiente

MODEL_PATHque use o caminho exato fornecido aqui. Para obter informações sobre as variáveis de ambiente, consulte Variáveis de ambiente do AWS Lambda. -

Se estiver executando no modo conteinerizado:

-

Em Proprietário do grupo do sistema e permissões de acesso ao arquivo, selecione Especificar grupos e permissões do sistema.

-

Selecione Acesso somente leitura e, em seguida, Adicionar recurso.

-

Etapa 6: Adicionar um recurso de dispositivo de câmera a um grupo do Greengrass

Nesta etapa, crie um recurso para o módulo da câmera e afilie-o com a função do Lambda. Isso possibilita que a função do Lambda acesse o recurso no dispositivo básico.

nota

Se você executar no modo não conteinerizado, o AWS IoT Greengrass poderá acessar a GPU e a câmera do seu dispositivo sem configurar esse recurso.

-

Na página de configuração do grupo, selecione Recursos.

-

Na guia Recursos locais, selecione Adicionar recurso local.

-

Na página Adicionar recurso local, use os seguintes valores:

-

Em Resource Name (Nome do recurso), insira

videoCoreSharedMemory. -

Em Resource type, selecione Device.

-

Em Caminho do dispositivo local, insira

/dev/vcsm.O caminho do dispositivo é o caminho absoluto local do recurso do dispositivo. Este caminho só pode se referir a um dispositivo de caractere ou dispositivo de blocos em

/dev. -

Em Permissões do proprietário do grupo do sistema e de acesso a arquivos, selecione Adicionar automaticamente permissões de sistema de arquivos do grupo do sistema que é proprietário do recurso.

A opção Group owner file access permission permite conceder permissões adicionais de acesso a arquivos para o processo do Lambda. Para ter mais informações, consulte Permissão de acesso a arquivo do proprietário do grupo.

-

-

Na parte inferior da página, selecione Adicionar recurso.

-

Na guia Recursos, crie outro recurso local escolhendo Adicionar e use os seguintes valores:

-

Em Resource Name (Nome do recurso), insira

videoCoreInterface. -

Em Resource type, selecione Device.

-

Em Caminho do dispositivo local, insira

/dev/vchiq. -

Em Permissões do proprietário do grupo do sistema e de acesso a arquivos, selecione Adicionar automaticamente permissões de sistema de arquivos do grupo do sistema que é proprietário do recurso.

-

-

Selecione Adicionar recurso.

Etapa 7: Adicionar assinaturas ao grupo do Greengrass

Nesta etapa, adicione assinaturas ao grupo. Essas assinaturas permitem que a função do Lambda envie os resultados das previsões para AWS IoT publicando em um tópico do MQTT.

-

Na página de configuração do grupo, selecione a guia Assinaturas e, em seguida, Adicionar assinatura.

-

Na página Criar uma assinatura, configure a origem e o destino, da seguinte forma:

-

Em Tipo de destino, selecione Função do Lambda e, em seguida, optimizedImageClassification.

-

Em Tipo de destino, selecione Serviço e então IoT Cloud.

-

Em Filtro de tópicos, insira

/resnet-50/predictionse, em seguida, selecione Criar assinatura.

-

-

Adicione uma segunda assinatura. Selecione a guia Assinaturas, selecione Adicionar assinatura e configure a origem e o destino, da seguinte forma:

-

Em Tipo de origem, selecione Serviços e em seguida IoT Cloud.

-

Em Tipo de destino, selecione Função do Lambda e, em seguida, selecione optimizedImageClassification.

-

Em Filtro de tópicos, insira

/resnet-50/teste, em seguida, selecione Criar assinatura.

-

Etapa 8: Implantar o grupo do Greengrass

Nesta etapa, implante a versão atual da definição do grupo ao dispositivo de núcleo do Greengrass. A definição contém a função do Lambda, recursos e configurações de inscrição que você adicionou.

-

Verifique se o núcleo AWS IoT Greengrass está em execução. Execute os seguintes comandos no seu terminal do Raspberry Pi, conforme necessário.

-

Para verificar se o daemon está em execução:

ps aux | grep -E 'greengrass.*daemon'Se a saída contém uma entrada

rootpara/greengrass/ggc/packages/, o daemon está em execução.latest-core-version/bin/daemon Para iniciar o daemon:

cd /greengrass/ggc/core/ sudo ./greengrassd start

-

-

Na página de configuração do grupo, selecione Implantar.

-

Na guia Funções do Lambda, selecione Detector de IP e selecione Editar.

-

Na caixa de diálogo Editar configurações do detector de IP, selecione Detectar e substituir automaticamente os endpoints de atendente MQTT e selecione Salvar.

Isso permite que os dispositivos adquiram automaticamente as informações de conectividade para o núcleo, como endereço IP, DNS e o número da porta. A detecção automática é recomendada, mas o AWS IoT Greengrass também oferece suporte a endpoints especificados manualmente. Você só é solicitado pelo método de descoberta na primeira vez em que o grupo for implantado.

nota

Se solicitado, conceda permissão para criar a função de serviço do Greengrass e associá-la à sua Conta da AWS na Região da AWS atual. Essa função permite que AWS IoT Greengrass acessem seus recursos nos serviços do AWS.

A página Deployments mostra a data e hora, ID de versão e status da implantação. Quando concluída, o status exibido para a implantação deve ser Concluída.

Para obter mais informações sobre implantações, consulte Implantar grupos do AWS IoT Greengrass em um núcleo do AWS IoT Greengrass. Para obter ajuda sobre a solução de problemas, consulte Solução de problemas de AWS IoT Greengrass.

Testar o exemplo de inferência

Agora você pode verificar se a implementação foi configurada corretamente. Para testar, inscreva-se no tópico /resnet-50/predictions e publique qualquer mensagem no tópico /resnet-50/test. Isso aciona a função do Lambda para tirar uma foto com seu Raspberry Pi e executar inferência na imagem capturada.

nota

Se estiver usando o exemplo do NVIDIA Jetson, use os tópicos resnet-18/predictions e resnet-18/test.

nota

Se um monitor estiver conectado ao Raspberry Pi, o feed da câmera ao vivo será exibido em uma janela de visualização.

-

Na página inicial do console de AWS IoT, em Teste, selecione Cliente de teste MQTT.

-

Em Assinaturas, selecione Inscrever-se em um tópico. Use os seguintes valores. Deixe as opções restantes em seus valores padrão.

-

Em Subscription topic (Tópico de assinatura), insira

/resnet-50/predictions. -

Em Configuração adicional, para exibição da carga útil do MQTT, selecione Exibir cargas úteis como strings.

-

-

Selecione Subscribe.

-

Selecione Publicar em um tópico, insira

/resnet-50/testcomo o Nome do tópico e selecione Publicar. -

Se o teste for bem-sucedido, a mensagem publicada faz com que a câmera do Raspberry Pi capture uma imagem. Uma mensagem da função do Lambda é exibida na parte inferior da página. A mensagem contém o resultado de previsão da imagem, usando o formato: nome da classe prevista, probabilidade e pico de utilização da memória.

Como configurar um Intel Atom

Para executar este tutorial em um dispositivo Intel Atom, você deve fornecer imagens de origem, configurar a função do Lambda e adicionar outro recurso de dispositivo local. Para usar a GPU para inferência, verifique se o software a seguir está instalado no dispositivo:

-

OpenCL versão 1.0 ou posterior

-

Python 3.7 e pip

-

Faça download de imagens PNG ou JPG estáticas para a função do Lambda para usá-las na classificação de imagens. O exemplo funciona melhor com arquivos de imagem pequenos.

Salve os arquivos de imagem no diretório que contém o arquivo

inference.py(ou em um subdiretório desse diretório). Isso está no pacote de implantação da função do Lambda do qual você fez upload em Etapa 3: Criar uma função de inferência da função do Lambda.nota

Se estiver usando o AWS DeepLens, poderá usar a câmera integrada ou montar sua própria câmera para realizar inferência em imagens capturadas em vez de imagens estáticas. No entanto, recomendamos que você comece com imagens estáticas primeiro.

Se utilizar uma câmara, verifique se o pacote APT

awscamestá instalado e atualizado. Para mais informações, consulte Atualizar seu AWS DeepLens dispositivo no AWS DeepLens Guia do desenvolvedor. -

Edite a configuração da função do Lambda. Siga o procedimento em Etapa 4: adicionar a função do Lambda ao grupo do Greengrass.

nota

Recomendamos que você execute sua função do Lambda sem conteinerização, a menos que seu caso de negócios faça essa exigência. Isso ajuda a habilitar o acesso à GPU e à câmera do seu dispositivo sem configurar os recursos do dispositivo. Se você executar sem conteinerização, também deverá conceder acesso root às suas funções do Lambda do AWS IoT Greengrass.

-

Para executar sem conteinerização:

-

Para Usuário e grupo do sistema, selecione

Another user ID/group ID. Para ID de usuário do sistema, insira0. Para ID do grupo do sistema, insira0.Isso permite que sua função do Lambda seja executada como root. Para obter mais informações sobre como executar como raiz, consulte Definir a identidade de acesso padrão para as funções do Lambda em um grupo.

dica

Você também deve atualizar seu arquivo

config.jsonpara conceder acesso root à sua função do Lambda. Para o procedimento, consulte Executar uma função do Lambda como raiz. -

Para conteinerização da função do Lambda, selecione Sem contêiner.

Para obter mais informações sobre como executar sem conteinerização, consulte Considerações ao escolher a conteinerização de função do Lambda.

-

Aumente o valor de Timeout (Tempo limite) para 2 minutos. Isso garante que a solicitação não expire muito cedo. Leva alguns minutos para que a inferência seja executada após a configuração.

-

Para Fixado, selecione Verdadeiro.

-

Em Parâmetros adicionais, para Acesso de leitura ao diretório /sys, selecione Habilitado.

-

-

Em vez disso, para executar no modo conteinerizado:

nota

Não recomendamos a execução no modo conteinerizado, a menos que seu caso de negócios faça essa exigência.

-

Aumente o valor de Memory limit (Limite de memória) para 3000 MB.

-

Aumente o valor de Timeout (Tempo limite) para 2 minutos. Isso garante que a solicitação não expire muito cedo. Leva alguns minutos para que a inferência seja executada após a configuração.

-

Para Fixado, selecione Verdadeiro.

-

Em Parâmetros adicionais, para Acesso de leitura ao diretório /sys, selecione Habilitado.

-

-

-

Adicione seu recurso de modelo otimizado do Neo ao grupo Carregue os recursos do modelo no diretório

resnet50do pacote de amostra que você descompactou em Etapa 3: Criar uma função de inferência da função do Lambda. Esse diretório contém artefatos de modelo pré-compilados para um modelo de classificação de imagem treinado com Resnet-50. Use o procedimento em Etapa 5: Adicionar um recurso de modelo otimizado do SageMaster Neo ao grupo do Greengrass com as seguintes atualizações.-

Compacte os arquivos dentro do diretório

resnet50em um arquivo chamadoresnet50.zip. -

Na página Create a machine learning resource (Criar recurso de Machine Learning), em Resource name (Nome do recurso), insira

resnet50_model. -

Carregue o arquivo

resnet50.zip.

-

-

Se estiver executando no modo conteinerizado, adicione o recurso de dispositivo local necessário para conceder acesso à GPU do seu dispositivo.

nota

Se você executar no modo não conteinerizado, o AWS IoT Greengrass poderá acessar a GPU do seu dispositivo sem configurar os recursos do dispositivo.

-

Na página de configuração do grupo, selecione a guia Recursos.

-

Na seção Recursos locais, selecione Adicionar recurso local.

-

Defina o recurso:

-

Em Resource Name (Nome do recurso), insira

renderD128. -

Em Resource type, selecione Device.

-

Em Caminho do dispositivo local, insira

/dev/dri/renderD128. -

Em Permissões do proprietário do grupo do sistema e de acesso a arquivos, selecione Adicionar automaticamente permissões de sistema de arquivos do grupo do sistema que é proprietário do recurso.

-

-

Configuração NVIDIA Jetson TX2

Para executar este tutorial em um NVIDIA Jetson TX2, forneça imagens de origem, configure a função do Lambda e adicione mais recursos de dispositivo local.

-

Verifique se o dispositivo Jetson está configurado para que você possa instalar o software do AWS IoT Greengrass Core e usar a GPU para inferência. Para obter mais informações sobre como configurar seu projeto, consulte Configurar outros dispositivos. Para usar a GPU para inferência em um NVIDIA Jetson TX2, você deve instalar o CUDA 10.0 e cuDNN 7.0 no dispositivo quando você fizer a imagem da sua placa com Jetpack 4.3.

-

Faça download de imagens PNG ou JPG estáticas para a função do Lambda para usá-las na classificação de imagens. O exemplo funciona melhor com arquivos de imagem pequenos.

Salve seus arquivos de imagem no diretório que contém o arquivo

inference.py. Você também pode salvá-los em um subdiretório desse diretório. Esse diretório está no pacote de implantação da função do Lambda do qual você fez upload em Etapa 3: Criar uma função de inferência da função do Lambda.nota

Em vez disso, você pode optar por instrumentar uma câmera na placa Jetson para capturar as imagens de origem. No entanto, recomendamos que você comece com imagens estáticas primeiro.

-

Edite a configuração da função do Lambda. Siga o procedimento em Etapa 4: adicionar a função do Lambda ao grupo do Greengrass.

nota

Recomendamos que você execute sua função do Lambda sem conteinerização, a menos que seu caso de negócios faça essa exigência. Isso ajuda a habilitar o acesso à GPU e à câmera do seu dispositivo sem configurar os recursos do dispositivo. Se você executar sem conteinerização, também deverá conceder acesso root às suas funções do Lambda do AWS IoT Greengrass.

-

Para executar sem conteinerização:

-

Para Executar como, selecione

Another user ID/group ID. Em UID, insira0. Para GUID, insira0.Isso permite que sua função do Lambda seja executada como root. Para obter mais informações sobre como executar como raiz, consulte Definir a identidade de acesso padrão para as funções do Lambda em um grupo.

dica

Você também deve atualizar seu arquivo

config.jsonpara conceder acesso root à sua função do Lambda. Para o procedimento, consulte Executar uma função do Lambda como raiz. -

Para conteinerização da função do Lambda, selecione Sem contêiner.

Para obter mais informações sobre como executar sem conteinerização, consulte Considerações ao escolher a conteinerização de função do Lambda.

-

Aumente o valor de Timeout (Tempo limite) para 5 minutos. Isso garante que a solicitação não expire muito cedo. Leva alguns minutos para que a inferência seja executada após a configuração.

-

Para Fixado, selecione Verdadeiro.

-

Em Parâmetros adicionais, para Acesso de leitura ao diretório /sys, selecione Habilitado.

-

-

Em vez disso, para executar no modo conteinerizado:

nota

Não recomendamos a execução no modo conteinerizado, a menos que seu caso de negócios faça essa exigência.

-

Aumente o valor de Memory limit (Limite de memória). Para usar o modelo fornecido no modo de GPU, use 2000 MB.

-

Aumente o valor de Timeout (Tempo limite) para 5 minutos. Isso garante que a solicitação não expire muito cedo. Leva alguns minutos para que a inferência seja executada após a configuração.

-

Para Fixado, selecione Verdadeiro.

-

Em Parâmetros adicionais, para Acesso de leitura ao diretório /sys, selecione Habilitado.

-

-

-

Adicione seu recurso de modelo otimizado do Neo ao grupo Carregue os recursos do modelo no diretório

resnet18do pacote de amostra que você descompactou em Etapa 3: Criar uma função de inferência da função do Lambda. Esse diretório contém artefatos de modelo pré-compilados para um modelo de classificação de imagem treinado com Resnet-18. Use o procedimento em Etapa 5: Adicionar um recurso de modelo otimizado do SageMaster Neo ao grupo do Greengrass com as seguintes atualizações.-

Compacte os arquivos dentro do diretório

resnet18em um arquivo chamadoresnet18.zip. -

Na página Create a machine learning resource (Criar recurso de Machine Learning), em Resource name (Nome do recurso), insira

resnet18_model. -

Carregue o arquivo

resnet18.zip.

-

-

Se estiver executando no modo conteinerizado, adicione os recursos de dispositivo local necessários para conceder acesso à GPU do seu dispositivo.

nota

Se você executar no modo não conteinerizado, o AWS IoT Greengrass poderá acessar a GPU do seu dispositivo sem configurar os recursos do dispositivo.

-

Na página de configuração do grupo, selecione a guia Recursos.

-

Na seção Recursos locais, selecione Adicionar recurso local.

-

Defina cada recurso:

-

Em Resource name (Nome do recurso) e Device path (Caminho do dispositivo), use os valores na tabela a seguir. Crie um recurso de dispositivo para cada linha na tabela.

-

Em Resource type, selecione Device.

-

Em Permissões do proprietário do grupo do sistema e de acesso a arquivos, selecione Adicionar automaticamente permissões de sistema de arquivos do grupo do sistema que é proprietário do recurso.

Nome

Caminho do dispositivo

nvhost-ctrl

/dev/nvhost-ctrl

nvhost-gpu

/dev/nvhost-gpu

nvhost-ctrl-gpu

/dev/nvhost-ctrl-gpu

nvhost-dbg-gpu

/dev/nvhost-dbg-gpu

nvhost-prof-gpu

/dev/nvhost-prof-gpu

nvmap

/dev/nvmap

nvhost-vic

/dev/nvhost-vic

tegra_dc_ctrl

/dev/tegra_dc_ctrl

-

-

-

Se estiver executando no modo conteinerizado, adicione o recurso de volume local a seguir para conceder acesso à câmera do seu dispositivo. Siga o procedimento em Etapa 5: Adicionar um recurso de modelo otimizado do SageMaster Neo ao grupo do Greengrass.

nota

Se você executar no modo não conteinerizado, o AWS IoT Greengrass poderá acessar a câmera do seu dispositivo sem configurar os recursos do dispositivo.

-

Em Tipo de recurso, selecione Volume.

-

Em Permissões do proprietário do grupo do sistema e de acesso a arquivos, selecione Adicionar automaticamente permissões de sistema de arquivos do grupo do sistema que é proprietário do recurso.

Nome

Caminho de origem

Caminho de destino

shm

/dev/shm

/dev/shm

.tmp

/tmp

/tmp

-

-

Atualize suas assinaturas de grupo para usar o diretório correto. Use o procedimento em Etapa 7: Adicionar assinaturas ao grupo do Greengrass com as seguintes atualizações.

-

Para o primeiro filtro de tópico, digite

/resnet-18/predictions. -

Para o segundo filtro de tópico, digite

/resnet-18/test.

-

-

Atualize suas assinaturas de teste para usar o diretório correto. Use o procedimento em Testar o exemplo de inferência com as seguintes atualizações.

-

Em Assinaturas, selecione Inscrever-se em um tópico. Em Subscription topic (Tópico de assinatura), insira

/resnet-18/predictions. -

Na página

/resnet-18/predictions, especifique o tópico/resnet-18/testno qual publicar.

-

Solução de problemas de inferência de ML do AWS IoT Greengrass

Se o teste não for bem-sucedido, você poderá tentar as etapas de solução de problemas a seguir. Execute os comandos no seu terminal Raspberry Pi.

Verificar logs de erros

-

Alterne para o usuário raiz e navegue até o diretório

log. O acesso aos logs do AWS IoT Greengrass requer permissões raiz.sudo su cd /greengrass/ggc/var/log -

Verifique

runtime.logem busca de algum erro.cat system/runtime.log | grep 'ERROR'Você também pode verificar em seu log se há erros na sua função do Lambda definida pelo usuário:

cat user/your-region/your-account-id/lambda-function-name.log | grep 'ERROR'Para ter mais informações, consulte Solução de problemas com logs.

Verifique se a função do Lambda foi implantada com êxito

-

Liste o conteúdo do Lambda implementado no diretório

/lambda. Substitua os valores de espaço reservado antes de executar o comando.cd /greengrass/ggc/deployment/lambda/arn:aws:lambda:region:account:function:function-name:function-versionls -la -

Verifique se o diretório contém o mesmo conteúdo do pacote de implantação

optimizedImageClassification.zipque você carregou no Etapa 3: Criar uma função de inferência da função do Lambda.Verifique se os arquivos

.pye as dependências estão na raiz do diretório.

Verifique se o modelo de inferência foi implantado com sucesso

-

Encontre o número de identificação de processo (PID) do runtime do Lambda:

ps aux | greplambda-function-nameNa saída, o PID aparece na segunda coluna da linha para o processo de runtime do Lambda.

-

Digite o namespace de runtime do Lambda. Lembre-se de substituir o valor do espaço reservado

pidantes de executar o comando.nota

Este diretório e seu conteúdo estão no namespace de runtime do Lambda para que não sejam visíveis em um namespace comum do Linux.

sudo nsenter -tpid-m /bin/bash -

Liste o conteúdo do diretório local que você especificou para o recurso de ML.

nota

Se o caminho do recurso de ML for diferente de

ml_model, você deverá substituí-lo aqui.cd /ml_model ls -lsVocê deve ver os arquivos a seguir:

56 -rw-r--r-- 1 ggc_user ggc_group 56703 Oct 29 20:07 model.json 196152 -rw-r--r-- 1 ggc_user ggc_group 200855043 Oct 29 20:08 model.params 256 -rw-r--r-- 1 ggc_user ggc_group 261848 Oct 29 20:07 model.so 32 -rw-r--r-- 1 ggc_user ggc_group 30564 Oct 29 20:08 synset.txt

A função Lambda não consegue encontrar /dev/dri/renderD128

Isso poderá ocorrer se o OpenCL não puder se conectar aos dispositivos de GPU de que precisa. Você deve criar recursos de dispositivo para os dispositivos necessários para a função do lambda.

Próximas etapas

Em seguida, explore outros modelos otimizados. Para obter informações, consulte a documentação do SageMaker Neo.