Amazon Forecast non è più disponibile per i nuovi clienti. I clienti esistenti di Amazon Forecast possono continuare a utilizzare il servizio normalmente. Scopri di più»

Le traduzioni sono generate tramite traduzione automatica. In caso di conflitto tra il contenuto di una traduzione e la versione originale in Inglese, quest'ultima prevarrà.

Valutazione dell'accuratezza dei predittori

Amazon Forecast produce metriche di precisione per valutare i predittori e aiutarti a scegliere quali utilizzare per generare previsioni. Forecast valuta i predittori utilizzando le metriche Root Mean Square Error (RMSE), Weighted Quantile Loss (wQL), Mean Absolute Percentage Error (MAPE), Mean Absolute Scaled Error (MASE) e Weighted Absolute Percentage Error (WAPE).

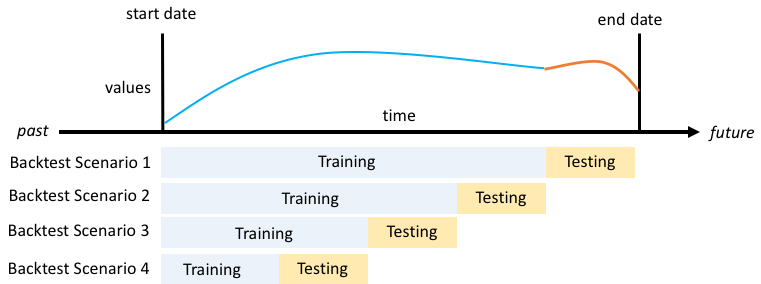

Amazon Forecast utilizza il backtesting per ottimizzare i parametri e produrre metriche di precisione. Durante il backtest, Forecast divide automaticamente i dati delle serie temporali in due set: un set di allenamento e un set di test. Il set di formazione viene utilizzato per addestrare un modello e generare previsioni per i punti dati all'interno del set di test. Forecast valuta l'accuratezza del modello confrontando i valori previsti con i valori osservati nel set di test.

Forecast consente di valutare i predittori utilizzando diversi tipi di previsione, che possono essere un insieme di previsioni quantili e la previsione media. La previsione media fornisce una stima puntuale, mentre le previsioni quantiliche forniscono in genere una serie di risultati possibili.

Quaderni in Python

Argomenti

Interpretazione delle metriche di precisione

Amazon Forecast fornisce i parametri Root Mean Square Error (RMSE), Weighted Quantile Loss (wQL), Average Weighted Quantile Loss (Average wQL), Mean Absolute Scaled Error (MASE), Mean Absolute Percentage Error (MAPE) e Weighted Absolute Percentage Error (WAPE) per valutare i tuoi predittori. Oltre alle metriche per il predittore generale, Forecast calcola le metriche per ogni finestra di backtest.

Puoi visualizzare le metriche di precisione per i tuoi predittori utilizzando l'Amazon Forecast Software Development Kit (SDK) e la console Amazon Forecast.

Utilizzando l'GetAccuracyMetricsOperation, specifica di visualizzare i parametri RMSE, PredictorArn MASE, MAPE, WAPE, Average wQl e wQl per ogni backtest.

{

"PredictorArn": "arn:aws:forecast:region:acct-id:predictor/example-id"

}

Nota

Per le metriche Average wQl, wQl, RMSE, MASE, MAPE e WAPE, un valore inferiore indica un modello superiore.

Argomenti

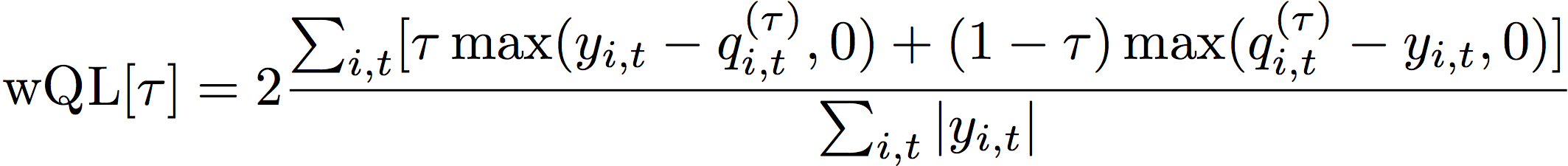

Perdita quantile ponderata (wQl)

La metrica Weighted Quantile Loss (wQL) misura l'accuratezza di un modello in base a un quantile specificato. È particolarmente utile in presenza di costi diversi dovuti alla sottoprevisione e alla previsione eccessiva. Impostando il peso (thm) della funzione wQl, è possibile incorporare automaticamente diverse penalità in caso di previsione insufficiente e eccessiva.

La funzione di perdita viene calcolata come segue.

- Dove:

-

□ - un quantile nell'insieme {0,01, 0,02,..., 0,99}

q i,t (□) - il τ-quantile previsto dal modello.

y i,t - il valore osservato nel punto (i, t)

I quantili (□) per wQl possono variare da 0,01 (P1) a 0,99 (P99). La metrica wQl non può essere calcolata per la previsione media.

Per impostazione predefinita, Forecast calcola wQl a 0.1 (P10), 0.5 (P50) e 0.9 (P90).

-

P10 (0.1): il valore reale dovrebbe essere inferiore al valore previsto il 10% delle volte.

-

P50 (0,5) - Il valore reale dovrebbe essere inferiore al valore previsto il 50% delle volte. Questa è anche nota come previsione mediana.

-

P90 (0,9) - Il valore reale dovrebbe essere inferiore al valore previsto il 90% delle volte.

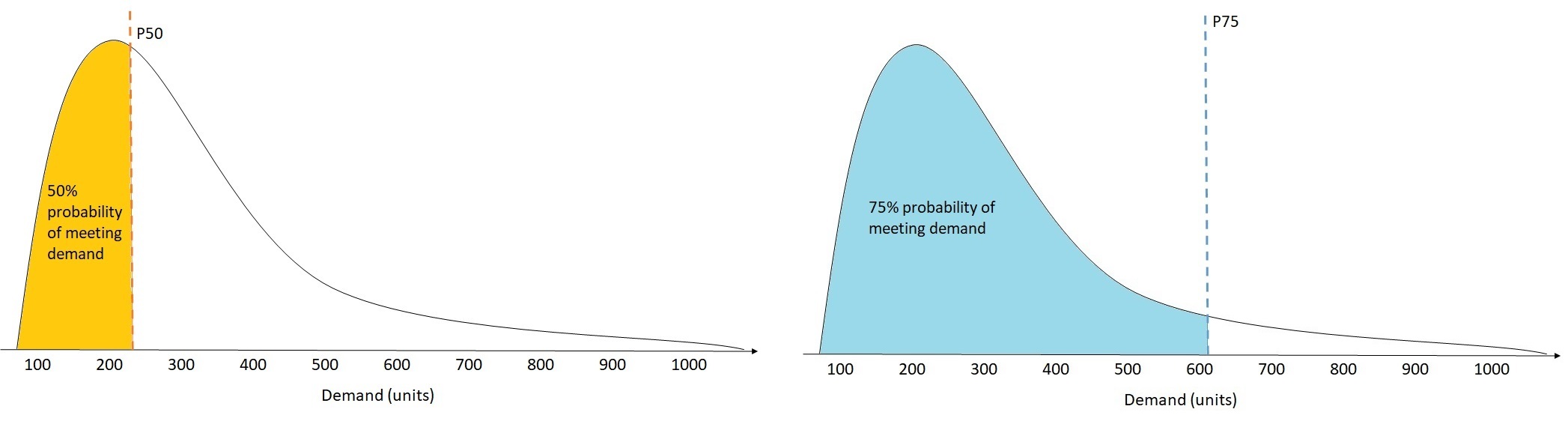

Nel settore della vendita al dettaglio, il costo della sottocategoria è spesso superiore al costo dell'eccesso di scorte, per cui una previsione a P75 (= 0,75) può essere più informativa rispetto alla previsione al quantile mediano (P50). In questi casi, wQl [0,75] assegna un peso di penalità maggiore alla sottoprevisione (0,75) e un peso di penalità inferiore alla sovraprevisione (0,25).

La figura precedente mostra le diverse previsioni della domanda per wQl [0,50] e wQl [0,75]. Il valore previsto a P75 è significativamente superiore al valore previsto a P50 perché si prevede che la previsione P75 soddisfi la domanda il 75% delle volte, mentre la previsione P50 dovrebbe soddisfare la domanda solo il 50% delle volte.

Quando la somma dei valori osservati su tutti gli elementi e i punti temporali è approssimativamente zero in una determinata finestra di backtest, l'espressione della perdita quantile ponderata non è definita. In questi casi, Forecast restituisce la perdita quantile non ponderata, che è il numeratore nell'espressione wQl.

Forecast calcola anche il wQl medio, che è il valore medio delle perdite quantili ponderate su tutti i quantili specificati. Per impostazione predefinita, questa sarà la media di wQl [0,10], wQl [0,50] e wQl [0,90].

Errore percentuale assoluto ponderato (WAPE)

L'errore percentuale assoluto ponderato (WAPE) misura la deviazione complessiva dei valori previsti dai valori osservati. Il WAPE viene calcolato prendendo la somma dei valori osservati e la somma dei valori previsti e calcolando l'errore tra questi due valori. Un valore più basso indica un modello più accurato.

Quando la somma dei valori osservati per tutti i punti temporali e tutti gli elementi è approssimativamente zero in una determinata finestra di backtest, l'espressione di errore percentuale assoluta ponderata non è definita. In questi casi, Forecast restituisce la somma degli errori assoluti non ponderati, che è il numeratore nell'espressione WAPE.

- Dove:

-

y i,t - il valore osservato nel punto (i, t)

i,t- il valore previsto nel punto (i, t)

Forecast utilizza la previsione media come valore previsto,. i,t

WAPE è più resistente ai valori anomali rispetto a Root Mean Square Error (RMSE) perché utilizza l'errore assoluto anziché l'errore quadratico.

Amazon Forecast si riferiva in precedenza alla metrica WAPE come Mean Absolute Percentage Error (MAPE) e utilizzava la previsione mediana (P50) come valore previsto. Forecast ora utilizza la previsione media per calcolare WAPE. La metrica wQl [0,5] è equivalente alla metrica WAPE [mediana], come illustrato di seguito:

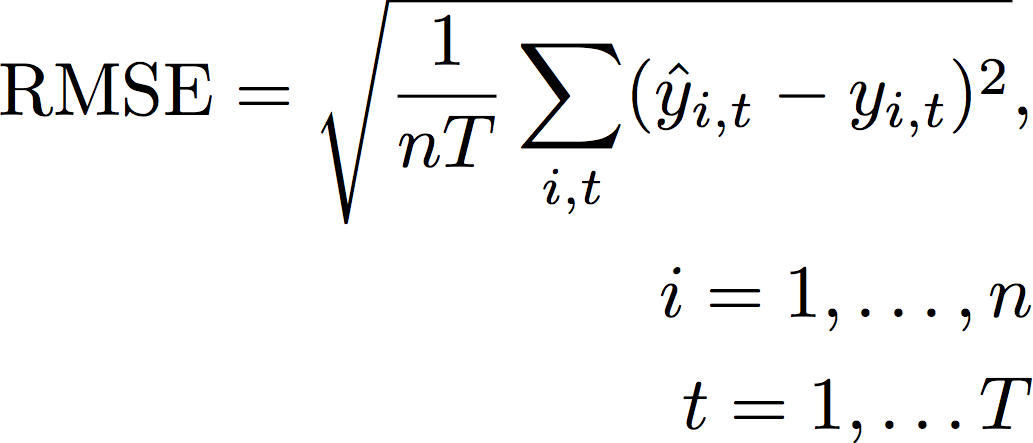

Root Mean Square Error (RMSE)

Il Root Mean Square Error (RMSE) è la radice quadrata della media degli errori quadratici ed è quindi più sensibile ai valori anomali rispetto ad altre metriche di precisione. Un valore più basso indica un modello più accurato.

- Dove:

-

y i,t - il valore osservato nel punto (i, t)

i,t- il valore previsto nel punto (i, t)

nT: il numero di punti dati in un set di test

Forecast utilizza la previsione media come valore previsto,. i,t Nel calcolo delle metriche predittive, nT è il numero di punti dati in una finestra di backtest.

RMSE utilizza il valore quadrato dei residui, che amplifica l'impatto dei valori anomali. Nei casi d'uso in cui solo poche previsioni errate di grandi dimensioni possono rivelarsi molto costose, l'RMSE è la metrica più pertinente.

Per impostazione predefinita, i predittori creati prima dell'11 novembre 2020 hanno calcolato l'RMSE utilizzando il quantile 0,5 (P50). Forecast ora utilizza la previsione media.

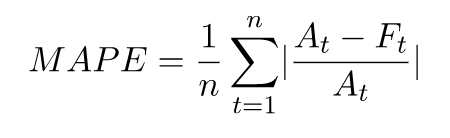

Errore percentuale assoluto medio (MAPE)

L'errore percentuale assoluto medio (MAPE) calcola il valore assoluto dell'errore percentuale tra i valori osservati e quelli previsti per ogni unità di tempo, quindi calcola la media di tali valori. Un valore più basso indica un modello più accurato.

- Dove:

-

A t - il valore osservato nel punto t

F t - il valore previsto nel punto t

n - il numero di punti dati nella serie temporale

Forecast utilizza la previsione media come valore previsto, F. t

MAPE è utile nei casi in cui i valori differiscono in modo significativo tra i punti temporali e gli outlier hanno un impatto significativo.

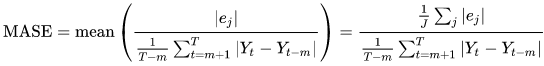

Errore scalato assoluto medio (MASE)

L'errore scalabile assoluto medio (MASE) viene calcolato dividendo l'errore medio per un fattore di scala. Questo fattore di scala dipende dal valore di stagionalità, m, selezionato in base alla frequenza della previsione. Un valore più basso indica un modello più accurato.

- Dove:

-

Y t - il valore osservato nel punto t

Y t-m - il valore osservato nel punto t-m

e j - l'errore nel punto j (valore osservato - valore previsto)

m - il valore della stagionalità

Forecast utilizza la previsione media come valore previsto.

MASE è ideale per set di dati di natura ciclica o con proprietà stagionali. Ad esempio, la previsione degli articoli che sono molto richiesti durante l'estate e scarsamente richiesti durante gli inverni può trarre vantaggio dalla considerazione dell'impatto stagionale.

Esportazione delle metriche di precisione

Nota

I file di esportazione possono restituire direttamente le informazioni dall'importazione del set di dati. Ciò rende i file vulnerabili all'iniezione di file CSV se i dati importati contengono formule o comandi. Per questo motivo, i file esportati possono richiedere avvisi di sicurezza. Per evitare attività dannose, disattivate i link e le macro durante la lettura dei file esportati.

Forecast consente di esportare i valori previsti e le metriche di precisione generate durante il backtest.

Puoi utilizzare queste esportazioni per valutare elementi specifici in momenti e quantili specifici e comprendere meglio il tuo predittore. Le esportazioni backtest vengono inviate a una posizione S3 specificata e contengono due cartelle:

-

valori previsti: contiene file CSV o Parquet con valori previsti per ogni tipo di previsione per ogni backtest.

-

accuracy-metrics-values: Contiene file CSV o Parquet con metriche per ogni backtest, oltre alla media di tutti i backtest. Queste metriche includono wQl per ogni quantile, Average wQl, RMSE, MASE, MAPE e WAPE.

La forecasted-values cartella contiene i valori previsti per ogni tipo di previsione per ogni finestra di backtest. Include anche informazioni sull'elemento IDs, le dimensioni, i timestamp, i valori target e gli orari di inizio e fine della finestra di backtest.

La accuracy-metrics-values cartella contiene le metriche di precisione per ogni finestra di backtest, nonché le metriche medie di tutte le finestre di backtest. Contiene le metriche wQl per ogni quantile specificato, oltre alle metriche Average wQl, RMSE, MASE, MAPE e WAPE.

I file all'interno di entrambe le cartelle seguono la convenzione di denominazione:. <ExportJobName>_<ExportTimestamp>_<PartNumber>.csv

Puoi esportare i parametri di precisione utilizzando l'Amazon Forecast Software Development Kit (SDK) e la console Amazon Forecast.

Utilizzando l'CreatePredictorBacktestExportJoboperazione, specifica la posizione S3 e il ruolo IAM nell'DataDestinationoggetto, insieme a and. PredictorArn PredictorBacktestExportJobName

Per esempio:

{

"Destination": {

"S3Config": {

"Path": "s3://bucket/example-path/",

"RoleArn": "arn:aws:iam::000000000000:role/ExampleRole"

}

},

"Format": PARQUET;

"PredictorArn": "arn:aws:forecast:region:predictor/example",

"PredictorBacktestExportJobName": "backtest-export-name",

}

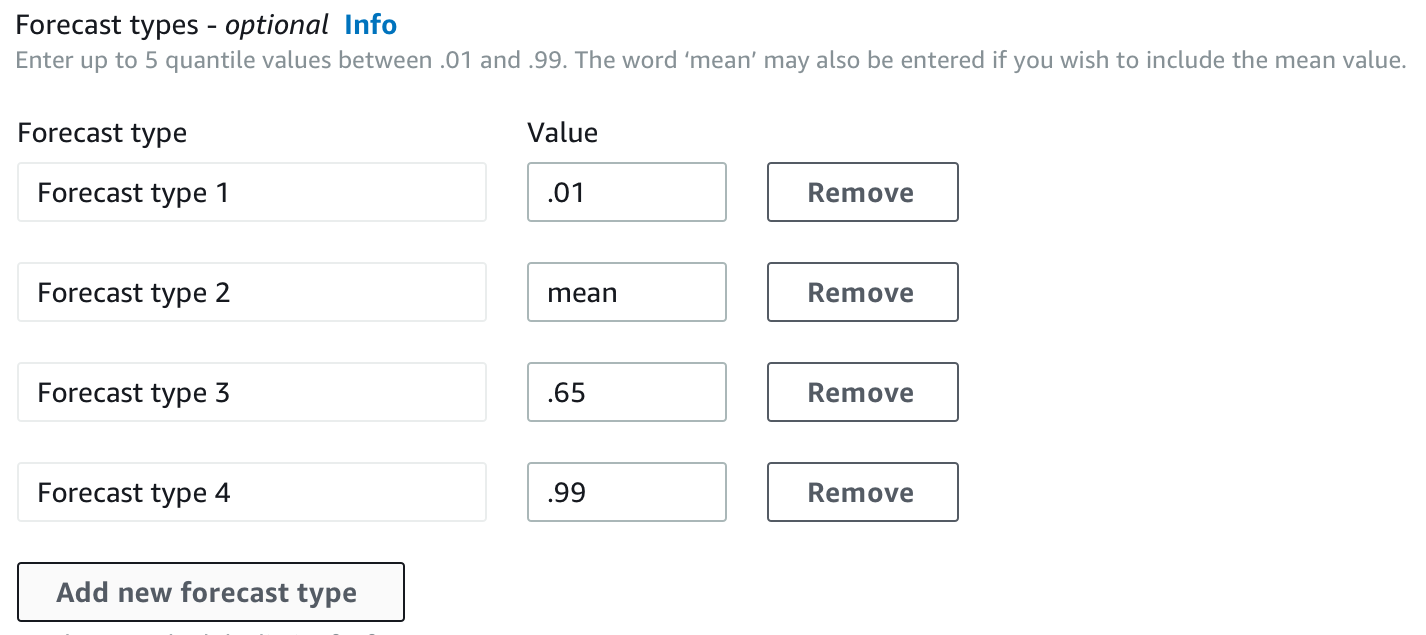

Scelta dei tipi di Forecast

Amazon Forecast utilizza i tipi di previsione per creare previsioni e valutare i predittori. I tipi di Forecast si presentano in due forme:

-

Tipo di previsione media: una previsione che utilizza la media come valore atteso. In genere viene utilizzata come previsione puntuale per un determinato punto temporale.

-

Tipo di previsione quantile: una previsione in base a un quantile specificato. In genere viene utilizzato per fornire un intervallo di previsione, che è un intervallo di valori possibili per tenere conto dell'incertezza delle previsioni. Ad esempio, una previsione al

0.65quantile stimerà un valore inferiore al valore osservato il 65% delle volte.

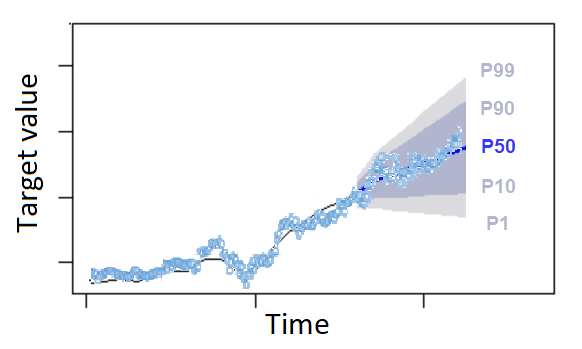

Per impostazione predefinita, Forecast utilizza i seguenti valori per i tipi di previsione predittiva: 0.1 (P10), 0.5 (P50) e 0.9 (P90). Puoi scegliere fino a cinque tipi di previsione personalizzati, inclusi mean quantili che vanno da 0.01 (P1) a (P99). 0.99

I quantili possono fornire un limite superiore e inferiore per le previsioni. Ad esempio, l'utilizzo dei tipi di previsione 0.1 (P10) e 0.9 (P90) fornisce un intervallo di valori noto come intervallo di confidenza dell'80%. Il valore osservato dovrebbe essere inferiore al valore P10 il 10% delle volte e il valore P90 dovrebbe essere superiore al valore osservato il 90% delle volte. Generando previsioni a p10 e P90, puoi aspettarti che il valore reale rientri tra questi limiti l'80% delle volte. Questo intervallo di valori è rappresentato dalla regione ombreggiata tra P10 e P90 nella figura seguente.

È inoltre possibile utilizzare una previsione quantile come previsione puntuale quando il costo della sottoprevisione è diverso dal costo della previsione eccessiva. Ad esempio, in alcuni casi di vendita al dettaglio, il costo dell'essere sottoscorte è superiore al costo di un eccesso di scorte. In questi casi, la previsione a 0,65 (P65) è più informativa rispetto alla mediana (P50) o alla previsione media.

Durante la formazione di un predittore, puoi scegliere tipi di previsione personalizzati utilizzando l'Amazon Forecast Software Development Kit (SDK) e la console Amazon Forecast.

Utilizzando l'CreateAutoPredictoroperazione, specifica i tipi di previsione personalizzati nel ForecastTypes parametro. Formattate il parametro come matrice di stringhe.

Ad esempio, per creare un predittore per i tipi 0.01mean,0.65, e 0.99 forecast, utilizzate il codice seguente.

{

"ForecastTypes": [ "0.01", "mean", "0.65", "0.99" ],

}, Lavorare con i predittori precedenti

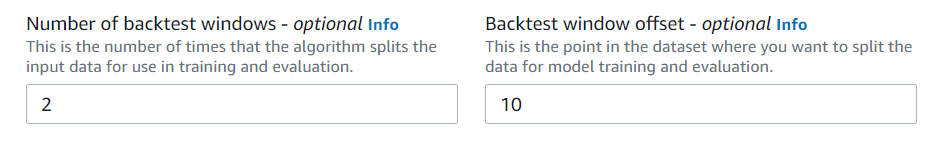

Impostazione dei parametri di backtesting

Forecast utilizza il backtesting per calcolare le metriche di precisione. Se esegui più backtest, Forecast calcola la media di ogni metrica su tutte le finestre di backtest. Per impostazione predefinita, Forecast calcola un backtest, con la dimensione della finestra di backtest (set di test) uguale alla lunghezza dell'orizzonte di previsione (finestra di previsione). È possibile impostare sia la lunghezza della finestra di backtest che il numero di scenari di backtest durante l'addestramento di un predittore.

Forecast omette i valori riempiti dal processo di backtest e qualsiasi elemento con valori riempiti all'interno di una determinata finestra di backtest verrà escluso da tale backtest. Questo perché Forecast confronta solo i valori previsti con i valori osservati durante il backtest e i valori riempiti non sono valori osservati.

La finestra di backtest deve essere grande almeno quanto l'orizzonte di previsione e inferiore alla metà della lunghezza dell'intero set di dati della serie temporale di destinazione. Puoi scegliere tra 1 e 5 backtest.

In genere, l'aumento del numero di backtest produce metriche di precisione più affidabili, poiché durante i test viene utilizzata una parte più ampia delle serie temporali e Forecast è in grado di calcolare una media delle metriche di tutti i backtest.

Puoi impostare i parametri di backtest utilizzando l'Amazon Forecast Software Development Kit (SDK) e la console Amazon Forecast.

Utilizzando l'CreatePredictoroperazione, imposta i parametri di backtest nel tipo di dati. EvaluationParameters Specificate la durata del test impostato durante il backtest con il BackTestWindowOffset parametro e il numero di finestre di backtest con il parametro. NumberOfBacktestWindows

Ad esempio, per eseguire 2 backtest con un set di test di 10 punti temporali, usa il codice seguente.

"EvaluationParameters": {

"BackTestWindowOffset": 10,

"NumberOfBacktestWindows": 2

}

HPO e AutoML

Per impostazione predefinita, Amazon Forecast utilizza i quantili 0.1 (P10), 0.5 (P50) e 0.9 (P90) per l'ottimizzazione degli iperparametri durante l'ottimizzazione degli iperparametri (HPO) e per la selezione del modello durante AutoML. Se si specificano tipi di previsione personalizzati durante la creazione di un predittore, Forecast utilizza tali tipi di previsione durante HPO e AutoML.

Se vengono specificati tipi di previsione personalizzati, Forecast utilizza tali tipi di previsione specificati per determinare i risultati ottimali durante HPO e AutoML. Durante HPO, Forecast utilizza la prima finestra di backtest per trovare i valori ottimali degli iperparametri. Durante AutoML, Forecast utilizza le medie di tutte le finestre di backtest e i valori ottimali degli iperparametri di HPO per trovare l'algoritmo ottimale.

Sia per AutoML che per HPO, Forecast sceglie l'opzione che riduce al minimo le perdite medie rispetto ai tipi di previsione. Puoi anche ottimizzare il tuo predittore durante AutoML e HPO con una delle seguenti metriche di precisione: perdita quantile ponderata media (wQL media), errore percentuale assoluto ponderato (WAPE), errore quadratico medio (RMSE), errore percentuale assoluto medio (MAPE) o errore medio assoluto scalato (MASE).

Puoi scegliere una metrica di ottimizzazione utilizzando l'Amazon Forecast Software Development Kit (SDK) e la console Amazon Forecast.

Utilizzando l'CreatePredictoroperazione, specifica i tipi di previsione personalizzati nel ObjectiveMetric parametro.

Il ObjectiveMetric parametro accetta i seguenti valori:

-

AverageWeightedQuantileLoss- Perdita quantilica ponderata media -

WAPE- Errore percentuale assoluto ponderato -

RMSE- Errore quadratico medio -

MAPE- Errore percentuale assoluto medio -

MASE- Errore scalato assoluto medio

Ad esempio, per creare un predittore con AutoML e ottimizzarlo utilizzando la metrica di precisione Mean Absolute Scaled Error (MASE), usa il codice seguente.

{

...

"PerformAutoML": "true",

...

"ObjectiveMetric": "MASE",

},