Die vorliegende Übersetzung wurde maschinell erstellt. Im Falle eines Konflikts oder eines Widerspruchs zwischen dieser übersetzten Fassung und der englischen Fassung (einschließlich infolge von Verzögerungen bei der Übersetzung) ist die englische Fassung maßgeblich.

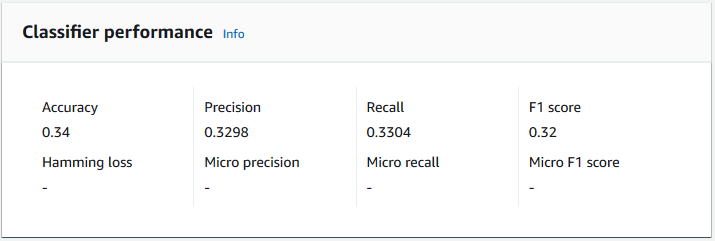

Amazon Comprehend bietet Kennzahlen, mit denen Sie abschätzen können, wie gut ein benutzerdefinierter Klassifikator abschneidet. Amazon Comprehend berechnet die Metriken anhand der Testdaten aus dem Classifier-Trainingsjob. Die Metriken stellen die Leistung des Modells während des Trainings genau dar, sodass sie ungefähr der Modellleistung für die Klassifizierung ähnlicher Daten entsprechen.

Verwenden Sie API-Operationen, DescribeDocumentClassifierum z. B. die Metriken für einen benutzerdefinierten Klassifikator abzurufen.

Anmerkung

Weitere Informationen zu den zugrunde liegenden Kennzahlen Precision, Recall und FScore F1-Score finden Sie unter Metriken:

Metriken

Amazon Comprehend unterstützt die folgenden Metriken:

Um die Metriken für einen Classifier anzuzeigen, öffnen Sie die Seite Classifier Details in der Konsole.

Accuracy

Die Genauigkeit gibt den Prozentsatz der Labels aus den Testdaten an, die das Modell genau vorhergesagt hat. Um die Genauigkeit zu berechnen, dividieren Sie die Anzahl der genau vorhergesagten Etiketten in den Testdokumenten durch die Gesamtzahl der Etiketten in den Testdokumenten.

Beispiel

| Tatsächliches Etikett | Vorhergesagtes Label | Genau/Falsch |

|---|---|---|

|

1 |

1 |

Genau |

|

0 |

1 |

Falsch |

|

2 |

3 |

Falsch |

|

3 |

3 |

Genau |

|

2 |

2 |

Genau |

|

1 |

1 |

Genau |

|

3 |

3 |

Genau |

Die Genauigkeit besteht aus der Anzahl der genauen Vorhersagen geteilt durch die Anzahl der gesamten Teststichproben = 5/7 = 0,714 oder 71,4%

Präzision (Makro-Präzision)

Präzision ist ein Maß für die Nützlichkeit der Klassifikatorergebnisse in den Testdaten. Sie ist definiert als die Anzahl der korrekt klassifizierten Dokumente geteilt durch die Gesamtzahl der Klassifizierungen für die Klasse. Hohe Genauigkeit bedeutet, dass der Klassifikator deutlich relevantere Ergebnisse als irrelevante Ergebnisse lieferte.

Die Precision Metrik wird auch als Makrogenauigkeit bezeichnet.

Das folgende Beispiel zeigt Präzisionsergebnisse für einen Testsatz.

| Label (Bezeichnung) | Größe der Stichprobe | Präzision des Etiketts |

|---|---|---|

|

Label_1 |

400 |

0.75 |

|

Bezeichnung_2 |

300 |

0,80 |

|

Bezeichnung_3 |

30000 |

0.90 |

|

Bezeichnung_4 |

20 |

0.50 |

|

Bezeichnung_5 |

10 |

0,40 |

Die Messgröße Precision (Macro Precision) für das Modell lautet daher:

Macro Precision = (0.75 + 0.80 + 0.90 + 0.50 + 0.40)/5 = 0.67Rückruf (Makrorückruf)

Dies gibt den Prozentsatz der richtigen Kategorien in Ihrem Text an, den das Modell vorhersagen kann. Diese Kennzahl ergibt sich aus der Mittelung der Erinnerungswerte aller verfügbaren Labels. Der Rückruf ist ein Maß dafür, wie vollständig die Klassifizierungsergebnisse für die Testdaten sind.

Ein hoher Erinnerungswert bedeutet, dass der Klassifikator die meisten relevanten Ergebnisse zurückgegeben hat.

Die Recall Metrik wird auch als Macro Recall bezeichnet.

Das folgende Beispiel zeigt die Rückrufergebnisse für einen Testsatz.

| Label (Bezeichnung) | Größe der Stichprobe | Rückruf des Etiketts |

|---|---|---|

|

Label_1 |

400 |

0,70 |

|

Etikett _2 |

300 |

0,70 |

|

Bezeichnung_3 |

30000 |

0,98 |

|

Bezeichnung_4 |

20 |

0,80 |

|

Bezeichnung_5 |

10 |

0.10 |

Die Recall-Metrik (Macro Recall) für das Modell lautet daher:

Macro Recall = (0.70 + 0.70 + 0.98 + 0.80 + 0.10)/5 = 0.656F1-Score (Makro-F1-Score)

Der F1-Score wird aus den Recall Werten Precision und abgeleitet. Es misst die Gesamtgenauigkeit des Klassifikators. Die höchste Punktzahl ist 1 und die niedrigste Punktzahl ist 0.

Amazon Comprehend berechnet den Macro F1 Score. Es ist der ungewichtete Durchschnitt der Label-F1-Scores. Verwenden Sie den folgenden Testsatz als Beispiel:

| Label (Bezeichnung) | Größe der Stichprobe | Etikett: F1-Score |

|---|---|---|

|

Bezeichnung_1 |

400 |

0,724 |

|

Etikett _2 |

300 |

0,824 |

|

Aufkleber_3 |

30000 |

0,94 |

|

Bezeichnung_4 |

20 |

0,62 |

|

Bezeichnung_5 |

10 |

0,16 |

Der F1-Score (Macro F1 Score) für das Modell wird wie folgt berechnet:

Macro F1 Score = (0.724 + 0.824 + 0.94 + 0.62 + 0.16)/5 = 0.6536Hamming-Verlust

Der Anteil der Labels, die falsch vorhergesagt wurden. Wird auch als Anteil falscher Labels im Vergleich zur Gesamtzahl der Labels angesehen. Werte, die näher an Null liegen, sind besser.

Mikro-Präzision

Original:

Ähnlich der Präzisionsmetrik, mit der Ausnahme, dass die Mikrogenauigkeit auf der Gesamtpunktzahl aller Präzisionswerte zusammengenommen basiert.

Mikro-Recall

Ähnlich wie bei der Recall-Metrik, mit der Ausnahme, dass der Mikro-Recall auf der Gesamtpunktzahl aller zusammengefassten Erinnerungswerte basiert.

Mikro-F1-Score

Der Micro F1-Score ist eine Kombination aus den Kennzahlen Micro Precision und Micro Recall.

Verbesserung der Leistung Ihres benutzerdefinierten Klassifikators

Die Metriken geben Aufschluss darüber, wie Ihr benutzerdefinierter Klassifikator während eines Klassifizierungsjobs abschneidet. Wenn die Metriken niedrig sind, ist das Klassifizierungsmodell für Ihren Anwendungsfall möglicherweise nicht effektiv. Sie haben mehrere Möglichkeiten, die Leistung Ihres Klassifikators zu verbessern:

-

Geben Sie in Ihren Trainingsdaten konkrete Beispiele an, die eine klare Trennung der Kategorien definieren. Stellen Sie beispielsweise Dokumente bereit, die eindeutige Wörter/Sätze verwenden, um die Kategorie darzustellen.

-

Füge weitere Daten für unterrepräsentierte Labels in deinen Trainingsdaten hinzu.

-

Versuche, die Verzerrung in den Kategorien zu reduzieren. Wenn das größte Etikett in Ihren Daten mehr als das Zehnfache der Dokumente im kleinsten Etikett enthält, versuchen Sie, die Anzahl der Dokumente für das kleinste Etikett zu erhöhen. Achten Sie darauf, das Schrägverhältnis zwischen den am stärksten repräsentierten und den am wenigsten repräsentierten Klassen auf höchstens 10:1 zu reduzieren. Sie können auch versuchen, Eingabedokumente aus den am stärksten vertretenen Klassen zu entfernen.