Las traducciones son generadas a través de traducción automática. En caso de conflicto entre la traducción y la version original de inglés, prevalecerá la version en inglés.

Puede usar Amazon SageMaker Clarify para comprender la imparcialidad y la explicabilidad de los modelos, así como para explicar y detectar sesgos en sus modelos. Puede configurar un trabajo de procesamiento de SageMaker Clarify para calcular las métricas de sesgo y las atribuciones de características y generar informes para la explicabilidad del modelo. SageMaker Los trabajos de procesamiento de Clarify se implementan mediante una imagen de contenedor especializada de SageMaker Clarify. La siguiente página describe cómo SageMaker funciona Clarify y cómo empezar con un análisis.

¿Qué es la equidad y la explicabilidad del modelo en las predicciones de machine learning?

Los modelos de machine learning (ML) están ayudando a tomar decisiones en ámbitos como los servicios financieros, la sanidad, la educación y los recursos humanos. Los responsables políticos, los reguladores y los partidarios de esta tecnología han mejorado la concienciación sobre los desafíos éticos y políticos que plantean el ML y los sistemas basados en datos. Amazon SageMaker Clarify puede ayudarlo a comprender por qué su modelo de aprendizaje automático realizó una predicción específica y si este sesgo afecta a esta predicción durante el entrenamiento o la inferencia. SageMaker Clarify también proporciona herramientas que pueden ayudarle a crear modelos de aprendizaje automático menos sesgados y más comprensibles. SageMaker Clarify también puede generar informes de gobernanza modelo que puede proporcionar a los equipos de riesgo y cumplimiento y a los reguladores externos. Con SageMaker Clarify, puede hacer lo siguiente:

-

Detectar el sesgo en las predicciones del modelo y ayudarle a explicarlas.

-

Identificar los tipos de sesgos en los datos previos al entrenamiento.

-

Identificar los tipos de sesgos en los datos posteriores al entrenamiento que pueden surgir durante el entrenamiento o cuando su modelo esté en producción.

SageMaker Clarify ayuda a explicar cómo sus modelos hacen predicciones utilizando las atribuciones de características. También puede supervisar los modelos de inferencia que están en producción para detectar tanto sesgos como desviaciones en la atribución de características. Esta información le ayuda en los siguientes aspectos:

-

Normativas: los responsables políticos y otros reguladores pueden estar preocupados por el impacto discriminatorio de las decisiones en las que se utiliza la salida de los modelos de ML. Por ejemplo, un modelo de ML podría codificar sesgos e influir en una decisión automatizada.

-

Negocios: los dominios regulados podrían necesitar explicaciones fiables sobre la forma en que los modelos de ML hacen predicciones. La explicabilidad de los modelos puede ser particularmente importante para los sectores que dependen de la fiabilidad, la seguridad y el cumplimiento. Estos pueden incluir servicios financieros, recursos humanos, atención médica y transporte automatizado. Por ejemplo, es posible que las aplicaciones de préstamos deban explicar a los responsables de los préstamos, a los pronosticadores y a los clientes cómo los modelos de ML han realizado ciertas predicciones.

-

Ciencia de datos: los científicos de datos y los ingenieros de machine learning pueden depurar y mejorar los modelos de ML cuando pueden determinar si un modelo hace inferencias basándose en características ruidosas o irrelevantes. También pueden comprender las limitaciones de sus modelos y los modos de fallos a los que pueden enfrentarse sus modelos.

Para ver una entrada de blog que muestre cómo diseñar y crear un modelo completo de aprendizaje automático para reclamaciones fraudulentas de automóviles que integre SageMaker Clarify en una cartera de SageMaker IA, consulte al arquitecto y cree el ciclo de vida completo del aprendizaje automático con AWS: una demostración de end-to-end Amazon SageMaker AI

Prácticas recomendadas para evaluar la equidad y la explicabilidad en el ciclo de vida de ML

Equidad como proceso: las nociones de sesgo y equidad dependen de la aplicación. La medición del sesgo y la elección de las métricas de sesgo pueden guiarse por consideraciones sociales, legales y de otro tipo que no son de carácter técnico. La adopción correcta de enfoques de ML que tengan en cuenta la equidad incluye la creación de consenso y el logro de una colaboración entre las principales partes interesadas. Estas pueden ser equipos de productos, políticas, legales, de ingeniería, de IA/ML, usuarios finales y comunidades.

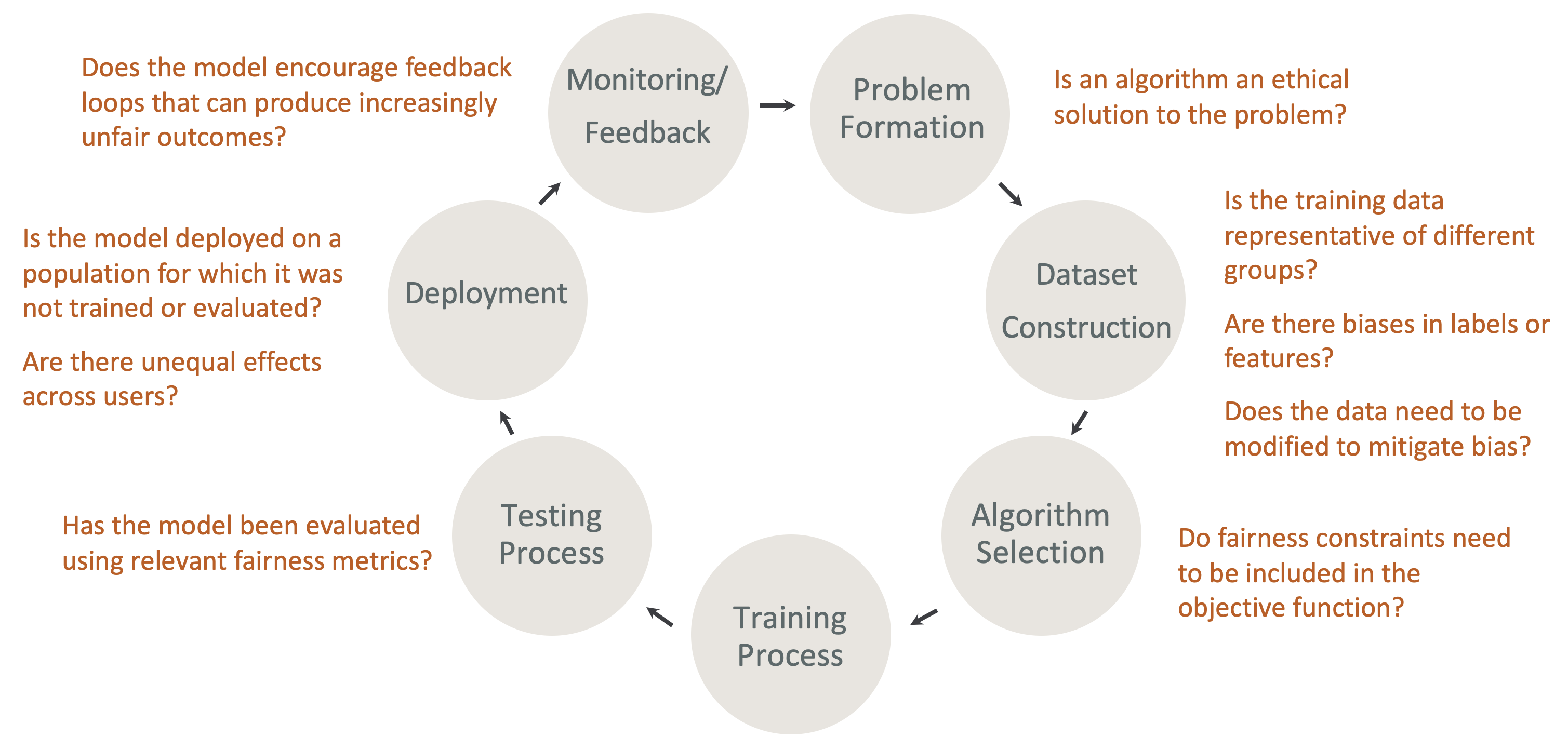

La equidad y la explicabilidad desde el diseño en el ciclo de vida de ML: tenga en cuenta la equidad y la explicabilidad en cada etapa del ciclo de vida de ML. Estas etapas incluyen la formación de problemas, la construcción del conjunto de datos, la selección de algoritmos, el proceso de entrenamiento del modelo, el proceso de pruebas, la implementación y la supervisión y comentarios. Es importante contar con las herramientas adecuadas para realizar este análisis. Recomendamos hacer las siguientes preguntas durante el ciclo de vida de ML:

-

¿Fomenta el modelo bucles de retroalimentación que pueden producir resultados cada vez más injustos?

-

¿Es un algoritmo una solución ética al problema?

-

¿Los datos de entrenamiento son representativos de diferentes grupos?

-

¿Hay sesgos en las etiquetas o en las características?

-

¿Es necesario modificar los datos para mitigar el sesgo?

-

¿Es necesario incluir restricciones de equidad en la función objetiva?

-

¿Se ha evaluado el modelo utilizando métricas de equidad relevantes?

-

¿Hay efectos desiguales entre los usuarios?

-

¿Se ha implementado el modelo en una población para la que no se ha entrenado ni evaluado?

Guía sobre las explicaciones y la documentación sobre los sesgos de la SageMaker IA

El sesgo puede producirse y medirse en los datos antes y después del entrenamiento de un modelo. SageMaker Clarify puede proporcionar explicaciones para las predicciones de los modelos después del entrenamiento y para los modelos implementados en producción. SageMaker Clarify también puede monitorear los modelos en producción para detectar cualquier desviación en sus atribuciones explicativas de referencia y calcular las líneas de base cuando sea necesario. La documentación para explicar y detectar los sesgos mediante SageMaker Clarify está estructurada de la siguiente manera:

-

Para obtener más información sobre cómo configurar un trabajo de procesamiento para tener en cuenta los sesgos y la explicabilidad, consulte Configurar un trabajo de SageMaker procesamiento de Clarify.

-

Para obtener más información sobre cómo detectar sesgos en los datos de preprocesamiento antes de utilizarlos para entrenar un modelo, consulte Sesgo de los datos previo al entrenamiento.

-

Para obtener más información sobre la detección de los datos posteriores al entrenamiento y sesgos del modelo, consulte Sesgo de los datos y el modelo posterior al entrenamiento.

-

Para obtener más información sobre el enfoque de atribución de características independiente del modelo para explicar las predicciones del modelo después del entrenamiento, consulte Explicabilidad del modelo.

-

Para obtener más información sobre cómo supervisar la desviación de las contribuciones de las características respecto de la referencia que se estableció durante el entrenamiento del modelo, consulte Desviación en la atribución de características de los modelos en producción.

-

Para obtener más información sobre la supervisión de los modelos que están en producción para determinar la desviación de la referencia, consulte Desviación de sesgo de modelos en producción.

-

Para obtener información sobre cómo obtener explicaciones en tiempo real desde un punto final de SageMaker IA, consulteExplicabilidad en línea con Clarify SageMaker .

Cómo funcionan los SageMaker trabajos de procesamiento de Clarify

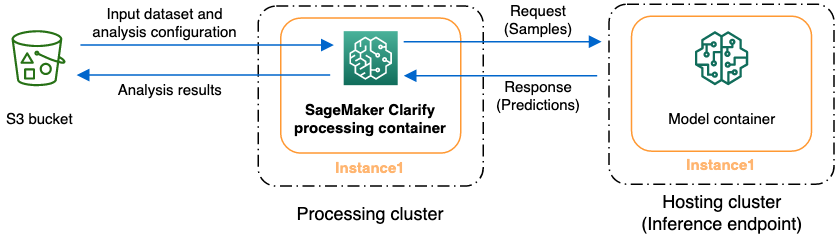

Puede usar SageMaker Clarify para analizar sus conjuntos de datos y modelos para determinar si son explicables y sesgados. Un trabajo SageMaker de procesamiento de Clarify utiliza el SageMaker contenedor de procesamiento de Clarify para interactuar con un bucket de Amazon S3 que contiene sus conjuntos de datos de entrada. También puede usar SageMaker Clarify para analizar un modelo de cliente que se implementa en un punto final de inferencia de SageMaker IA.

El siguiente gráfico muestra cómo un trabajo de procesamiento SageMaker de Clarify interactúa con los datos de entrada y, opcionalmente, con un modelo de cliente. Esta interacción depende del tipo específico de análisis que se lleve a cabo. El contenedor SageMaker de procesamiento Clarify obtiene el conjunto de datos de entrada y la configuración para su análisis desde un depósito de S3. Para ciertos tipos de análisis, incluido el análisis de características, el contenedor SageMaker de procesamiento Clarify debe enviar las solicitudes al contenedor modelo. A continuación, recupera las predicciones del modelo a partir de la respuesta que envía el contenedor de modelos. Después, el contenedor de SageMaker procesamiento Clarify calcula y guarda los resultados del análisis en el depósito de S3.

Puede ejecutar un trabajo de procesamiento SageMaker de Clarify en varias etapas del ciclo de vida del flujo de trabajo de aprendizaje automático. SageMaker Clarify puede ayudarle a calcular los siguientes tipos de análisis:

-

Métricas de sesgo previas al entrenamiento. Estas métricas pueden ayudarle a entender el sesgo de sus datos para poder abordarlo y adaptar su modelo a un conjunto de datos más justo. Consulte Métricas de sesgo previas al entrenamiento para obtener más información sobre las métricas de sesgo previas al entrenamiento. Para analizar las métricas de sesgo previas al entrenamiento, debe proporcionar el conjunto de datos y un archivo de configuración de análisis JSON a Archivos de configuración del análisis.

-

Métricas de sesgo posteriores al entrenamiento. Estas métricas pueden ayudarte a entender cualquier sesgo introducido por un algoritmo, las opciones de hiperparámetros o cualquier sesgo que no fuera evidente al principio del flujo. Para obtener más información sobre las métricas de sesgo posteriores al entrenamiento, consulteMétricas del sesgo de los datos y el modelo posterior al entrenamiento. SageMaker Clarify utiliza las predicciones del modelo además de los datos y las etiquetas para identificar el sesgo. Para analizar las métricas de sesgo posteriores al entrenamiento, debe proporcionar el conjunto de datos y un archivo de configuración de análisis JSON. La configuración debe incluir el nombre del modelo o del punto de conexión.

-

Los valores de Shapley, que pueden ayudarle a comprender el impacto que tiene su característica en lo que predice el modelo. Para obtener más información acerca de los valores de Shapley, consulte Atribuciones de características que utilizan valores Shapley. Esta característica requiere un modelo entrenado.

-

Gráficas de dependencia parcial (PDPs), que pueden ayudarle a comprender en qué medida cambiaría la variable objetivo prevista si cambiara el valor de una entidad. Para obtener más información PDPs, consulte Análisis de gráficas de dependencia parcial (PDPs) Esta función requiere un modelo entrenado.

SageMaker Clarify necesita modelar las predicciones para calcular las métricas de sesgo y las atribuciones de características posteriores al entrenamiento. Puedes proporcionar un punto final o SageMaker Clarify creará un punto final efímero con el nombre de tu modelo, también conocido como punto final oculto. El contenedor SageMaker Clarify elimina el punto final oculto una vez finalizados los cálculos. En un nivel superior, el contenedor SageMaker Clarify completa los siguientes pasos:

-

Valida las entradas y los parámetros.

-

Crea el punto de conexión de sombra (si se proporciona un nombre de modelo).

-

Carga el conjunto de datos de entrada en un marco de datos.

-

Obtiene las predicciones del modelo desde el punto de conexión, si es necesario.

-

Calcula las métricas de sesgo y las atribuciones de características.

-

Elimina el punto de conexión de sombra.

-

Genera los resultados del análisis.

Una vez finalizado SageMaker el trabajo de procesamiento de Clarify, los resultados del análisis se guardarán en la ubicación de salida que haya especificado en el parámetro de salida de procesamiento del trabajo. Estos resultados incluyen un archivo JSON con métricas de sesgo y atribuciones de características globales, un informe visual y archivos adicionales para las atribuciones de características locales. Puede descargar los resultados desde la ubicación de salida y verlos.

Para obtener más información sobre las métricas de sesgo, la explicabilidad y cómo interpretarlas, consulte Descubra cómo Amazon SageMaker Clarify ayuda a detectar el sesgo

Cuadernos de ejemplo

En las siguientes secciones se incluyen libretas que le ayudarán a empezar a utilizar SageMaker Clarify, a utilizarla para tareas especiales, incluidas las relacionadas con un trabajo distribuido, y para la visión artificial.

Introducción

Los siguientes cuadernos de muestra muestran cómo usar SageMaker Clarify para comenzar con las tareas de explicabilidad y modelar los sesgos. Estas tareas incluyen la creación de un trabajo de procesamiento, el entrenamiento de un modelo de machine learning (ML) y la supervisión de las predicciones del modelo:

-

Explicabilidad y detección de sesgos con Amazon SageMaker Clarify

: utilice SageMaker Clarify para crear un trabajo de procesamiento que detecte sesgos y explique las predicciones del modelo. -

Supervisión de la desviación de sesgo y la desviación de la atribución de características Amazon SageMaker Clarify

: utilice Amazon SageMaker Model Monitor para supervisar la desviación de sesgo y la desviación de la atribución de características a lo largo del tiempo. -

Cómo leer un conjunto de datos en formato JSON Lines en

un trabajo de procesamiento de SageMaker Clarify. -

Mitigue el sesgo, entrene otro modelo imparcial y colóquelo en el registro de modelos: utilice la

técnica de sobremuestreo de minorías sintéticas (SMOTE) y SageMaker Clarify para mitigar el sesgo, entrene otro modelo y, a continuación, coloque el nuevo modelo en el registro de modelos. Este ejemplo de cuaderno también muestra cómo colocar los nuevos artefactos del modelo, incluidos los datos, el código y los metadatos del modelo, en el registro del modelo. Este cuaderno forma parte de una serie que muestra cómo integrar SageMaker Clarify en un proceso de SageMaker IA, tal como se describe en The Architect, y cómo desarrollar todo el ciclo de vida del aprendizaje automático con AWS una entrada de blog.

Casos especiales

Los siguientes cuadernos muestran cómo usar un SageMaker Clarify para casos especiales, incluso si está dentro de su propio contenedor, y para tareas de procesamiento del lenguaje natural:

-

Imparcialidad y explicabilidad con SageMaker Clarify (traiga su propio contenedor)

: cree su propio modelo y contenedor que pueda integrarse con SageMaker Clarify para medir los sesgos y generar un informe de análisis de explicabilidad. En este ejemplo de bloc de notas también se presentan los términos clave y se muestra cómo acceder al informe a través de Studio Classic. SageMaker -

Imparcialidad y explicabilidad con el procesamiento distribuido de SageMaker Clarify Spark

: utilice el procesamiento distribuido para ejecutar un trabajo de SageMaker Clarify que mida el sesgo previo al entrenamiento de un conjunto de datos y el sesgo posterior al entrenamiento de un modelo. Este ejemplo de cuaderno también muestra cómo obtener una explicación de la importancia de las funciones de entrada en la salida del modelo y cómo acceder al informe del análisis de explicabilidad a través de Studio Classic. SageMaker -

Explicabilidad con SageMaker Clarify: gráficos de dependencia parcial (PDP)

: utilice SageMaker Clarify para generar un informe de explicabilidad del modelo PDPs y acceder a él. -

Explicación del análisis del sentimiento textual mediante SageMaker Clarify La explicabilidad del procesamiento del lenguaje natural (PNL)

: utilice Clarify para el análisis del sentimiento textual. SageMaker -

Use la explicabilidad de la visión artificial (CV) para la clasificación de imágenes

y la detección de objetos

Se ha comprobado que estos blocs de notas funcionan en Amazon SageMaker Studio Classic. Si necesita instrucciones sobre cómo abrir un cuaderno en Studio Classic, consulte Crear o abrir un bloc de notas Amazon SageMaker Studio Classic. Si se le pide que elija un kernel, elija Python 3 (ciencia de datos).