Le traduzioni sono generate tramite traduzione automatica. In caso di conflitto tra il contenuto di una traduzione e la versione originale in Inglese, quest'ultima prevarrà.

Quando esegui una query sui dati da Athena o Amazon Redshift, il set di dati interrogato viene automaticamente archiviato nel bucket AI S3 SageMaker predefinito per AWS la regione in cui utilizzi Studio Classic. Inoltre, quando esporti un notebook Jupyter da Amazon SageMaker Data Wrangler e lo esegui, i tuoi flussi di dati, o file.flow, vengono salvati nello stesso bucket predefinito, con il prefisso data_wrangler_flows.

Per esigenze di sicurezza di alto livello, puoi configurare una policy sui bucket che limiti i ruoli che hanno accesso a questo bucket AI S3 predefinito. AWS SageMaker Utilizza la sezione seguente per aggiungere questo tipo di policy a un bucket S3. Per seguire le istruzioni in questa pagina, usa (). AWS Command Line Interface AWS CLI Per scoprire come, consulta Configurazione della AWS CLI nella Guida per l'utente IAM.

Inoltre, devi concedere a ogni ruolo IAM che utilizza Data Wrangler le autorizzazioni per accedere alle risorse richieste. Se non hai bisogno di autorizzazioni granulari per il ruolo IAM che utilizzi per accedere a Data Wrangler, puoi aggiungere la policy gestita da IAM a un ruolo IAM che utilizzi per creare il tuo utente Studio Classic. AmazonSageMakerFullAccess

Aggiungi una policy sui bucket per limitare l'accesso ai set di dati importati in Data Wrangler

Puoi aggiungere una policy al bucket S3 che contiene le tue risorse Data Wrangler utilizzando una policy di bucket Amazon S3. Le risorse che Data Wrangler carica nel tuo bucket SageMaker AI S3 predefinito nella AWS regione in cui utilizzi Studio Classic includono quanto segue:

-

Risultati di query di Amazon Redshift. Questi vengono memorizzati con il prefisso redshift/.

-

Risultati di query Athena. Questi vengono memorizzati con il prefisso athena/.

-

I file .flow caricati su Amazon S3 quando esegui un notebook Jupyter esportato prodotto da Data Wrangler. Questi vengono memorizzati con il prefisso data_wrangler_flows/.

Utilizza la seguente procedura per creare una policy per i bucket S3 che puoi aggiungere per limitare l'accesso dei ruoli IAM a quel bucket. Per informazioni su come aggiungere una policy a un bucket S3, consulta In che modo aggiungere una policy del bucket S3?.

Per impostare una policy sui bucket S3 che memorizza le risorse di Data Wrangler:

-

Configura uno o più ruoli IAM per consentire l'accesso a Data Wrangler.

-

Apri un prompt dei comandi una shell. Per ogni ruolo che crei, sostituiscilo

role-namecon il nome del ruolo ed esegui quanto segue:$ aws iam get-role --role-namerole-nameNella risposta, viene visualizzata una stringa

RoleIdche inizia conAROA. Copia questa stringa. -

Aggiungi la seguente policy al bucket SageMaker AI predefinito nella AWS regione in cui utilizzi Data Wrangler. Sostituiscilo

regioncon la AWS regione in cui si trova il bucket eaccount-idcon l'ID del tuo account. AWS SostituisciuserIds iniziandoAROAEXAMPLEIDcon il nome IDs di un AWS ruolo a cui desideri concedere l'autorizzazione all'uso di Data Wrangler.{ "Version": "2012-10-17", "Statement": [ { "Effect": "Deny", "Principal": "*", "Action": "s3:*", "Resource": [ "arn:aws:s3:::sagemaker-region-account-id/data_wrangler_flows/", "arn:aws:s3:::sagemaker-region-account-id/data_wrangler_flows/*", "arn:aws:s3:::sagemaker-region-account-id/athena", "arn:aws:s3:::sagemaker-region-account-id/athena/*", "arn:aws:s3:::sagemaker-region-account-id/redshift", "arn:aws:s3:::sagemaker-region-account-id/redshift/*" ], "Condition": { "StringNotLike": { "aws:userId": [ "AROAEXAMPLEID_1:*", "AROAEXAMPLEID_2:*" ] } } } ] }

Crea un elenco di consentiti per Data Wrangler

Ogni volta che un utente inizia a eseguire Data Wrangler dall'interfaccia utente di Amazon SageMaker Studio Classic, effettua una chiamata all'API (Application Programming Interface) SageMaker AI per creare un'applicazione Data Wrangler.

La tua organizzazione potrebbe non fornire ai tuoi utenti le autorizzazioni per effettuare tali chiamate API per impostazione predefinita. Per fornire le autorizzazioni, devi creare e collegare una policy ai ruoli IAM dell'utente utilizzando il seguente modello di policy: Esempio dell’elenco dei consentiti di Data Wrangler

Nota

L'esempio di policy precedente consente agli utenti di accedere solo all'applicazione Data Wrangler.

Per informazioni sulla creazione di una policy, consulta Creazione di policy nella scheda JSON. Quando crei una policy, copia e incolla la policy JSON dall’Esempio dell’elenco di consentiti di Data Wrangler

Importante

Elimina tutte le policy IAM che impediscono agli utenti di eseguire le seguenti operazioni:

Se non elimini le policy, i tuoi utenti potrebbero comunque risentirne.

Dopo aver creato la policy utilizzando il modello, collegala ai ruoli IAM dei tuoi utenti. Per informazioni sul collegamento di una policy, consulta Aggiunta di autorizzazioni di identità IAM (console).

Concedi un'autorizzazione al ruolo IAM per utilizzare Data Wrangler

Puoi concedere a un ruolo IAM l'autorizzazione a utilizzare Data Wrangler con la policy gestita generale di IAM, AmazonSageMakerFullAccessAmazonSageMakerFullAccess per concedere l'accesso a Data Wrangler, è necessario essere a conoscenza di quanto segue:

-

Se importi dati da Amazon Redshift, il nome dell’Utente del database deve avere il prefisso

sagemaker_access. -

Questa policy gestita concede solo l'autorizzazione ad accedere ai bucket con uno dei seguenti nomi nel nome:

SageMaker AI,SageMaker AI,sagemakeroaws-glue. Se desideri utilizzare Data Wrangler per importare da un bucket S3 senza queste frasi nel nome, consulta l'ultima sezione di questa pagina per scoprire come concedere l'autorizzazione a un'entità IAM per accedere ai tuoi bucket S3.

Se hai esigenze di sicurezza elevate, puoi collegare le policy di questa sezione a un'entità IAM per concedere le autorizzazioni necessarie per utilizzare Data Wrangler.

Se hai set di dati in Amazon Redshift o Athena che un ruolo IAM deve importare da Data Wrangler, devi aggiungere una policy a quell'entità per accedere a queste risorse. Le seguenti policy sono le policy più restrittive che puoi utilizzare per autorizzare un ruolo IAM a importare dati da Amazon Redshift e Athena.

Per informazioni su come collegare una policy personalizzata a un ruolo IAM, consulta Gestione delle policy IAM nella Guida per l'utente IAM.

Esempio di policy per concedere l'accesso all'importazione di un set di dati Athena

La seguente policy presuppone che il ruolo IAM disponga dell'autorizzazione ad accedere al bucket S3 sottostante in cui i dati vengono archiviati tramite una policy IAM separata.

{

"Version": "2012-10-17",

"Statement": [

{

"Effect": "Allow",

"Action": [

"athena:ListDataCatalogs",

"athena:ListDatabases",

"athena:ListTableMetadata",

"athena:GetQueryExecution",

"athena:GetQueryResults",

"athena:StartQueryExecution",

"athena:StopQueryExecution"

],

"Resource": [

"*"

]

},

{

"Effect": "Allow",

"Action": [

"glue:CreateTable"

],

"Resource": [

"arn:aws:glue:*:*:table/*/sagemaker_tmp_*",

"arn:aws:glue:*:*:table/sagemaker_featurestore/*",

"arn:aws:glue:*:*:catalog",

"arn:aws:glue:*:*:database/*"

]

},

{

"Effect": "Allow",

"Action": [

"glue:DeleteTable"

],

"Resource": [

"arn:aws:glue:*:*:table/*/sagemaker_tmp_*",

"arn:aws:glue:*:*:catalog",

"arn:aws:glue:*:*:database/*"

]

},

{

"Effect": "Allow",

"Action": [

"glue:GetDatabases",

"glue:GetTable",

"glue:GetTables"

],

"Resource": [

"arn:aws:glue:*:*:table/*",

"arn:aws:glue:*:*:catalog",

"arn:aws:glue:*:*:database/*"

]

},

{

"Effect": "Allow",

"Action": [

"glue:CreateDatabase",

"glue:GetDatabase"

],

"Resource": [

"arn:aws:glue:*:*:catalog",

"arn:aws:glue:*:*:database/sagemaker_featurestore",

"arn:aws:glue:*:*:database/sagemaker_processing",

"arn:aws:glue:*:*:database/default",

"arn:aws:glue:*:*:database/sagemaker_data_wrangler"

]

}

]

}Esempio di policy per concedere l'accesso all'importazione di un set di dati Amazon Redshift

La seguente policy concede l'autorizzazione a configurare una connessione Amazon Redshift a Data Wrangler utilizzando utenti del database che hanno il prefisso sagemaker_access nel nome. Per concedere l'autorizzazione alla connessione utilizzando altri utenti del database, aggiungi altre voci sotto "Resources" alla seguente policy. La seguente policy presuppone che il ruolo IAM disponga dell'autorizzazione ad accedere al bucket S3 sottostante in cui i dati vengono archiviati tramite una policy IAM separata, se applicabile.

{

"Version": "2012-10-17",

"Statement": [

{

"Effect": "Allow",

"Action": [

"redshift-data:ExecuteStatement",

"redshift-data:DescribeStatement",

"redshift-data:CancelStatement",

"redshift-data:GetStatementResult",

"redshift-data:ListSchemas",

"redshift-data:ListTables"

],

"Resource": [

"*"

]

},

{

"Effect": "Allow",

"Action": [

"redshift:GetClusterCredentials"

],

"Resource": [

"arn:aws:redshift:*:*:dbuser:*/sagemaker_access*",

"arn:aws:redshift:*:*:dbname:*"

]

}

]

}Policy per concedere a l'accesso a un bucket S3

Se il tuo set di dati è archiviato in Amazon S3, puoi concedere a un ruolo IAM l'autorizzazione ad accedere a questo bucket con una policy simile alla seguente. Questo esempio concede l'accesso programmatico in lettura/scrittura al bucket denominato. test

{ "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Action": ["s3:ListBucket"], "Resource": ["arn:aws:s3:::test"] }, { "Effect": "Allow", "Action": [ "s3:PutObject", "s3:GetObject", "s3:DeleteObject" ], "Resource": ["arn:aws:s3:::test/*"] } ] }

Per importare dati da Athena e Amazon Redshift, devi concedere un'autorizzazione al ruolo IAM per accedere ai seguenti prefissi nel bucket Amazon S3 predefinito nella regione Data Wrangler in AWS cui viene utilizzato:,. athena/ redshift/ Se un bucket Amazon S3 predefinito non esiste già nella AWS regione, devi anche autorizzare il ruolo IAM a creare un bucket in questa regione.

Inoltre, se desideri che il ruolo IAM sia in grado di utilizzare le opzioni di esportazione dei job di Amazon SageMaker Feature Store, Pipelines e Data Wrangler, devi concedere l'accesso al prefisso data_wrangler_flows/ in questo bucket.

Data Wrangler utilizza i prefissi athena/ e redshift/ per archiviare file di anteprima e set di dati importati. Per ulteriori informazioni, consulta Archiviazione di dati importati.

Data Wrangler utilizza il prefisso data_wrangler_flows/ per archiviare i file .flow quando si esegue un notebook Jupyter esportato da Data Wrangler. Per ulteriori informazioni, consulta Esporta.

Utilizza una policy simile alla seguente per concedere le autorizzazioni descritte nei paragrafi precedenti.

{ "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Action": [ "s3:GetObject", "s3:PutObject" ], "Resource": [ "arn:aws:s3:::sagemaker-region-account-id/data_wrangler_flows/", "arn:aws:s3:::sagemaker-region-account-id/data_wrangler_flows/*", "arn:aws:s3:::sagemaker-region-account-id/athena", "arn:aws:s3:::sagemaker-region-account-id/athena/*", "arn:aws:s3:::sagemaker-region-account-id/redshift", "arn:aws:s3:::sagemaker-region-account-id/redshift/*" ] }, { "Effect": "Allow", "Action": [ "s3:CreateBucket", "s3:ListBucket" ], "Resource": "arn:aws:s3:::sagemaker-region-account-id" }, { "Effect": "Allow", "Action": [ "s3:ListAllMyBuckets", "s3:GetBucketLocation" ], "Resource": "*" } ] }

Puoi accedere ai dati nel tuo bucket Amazon S3 anche da un altro AWS account specificando l'URI del bucket Amazon S3. A tale scopo, la policy IAM che concede l'accesso al bucket Amazon S3 nell'altro account dovrebbe utilizzare una policy simile all'esempio seguente, dove BucketFolder è la directory specifica nel bucket dell'utente UserBucket. Questa policy deve essere aggiunta all'utente che concede l'accesso al proprio bucket a un altro utente.

{

"Version": "2012-10-17",

"Statement": [

{

"Effect": "Allow",

"Action": [

"s3:GetObject",

"s3:PutObject",

"s3:PutObjectAcl"

],

"Resource": "arn:aws:s3:::UserBucket/BucketFolder/*"

},

{

"Effect": "Allow",

"Action": [

"s3:ListBucket"

],

"Resource": "arn:aws:s3:::UserBucket",

"Condition": {

"StringLike": {

"s3:prefix": [

"BucketFolder/*"

]

}

}

}

]

}L'utente che accede al bucket (non il proprietario del bucket) deve aggiungere al proprio utente una policy simile all'esempio seguente. Tieni presente che AccountX e TestUser di seguito si riferiscono rispettivamente al proprietario del bucket e al relativo utente.

{

"Version": "2012-10-17",

"Statement": [

{

"Effect": "Allow",

"Principal": {

"AWS": "arn:aws:iam::AccountX:user/TestUser"

},

"Action": [

"s3:GetObject",

"s3:PutObject",

"s3:PutObjectAcl"

],

"Resource": [

"arn:aws:s3:::UserBucket/BucketFolder/*"

]

},

{

"Effect": "Allow",

"Principal": {

"AWS": "arn:aws:iam::AccountX:user/TestUser"

},

"Action": [

"s3:ListBucket"

],

"Resource": [

"arn:aws:s3:::UserBucket"

]

}

]

}Esempio di policy per concedere l'accesso all'uso di AI Studio SageMaker

Utilizza una policy come la seguente per creare un ruolo di esecuzione IAM che può essere utilizzato per configurare un'istanza di Studio Classic.

{

"Version": "2012-10-17",

"Statement": [

{

"Effect": "Allow",

"Action": [

"sagemaker:CreatePresignedDomainUrl",

"sagemaker:DescribeDomain",

"sagemaker:ListDomains",

"sagemaker:DescribeUserProfile",

"sagemaker:ListUserProfiles",

"sagemaker:*App",

"sagemaker:ListApps"

],

"Resource": "*"

}

]

}Snowflake e Data Wrangler

Tutte le autorizzazioni per AWS le risorse sono gestite tramite il ruolo IAM collegato all'istanza di Studio Classic. L'amministratore di Snowflake gestisce le autorizzazioni specifiche di Snowflake, in quanto può concedere autorizzazioni e privilegi granulari a ciascun utente Snowflake. Ciò include database, schemi, tabelle, magazzini e oggetti di integrazione dell’archiviazione. È necessario assicurarsi che le autorizzazioni corrette siano impostate all'esterno di Data Wrangler.

Tieni presente che il comando COPY INTO Amazon S3 Snowflake sposta i dati da Snowflake ad Amazon S3 tramite Internet pubblico per impostazione predefinita, ma i dati in transito sono protetti tramite SSL. I dati a riposo in Amazon S3 sono crittografati con SSE-KMS utilizzando l'impostazione predefinita AWS KMS key.

Per quanto riguarda l’archiviazione delle credenziali Snowflake, Data Wrangler non memorizza le credenziali dei clienti. Data Wrangler utilizza Secrets Manager per archiviare le credenziali in un luogo segreto e ruota i segreti come parte di un piano di sicurezza basato sulle migliori pratiche. L'amministratore di Snowflake o Studio Classic deve assicurarsi che al ruolo di esecuzione di Studio Classic del data scientist sia concessa l'autorizzazione a eseguire l'archiviazione GetSecretValue segreta delle credenziali. Se è già associata al ruolo di esecuzione di Studio Classic, la AmazonSageMakerFullAccess policy dispone delle autorizzazioni necessarie per leggere i segreti creati da Data Wrangler e i segreti creati seguendo le convenzioni di denominazione e tagging riportate nelle istruzioni precedenti. L'accesso ai segreti che non seguono le convenzioni deve essere concesso separatamente. Consigliamo di utilizzare Secrets Manager per impedire la condivisione delle credenziali su canali non protetti; tuttavia, tieni presente che un utente che ha effettuato l'accesso può recuperare la password in testo semplice avviando un terminale o un notebook Python in Studio Classic e quindi richiamando chiamate API dall'API Secrets Manager.

Crittografia dei dati con AWS KMS

All'interno di Data Wrangler, puoi decrittografare i file crittografati e aggiungerli al flusso di Data Wrangler. È inoltre possibile crittografare l'output delle trasformazioni utilizzando una AWS KMS chiave predefinita o una chiave fornita dall'utente.

Puoi importare file se hanno le seguenti caratteristiche:

-

Crittografia lato server

-

SSE-KMS come tipo di crittografia

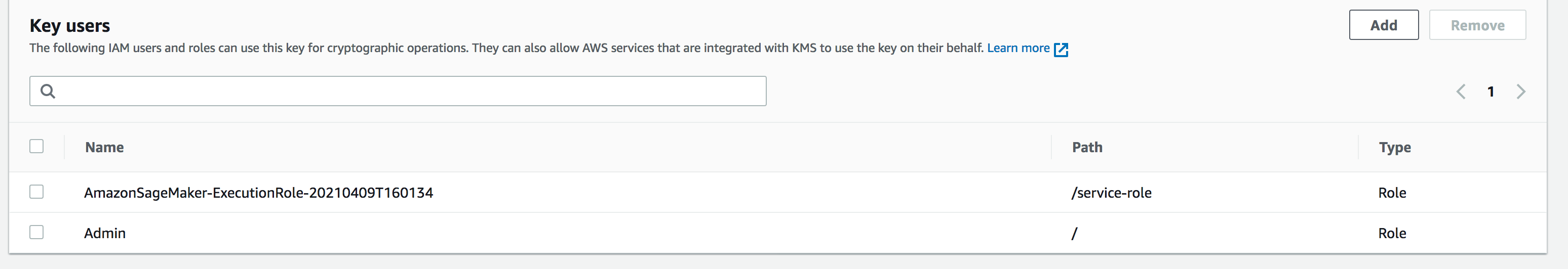

Per decrittografare il file e importarlo in un flusso di Data Wrangler, devi aggiungere l'utente di SageMaker Studio Classic che stai utilizzando come utente chiave.

La schermata seguente mostra un ruolo utente di Studio Classic aggiunto come utente chiave. Consulta Ruoli IAM

Configurazione delle chiavi gestita dal cliente Amazon S3 per l’archiviazione di dati importati da Data Wrangler

Per impostazione predefinita, Data Wrangler utilizza i bucket Amazon S3 con la seguente convenzione di denominazione: sagemaker-region-account number. Per esempio, se il tuo numero di account è 111122223333 e stai utilizzando Studio Classic in us-east-1, i set di dati importati vengono archiviati con la seguente convenzione di denominazione:. sagemaker-us-east-1-111122223333

Le seguenti istruzioni spiegano come configurare una chiave gestita dal cliente per il tuo bucket Amazon S3 predefinito.

-

Per abilitare la crittografia lato server e configurare una chiave gestita dal cliente per il bucket S3 predefinito, consulta Utilizzo della crittografia KMS.

-

Dopo aver seguito il passaggio 1, vai a nel tuo. AWS KMS AWS Management Console Trova la chiave gestita dal cliente che hai selezionato nel passaggio 1 del passaggio precedente e aggiungi il ruolo di Studio Classic come utente chiave. A tale scopo, segui le istruzioni in Consentire agli utenti chiave di utilizzare una chiave gestita dal cliente.

Crittografia dei dati esportati

Puoi crittografare i dati che si esportano utilizzando uno dei seguenti metodi:

-

Specificando che il bucket Amazon S3 ha un oggetto, utilizza la crittografia SSE-KMS.

-

Specificando una AWS KMS chiave per crittografare i dati esportati da Data Wrangler.

Nella pagina Esporta dati, specifica un valore per l'ID chiave AWS KMS o ARN.

Per ulteriori informazioni sull'uso delle AWS KMS chiavi, consulta Protezione dei dati mediante la crittografia lato server con AWS KMS chiavi archiviate in (SSE-KMS). AWSAWS Key Management Service

AppFlow Autorizzazioni Amazon

Quando si esegue un trasferimento, è necessario specificare un ruolo IAM che dispone delle autorizzazioni per eseguire il trasferimento. Puoi utilizzare lo stesso ruolo IAM che dispone delle autorizzazioni per utilizzare Data Wrangler. Per impostazione predefinita, il ruolo IAM che utilizzi per accedere a Data Wrangler è il SageMakerExecutionRole.

Il ruolo IAM deve disporre delle seguenti autorizzazioni:

-

Autorizzazioni per Amazon AppFlow

-

Autorizzazioni per il catalogo dati AWS Glue

-

Autorizzazioni AWS Glue per scoprire le fonti di dati disponibili

Quando esegui un trasferimento, Amazon AppFlow archivia i metadati del trasferimento nel AWS Glue Data Catalog. Data Wrangler utilizza i metadati del catalogo per determinare se è possibile effettuare query e importarli.

Per aggiungere autorizzazioni ad Amazon AppFlow, aggiungi la policy AmazonAppFlowFullAccess AWS

gestita al ruolo IAM. Per ulteriori informazioni sull'aggiunta di policy, consulta Aggiunta o rimozione di autorizzazioni di identità IAM.

Se trasferisci dati su Amazon S3, devi anche collegare la seguente policy.

{

"Version": "2012-10-17",

"Statement": [

{

"Sid": "VisualEditor0",

"Effect": "Allow",

"Action": [

"s3:GetBucketTagging",

"s3:ListBucketVersions",

"s3:CreateBucket",

"s3:ListBucket",

"s3:GetBucketPolicy",

"s3:PutEncryptionConfiguration",

"s3:GetEncryptionConfiguration",

"s3:PutBucketTagging",

"s3:GetObjectTagging",

"s3:GetBucketOwnershipControls",

"s3:PutObjectTagging",

"s3:DeleteObject",

"s3:DeleteBucket",

"s3:DeleteObjectTagging",

"s3:GetBucketPublicAccessBlock",

"s3:GetBucketPolicyStatus",

"s3:PutBucketPublicAccessBlock",

"s3:PutAccountPublicAccessBlock",

"s3:ListAccessPoints",

"s3:PutBucketOwnershipControls",

"s3:PutObjectVersionTagging",

"s3:DeleteObjectVersionTagging",

"s3:GetBucketVersioning",

"s3:GetBucketAcl",

"s3:PutObject",

"s3:GetObject",

"s3:GetAccountPublicAccessBlock",

"s3:ListAllMyBuckets",

"s3:GetAnalyticsConfiguration",

"s3:GetBucketLocation"

],

"Resource": "*"

}

]

}

Per aggiungere AWS Glue autorizzazioni, aggiungi la policy AWSGlueConsoleFullAccess gestita al ruolo IAM. Per ulteriori informazioni sulle AWS Glue autorizzazioni con Amazon AppFlow, consulta [link-to-appflow-page].

Amazon AppFlow deve accedere AWS Glue a Data Wrangler per consentirti di importare i dati che hai trasferito. Per concedere AppFlow l'accesso ad Amazon, aggiungi la seguente policy di fiducia al ruolo IAM.

{

"Version": "2012-10-17",

"Statement": [

{

"Effect": "Allow",

"Principal": {

"AWS": "arn:aws:iam::123456789012:root",

"Service": [

"appflow.amazonaws.com"

]

},

"Action": "sts:AssumeRole"

}

]

}

Per visualizzare i AppFlow dati Amazon in Data Wrangler, aggiungi la seguente policy al ruolo IAM:

{

"Version": "2012-10-17",

"Statement": [

{

"Effect": "Allow",

"Action": "glue:SearchTables",

"Resource": [

"arn:aws:glue:*:*:table/*/*",

"arn:aws:glue:*:*:database/*",

"arn:aws:glue:*:*:catalog"

]

}

]

}

Utilizzo delle configurazioni del ciclo di vita in Data Wrangler

Potresti avere un' EC2 istanza Amazon configurata per eseguire applicazioni Kernel Gateway, ma non l'applicazione Data Wrangler. Le applicazioni Kernel Gateway forniscono l'accesso all'ambiente e ai kernel utilizzati per eseguire notebook e terminali Studio Classic. L'applicazione Data Wrangler è l'applicazione UI che esegue Data Wrangler. EC2 Le istanze Amazon che non sono istanze Data Wrangler richiedono una modifica delle configurazioni del ciclo di vita per eseguire Data Wrangler. Le configurazioni del ciclo di vita sono script di shell che automatizzano la personalizzazione del tuo ambiente Amazon Studio Classic. SageMaker

Per ulteriori informazioni sulle configurazioni del ciclo di vita, consulta Utilizza le configurazioni del ciclo di vita per personalizzare Studio Classic.

La configurazione del ciclo di vita predefinita per l'istanza non supporta l'utilizzo di Data Wrangler. Puoi apportare le seguenti modifiche alla configurazione predefinita per utilizzare Data Wrangler con la tua istanza.

#!/bin/bash set -eux STATUS=$( python3 -c "import sagemaker_dataprep" echo $? ) if [ "$STATUS" -eq 0 ]; then echo 'Instance is of Type Data Wrangler' else echo 'Instance is not of Type Data Wrangler' # Replace this with the URL of your git repository export REPOSITORY_URL="https://github.com/aws-samples/sagemaker-studio-lifecycle-config-examples.git" git -C /root clone $REPOSTIORY_URL fi

Puoi salvare lo script come lifecycle_configuration.sh.

Collega la configurazione del ciclo di vita al tuo dominio o profilo utente di Studio Classic. Per ulteriori informazioni su come creare e collegare una configurazione del ciclo di vita, consulta Creazione e associazione di una configurazione del ciclo di vita.

Le seguenti istruzioni mostrano come collegare una configurazione del ciclo di vita a un dominio o profilo utente di Studio Classic.

È possibile che si verifichino errori durante la creazione o il collegamento di una configurazione del ciclo di vita. Per informazioni sul debugging della configurazione del ciclo di vita, consulta KernelGateway errore dell'app.