Le traduzioni sono generate tramite traduzione automatica. In caso di conflitto tra il contenuto di una traduzione e la versione originale in Inglese, quest'ultima prevarrà.

Amazon SageMaker AI with MLflow è una funzionalità di Amazon SageMaker AI che ti consente di creare, gestire, analizzare e confrontare i tuoi esperimenti di machine learning.

Sperimentazione di machine learning

L'apprendimento automatico è un processo iterativo che richiede la sperimentazione di varie combinazioni di dati, algoritmi e parametri, osservando al contempo il loro impatto sulla precisione del modello. La natura iterativa della sperimentazione di machine learning si traduce in numerose sessioni e versioni di addestramento dei modelli, il che rende difficile tenere traccia dei modelli con le migliori prestazioni e delle relative configurazioni. La complessità della gestione e del confronto dei corsi di formazione iterativi aumenta con l'intelligenza artificiale generativa (IA generativa), dove la sperimentazione implica non solo la messa a punto dei modelli, ma anche l'esplorazione di risultati creativi e diversificati. I ricercatori devono regolare gli iperparametri, selezionare architetture modello adatte e curare diversi set di dati per ottimizzare sia la qualità che la creatività dei contenuti generati. La valutazione dei modelli di intelligenza artificiale generativa richiede metriche sia quantitative che qualitative, aggiungendo un altro livello di complessità al processo di sperimentazione.

MLflow Utilizzala con Amazon SageMaker AI per tracciare, organizzare, visualizzare, analizzare e confrontare la sperimentazione di machine learning iterativa per ottenere informazioni comparative e registrare e distribuire i modelli con le migliori prestazioni.

MLflow integrazioni

Utilizzali MLflow durante la formazione e la valutazione dei modelli per trovare i candidati migliori per il tuo caso d'uso. Puoi confrontare le prestazioni, i parametri e le metriche del modello tra gli esperimenti nell' MLflow interfaccia utente, tenere traccia dei tuoi modelli migliori nel Model Registry, registrarli automaticamente come MLflow modello di SageMaker intelligenza artificiale e distribuire i modelli registrati sugli endpoint di SageMaker intelligenza artificiale.

Amazon SageMaker AI con MLflow

Utilizzalo MLflow per tracciare e gestire la fase di sperimentazione del ciclo di vita dell'apprendimento automatico (ML) con AWS integrazioni per lo sviluppo, la gestione, l'implementazione e il monitoraggio dei modelli.

Amazon SageMaker Studio

Crea e gestisci server di tracciamento, esegui notebook per creare esperimenti e accedi all' MLflow interfaccia utente per visualizzare e confrontare le esecuzioni degli esperimenti in Studio.

SageMaker Registro dei modelli

Gestisci le versioni dei modelli e i modelli di catalogo per la produzione registrando automaticamente i modelli dal MLflow Model Registry al SageMaker Model Registry. Per ulteriori informazioni, consulta Registra automaticamente i modelli SageMaker AI con Model Registry SageMaker .

SageMaker Inferenza AI

Prepara i tuoi modelli migliori per l'implementazione su un endpoint di SageMaker intelligenza artificiale utilizzando. ModelBuilder Per ulteriori informazioni, consulta Distribuisci MLflow modelli con ModelBuilder.

AWS Identity and Access Management

Configura l'accesso all' MLflow utilizzo del controllo degli accessi basato sui ruoli (RBAC) con IAM. Scrivi le policy di identità IAM per autorizzare le chiamate MLflow APIs che possono essere chiamate da un client di un server di tracciamento. MLflow Tutte le MLflow REST APIs sono rappresentate come azioni IAM sotto il prefisso del sagemaker-mlflow servizio. Per ulteriori informazioni, consulta Configura le autorizzazioni IAM per MLflow.

AWS CloudTrail

Visualizza i log in AWS CloudTrail per aiutarti ad abilitare il controllo operativo e dei rischi, la governance e la conformità del tuo account. AWS Per ulteriori informazioni, consulta AWS CloudTrail registri.

Amazon EventBridge

Automatizza la revisione del modello e il ciclo di vita dell'implementazione utilizzando MLflow gli eventi acquisiti da Amazon. EventBridge Per ulteriori informazioni, consulta EventBridge Eventi Amazon.

Supportato Regioni AWS

Amazon SageMaker AI with MLflow è generalmente disponibile in tutte le regioni AWS commerciali in cui è disponibile Amazon SageMaker Studio, ad eccezione delle regioni e AWS GovCloud (US) delle regioni della Cina. SageMaker AI with MLflow è disponibile solo AWS CLI in Europa (Zurigo), Asia Pacifico (Hyderabad), Asia Pacifico (Melbourne) e Canada occidentale (Calgary). Regioni AWS

I server di tracciamento vengono avviati in un'unica zona di disponibilità all'interno della regione specificata.

Come funziona

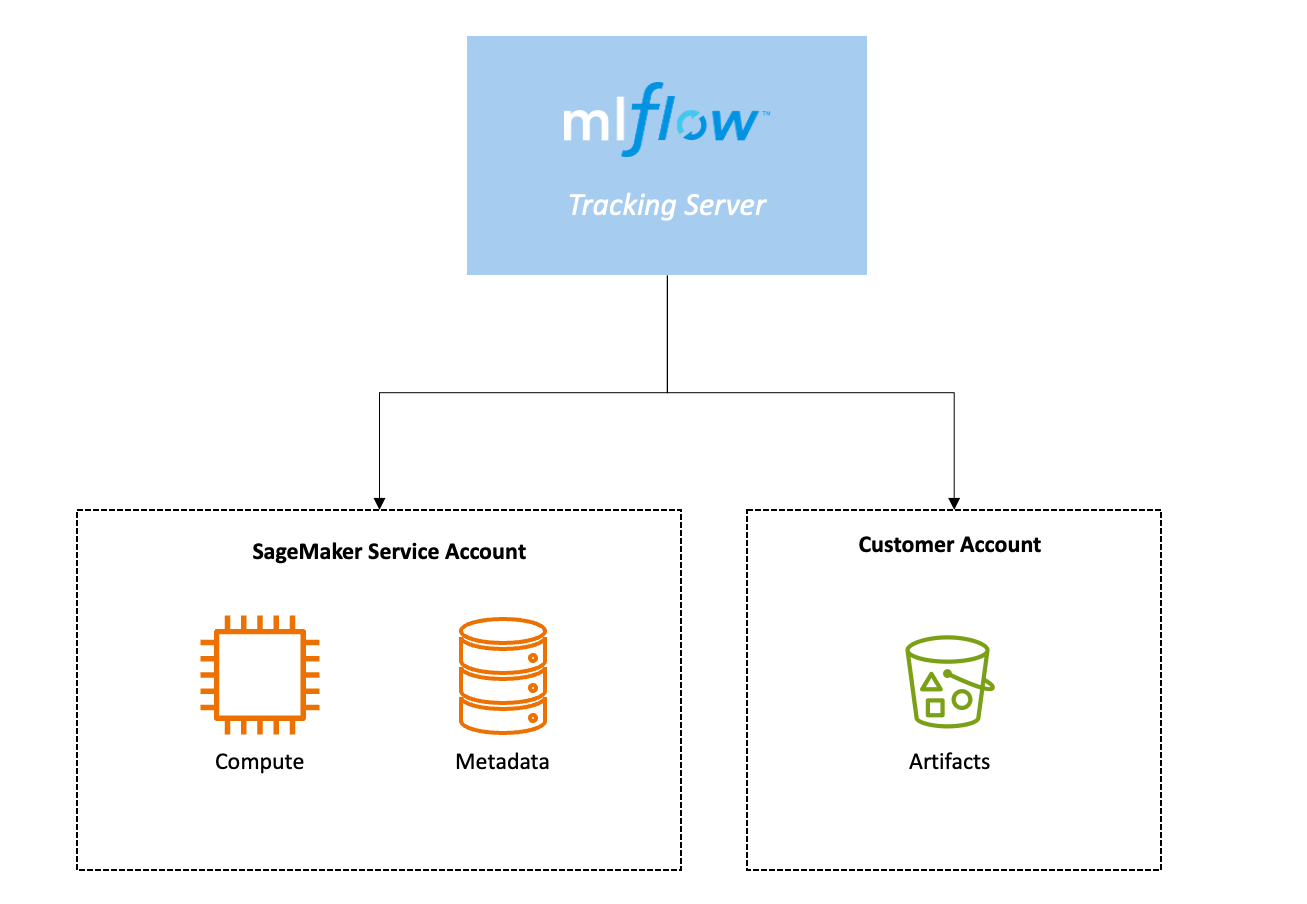

Un server di MLflow tracciamento ha tre componenti principali: elaborazione, archiviazione dei metadati di backend e archiviazione degli artefatti. L'elaborazione che ospita il server di tracciamento e l'archiviazione dei metadati di backend è ospitata in modo sicuro nell'account del servizio AI. SageMaker Lo storage degli artefatti risiede in un bucket Amazon S3 del tuo account. AWS

Un server di tracciamento dispone di un ARN. Puoi usare questo ARN per connettere l' MLflow SDK al tuo server di tracciamento e iniziare a registrare i tuoi allenamenti su. MLflow

Continua a leggere per ulteriori informazioni sui seguenti concetti chiave:

Archiviazione dei metadati nel backend

Quando crei un server di MLflow tracciamento, un archivio di backend

Archiviazione degli artefatti

Per MLflow fornire uno storage persistente per i metadati per ogni esecuzione, come pesi dei modelli, immagini, file di modello e file di dati per le esecuzioni degli esperimenti, devi creare un archivio di artefatti utilizzando Amazon S3. L'artifact store deve essere configurato all'interno del tuo AWS account e devi fornire esplicitamente l'accesso ad Amazon S3 per poter MLflow accedere al tuo negozio di artifact. Per ulteriori informazioni, consulta Artifact

MLflow Dimensioni del server di monitoraggio

Puoi facoltativamente specificare la dimensione del tuo server di tracciamento nell'interfaccia utente di Studio o con il AWS CLI parametro--tracking-server-size. Puoi scegliere tra "Small""Medium", e"Large". La dimensione di configurazione predefinita del server di MLflow tracciamento è"Small". È possibile scegliere una dimensione in base all'uso previsto del server di tracciamento, ad esempio il volume di dati registrati, il numero di utenti e la frequenza di utilizzo.

Consigliamo di utilizzare un server di tracciamento piccolo per team di massimo 25 utenti, un server di tracciamento medio per team fino a 50 utenti e un server di tracciamento grande per team fino a 100 utenti. Partiamo dal presupposto che tutti gli utenti invieranno richieste simultanee al tuo server di MLflow tracciamento per formulare questi consigli. È necessario selezionare la dimensione del server di tracciamento in base al modello di utilizzo previsto e al TPS (Transactions Per Second) supportato da ciascun server di tracciamento.

Nota

La natura del carico di lavoro e il tipo di richieste che effettui al server di tracciamento determinano il TPS che visualizzi.

| Dimensioni del server di tracciamento | TPS sostenuto | TPS Burst |

|---|---|---|

| Small | Fino a 25 | Fino a 50 |

| Media | Fino a 50 | Fino a 100 |

| Large | Fino a 100 | Fino a 200 |

Versioni del server di tracciamento

Le seguenti MLflow versioni sono disponibili per l'uso con l' SageMaker intelligenza artificiale:

| MLflow versione | Versione di Python | SageMaker versione AI |

|---|---|---|

| MLflow 2.16 |

Python 3.8 |

0.1.0 |

| MLflow 2,13 |

Python 3.8 |

0.1.0 |

L'ultima versione del server di tracciamento include le funzionalità, le patch di sicurezza e le correzioni di bug più recenti. Quando crei un nuovo server di tracciamento, ti consigliamo di utilizzare la versione più recente. Per ulteriori informazioni sulla creazione di un server di tracciamento, consultaMLflow Server di tracciamento.

MLflow controllo delle versioni semantiche dei server di tracciamento. Le versioni sono nel seguente formato:. major-version.minor-version.patch-version

Le funzionalità più recenti, come nuovi elementi dell'interfaccia utente e funzionalità API, sono nella versione minore.

AWS CloudTrail registri

AWS CloudTrail registra automaticamente le attività relative al server di MLflow tracciamento. Vengono registrate le seguenti chiamate API: CloudTrail

-

CreateMlflowTrackingServer

-

DescribeMlflowTrackingServer

-

UpdateMlflowTrackingServer

-

DeleteMlflowTrackingServer

-

ListMlflowTrackingServers

-

CreatePresignedMlflowTrackingServer

-

StartMlflowTrackingServer

-

StopMlflowTrackingServer

Per ulteriori informazioni in merito CloudTrail, consulta la Guida per l'AWS CloudTrail utente.

EventBridge Eventi Amazon

Utilizzalo EventBridge per indirizzare gli eventi dall'utilizzo MLflow con l' SageMaker intelligenza artificiale alle applicazioni consumer in tutta l'organizzazione. I seguenti eventi vengono emessi a EventBridge:

-

«Creazione SageMaker del server di tracciamento»

-

«Server SageMaker di tracciamento creato»

-

«Creazione del server di SageMaker tracciamento non riuscita»

-

«Aggiornamento SageMaker del server di tracciamento»

-

«Server SageMaker di tracciamento aggiornato»

-

«Aggiornamento del server di SageMaker tracciamento non riuscito»

-

«Eliminazione del server di SageMaker tracciamento»

-

«Server SageMaker di tracciamento eliminato»

-

«Eliminazione del server di SageMaker tracciamento non riuscita»

-

«Avvio del server di SageMaker tracciamento»

-

«Server SageMaker di tracciamento avviato»

-

«Avvio del server di SageMaker tracciamento non riuscito»

-

«Arresto del server di SageMaker tracciamento»

-

«Server SageMaker di tracciamento interrotto»

-

«Interruzione del server di SageMaker tracciamento non riuscita»

-

«Manutenzione del server di SageMaker monitoraggio in corso»

-

«Manutenzione del server di SageMaker tracciamento completata»

-

«Manutenzione del server di SageMaker tracciamento non riuscita»

-

«Esecuzione della creazione del server di SageMaker MLFlow tracciamento»

-

«Creazione del server di SageMaker MLFlow tracciamento RegisteredModel»

-

«Creazione del server di SageMaker MLFlow tracciamento ModelVersion»

-

« ModelVersion Fase di transizione del server di SageMaker MLFlow tracciamento»

-

«SageMaker MLFlow Il server di tracciamento imposta l'alias del modello registrato»

Per ulteriori informazioni EventBridge, consulta la Amazon EventBridge User Guide.